жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

иҝҷзҜҮж–Үз« з»ҷеӨ§е®¶еҲҶдә«зҡ„жҳҜжңүе…іеҰӮдҪ•и§ЈеҶіTensorflowеҚ з”ЁGPUжҳҫеӯҳзҡ„й—®йўҳзҡ„еҶ…е®№гҖӮе°Ҹзј–и§үеҫ—жҢәе®һз”Ёзҡ„пјҢеӣ жӯӨеҲҶдә«з»ҷеӨ§е®¶еҒҡдёӘеҸӮиҖғпјҢдёҖиө·и·ҹйҡҸе°Ҹзј–иҝҮжқҘзңӢзңӢеҗ§гҖӮ

жҲ‘дҪҝз”ЁPytorchиҝӣиЎҢжЁЎеһӢи®ӯз»ғж—¶еҸ‘зҺ°зңҹжӯЈжЁЎеһӢжң¬иә«еҜ№дәҺжҳҫеӯҳзҡ„еҚ 用并дёҚжҳҺжҳҫпјҢдҪҶжҳҜеҜ№еә”зҡ„иҪ¬жҚўдёәtensorflowеҗҺпјҲжқғйҮҚд№ҹиҝӣиЎҢдәҶиҪ¬жҚўпјүпјҢеҸ‘зҺ°Python-tensorflowеңЁдҪҝз”Ёж—¶й»ҳи®ӨеҗғжҺүжүҖжңүжҳҫеӯҳпјҢ并且дёҚжүӢеҠЁз»Ҳз»“зЁӢеәҸзҡ„иҜқжҳҫеӯҳ并дёҚйҮҠж”ҫпјҲжҲ‘жңүдёӨдёӘеәҸиҙҜзҡ„жЁЎеһӢпјҢеүҚйқўдёҖдёӘи·‘е®ҢеҗҺ并дёҚйҮҠж”ҫеҚ з”ЁжҳҫеӯҳпјүпјҲhttps://github.com/tensorflow/tensorflow/issues/1727пјүпјҢиҝҷдёҖзӮ№еҜ№дәҺеҗҺз»ӯзҡ„е·ҘдҪңжңүеҫҲеӨ§зҡ„еҪұе“ҚгҖӮ

еҗҺйқўеҸ‘зҺ°python-tensorflowйҷҗеҲ¶жҳҫеӯҳжңүдёӨз§Қж–№жі•пјҡ

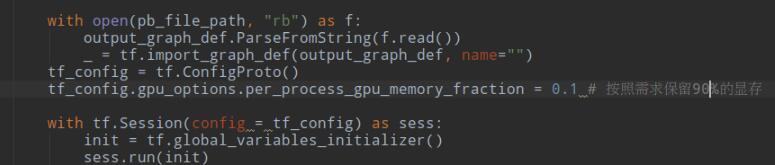

1. и®ҫзҪ®жҳҫеҚЎзҡ„дҪҝз”ЁзҺҮ

иҝҷз§Қж–№жі•еңЁеӯҰд№ е’Ңе·ҘдҪңдёӯжҜ”иҫғеҘҪз”ЁпјҢеӯҰд№ ж—¶еҸҜжҸҗй«ҳжҳҫеҚЎдҪҝз”Ёж•ҲзҺҮпјҢе·ҘдҪңж—¶еҸҜж–№дҫҝзҡ„иҺ·еҫ—GPUжҳҫеӯҳж¶ҲиҖ—жһҒйҷҗпјҢз”Ёд»ҘжҸҗдҫӣжҳҫеҚЎиҙӯд№°ж—¶зҡ„еҸӮж•°пјҢзҺ°е°Ҷд»Јз Ғеұ•зӨәеҰӮдёӢпјҡ

иҝҷйҮҢзҡ„0.1 иЎЁзӨәдҪҝз”ЁжҳҫеӯҳжҖ»йҮҸзҡ„зҡ„10%

2. и®ҫзҪ®жҳҫеҚЎжҢүйңҖдҪҝз”ЁпјҲиҝҷдёӘжң¬дәә并没жңүдё“й—ЁжөӢиҜ•пјҢеҸӘжҳҜд»Һtensorflowи®әеқӣдёҠиҺ·еҫ—пјү

gpu_options = tf.GPUOptions(allow_growth=True) sess = tf.Session(config=tf.ConfigProto(gpu_options=gpu_options))

ж„ҹи°ўеҗ„дҪҚзҡ„йҳ…иҜ»пјҒе…ідәҺвҖңеҰӮдҪ•и§ЈеҶіTensorflowеҚ з”ЁGPUжҳҫеӯҳзҡ„й—®йўҳвҖқиҝҷзҜҮж–Үз« е°ұеҲҶдә«еҲ°иҝҷйҮҢдәҶпјҢеёҢжңӣд»ҘдёҠеҶ…е®№еҸҜд»ҘеҜ№еӨ§е®¶жңүдёҖе®ҡзҡ„её®еҠ©пјҢи®©еӨ§е®¶еҸҜд»ҘеӯҰеҲ°жӣҙеӨҡзҹҘиҜҶпјҢеҰӮжһңи§үеҫ—ж–Үз« дёҚй”ҷпјҢеҸҜд»ҘжҠҠе®ғеҲҶдә«еҮәеҺ»и®©жӣҙеӨҡзҡ„дәәзңӢеҲ°еҗ§пјҒ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ