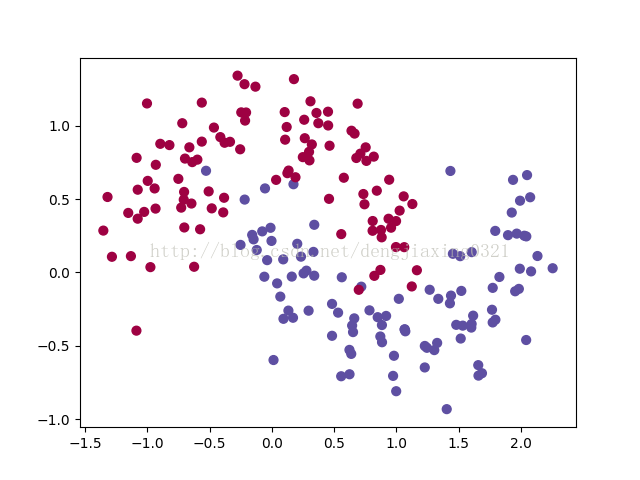

获取数据集,并画图代码如下:

import numpy as np

from sklearn.datasets import make_moons

import matplotlib.pyplot as plt

# 手动生成一个随机的平面点分布,并画出来

np.random.seed(0)

X, y = make_moons(200, noise=0.20)

plt.scatter(X[:,0], X[:,1], s=40, c=y, cmap=plt.cm.Spectral)

plt.show()得到图如下:

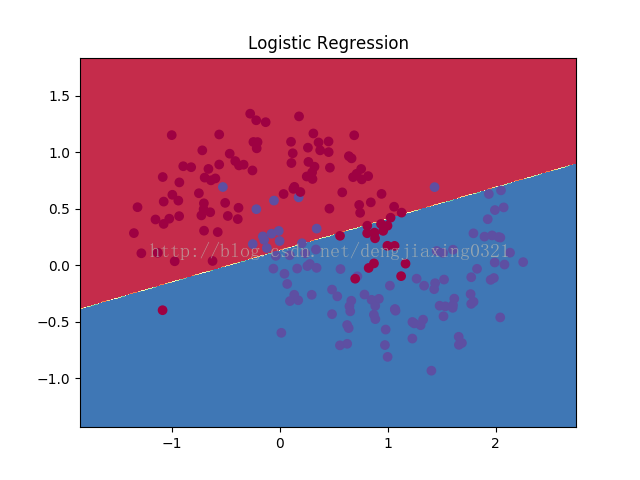

定义决策边界函数:

# 咱们先顶一个一个函数来画决策边界

def plot_decision_boundary(pred_func):

# 设定最大最小值,附加一点点边缘填充

x_min, x_max = X[:, 0].min() - .5, X[:, 0].max() + .5

y_min, y_max = X[:, 1].min() - .5, X[:, 1].max() + .5

h = 0.01

xx, yy = np.meshgrid(np.arange(x_min, x_max, h), np.arange(y_min, y_max, h))

# 用预测函数预测一下

Z = pred_func(np.c_[xx.ravel(), yy.ravel()])

Z = Z.reshape(xx.shape)

# 然后画出图

plt.contourf(xx, yy, Z, cmap=plt.cm.Spectral)

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.Spectral)定义分类函数,并画出决策边界图代码如下:

from sklearn.linear_model import LogisticRegressionCV

#咱们先来瞄一眼逻辑斯特回归对于它的分类效果

clf = LogisticRegressionCV()

clf.fit(X, y)

# 画一下决策边界

plot_decision_boundary(lambda x: clf.predict(x))

plt.title("Logistic Regression")

plt.show()画图如下:

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持亿速云。

亿速云「云服务器」,即开即用、新一代英特尔至强铂金CPU、三副本存储NVMe SSD云盘,价格低至29元/月。点击查看>>

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。