жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

жң¬зҜҮеҶ…е®№д»Ӣз»ҚдәҶвҖңHanLPеҲҶиҜҚеҷЁзҡ„з”Ёжі•вҖқзҡ„жңүе…ізҹҘиҜҶпјҢеңЁе®һйҷ…жЎҲдҫӢзҡ„ж“ҚдҪңиҝҮзЁӢдёӯпјҢдёҚе°‘дәәйғҪдјҡйҒҮеҲ°иҝҷж ·зҡ„еӣ°еўғпјҢжҺҘдёӢжқҘе°ұи®©е°Ҹзј–еёҰйўҶеӨ§е®¶еӯҰд№ дёҖдёӢеҰӮдҪ•еӨ„зҗҶиҝҷдәӣжғ…еҶөеҗ§пјҒеёҢжңӣеӨ§е®¶д»”з»Ҷйҳ…иҜ»пјҢиғҪеӨҹеӯҰжңүжүҖжҲҗпјҒ

еүҚиЁҖпјҡеҲҶжһҗе…ій”®иҜҚ

еҰӮдҪ•еңЁдёҖж®өж–Үжң¬д№ӢдёӯжҸҗеҸ–еҮәзӣёеә”зҡ„е…ій”®иҜҚе‘ўпјҹ

д№ӢеүҚжҲ‘жңүжғіиҝҮз”ЁжңәеҷЁеӯҰд№ зҡ„ж–№жі•жқҘиҝӣиЎҢиҜҚжі•еҲҶжһҗпјҢдҪҶжҳҜеңЁйЎ№зӣ®дёӯжөӢиҜ•ж—¶жӯЈзЎ®зҺҮдёҚеӨҹгҖӮдәҺжҳҜиҝҷж—¶еҖҷдҫҝжңүдәҶ HanLP-жұүиҜӯиЁҖеӨ„зҗҶеҢ… жқҘиҝӣиЎҢжҸҗеҸ–е…ій”®иҜҚзҡ„жғіжі•гҖӮ

дёӢиҪҪпјҡ.jar .properties dataзӯүж–Ү件

иҝҷйҮҢжҸҗдҫӣе®ҳзҪ‘дёӢиҪҪең°еқҖ HanLPдёӢиҪҪпјҢ1.3.3ж•°жҚ®еҢ…дёӢиҪҪ

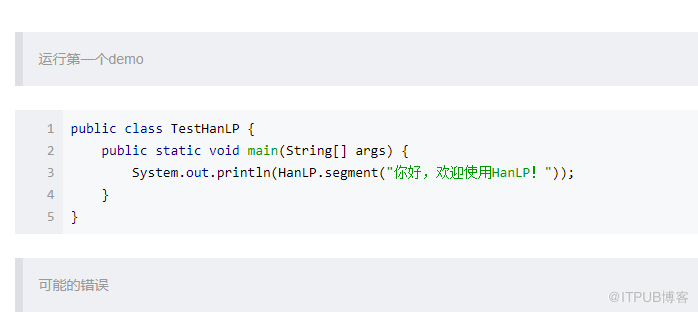

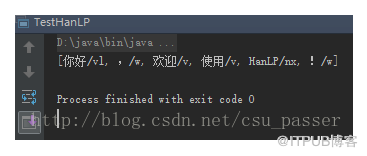

еңЁintellijдёӯй…ҚзҪ®зҺҜеўғпјҢ并иҝҗиЎҢ第дёҖдёӘdemo

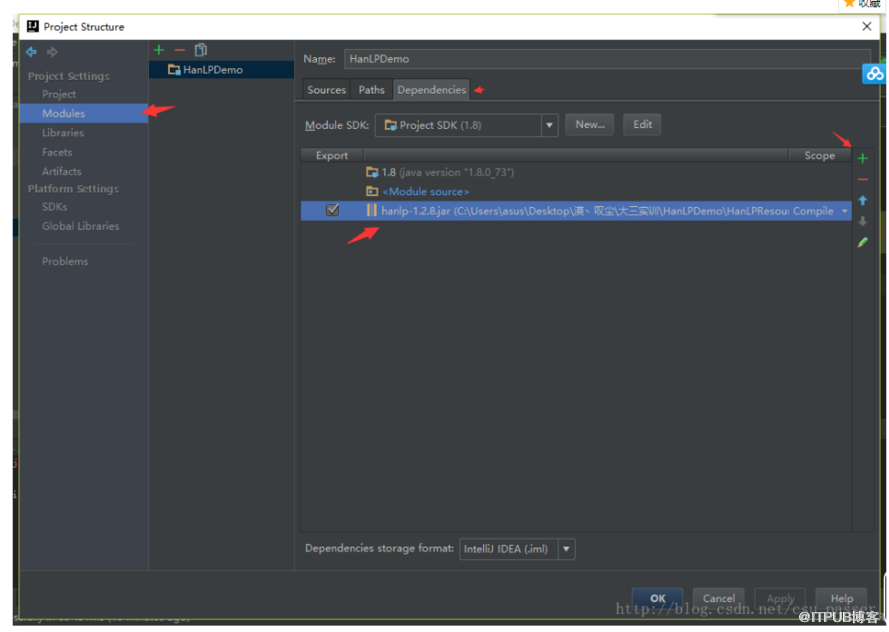

еңЁйЎ№зӣ®дёӯй…ҚзҪ®jarеҢ…пјҢж·»еҠ дҫқиө–гҖӮ

file->Project Structure->Modules->Dependencies->+Jars

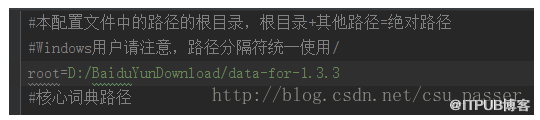

е°Ҷpropertiesж–Ү件иҪ¬з§»еҲ°srcж №зӣ®еҪ•дёӢпјҢдҝ®ж”№rootдёәиҮӘе·ұзҡ„ж•°жҚ®йӣҶи·Ҝеҫ„

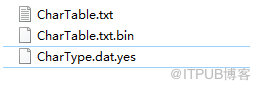

еӯ—з¬Ұзұ»еһӢеҜ№еә”иЎЁеҠ иҪҪеӨұиҙҘпјҡD:/BaiduYunDownload/data-for-1.3.3/data/dictionary/other/CharType.dat.yes

и§ЈеҶіеҠһжі•пјҡжҹҘзңӢй”ҷиҜҜжҸҗзӨәйЎөйқўдёӢжҳҜеҗҰжңүиҜҘж–Ү件пјҢеҰӮжһңжІЎжңүеҲҷеҺ»зҪ‘дёҠдёӢиҪҪдёҖдёӘгҖӮеғҸжҲ‘иҝҷйҮҢпјҢз”ұдәҺеҸӘжҳҜдҪҝз”Ёе…¶дёҖйғЁеҲҶеҠҹиғҪпјҢдёәдәҶж–№дҫҝе°ұдёҚеҶҚдёӢиҪҪдәҶпјҢиҝҷйҮҢжҲ‘зӣҙжҺҘдҝ®ж”№дәҶдёҖдёӘж–Ү件зҡ„ж–Ү件еҗҚвҖ”вҖ“жҲҗеҠҹиҝҗиЎҢпјҒгҖӮ

жҲҗеҠҹиҝҗиЎҢ

---------------------

вҖңHanLPеҲҶиҜҚеҷЁзҡ„з”Ёжі•вҖқзҡ„еҶ…е®№е°ұд»Ӣз»ҚеҲ°иҝҷйҮҢдәҶпјҢж„ҹи°ўеӨ§е®¶зҡ„йҳ…иҜ»гҖӮеҰӮжһңжғідәҶи§ЈжӣҙеӨҡиЎҢдёҡзӣёе…ізҡ„зҹҘиҜҶеҸҜд»Ҙе…іжіЁдәҝйҖҹдә‘зҪ‘з«ҷпјҢе°Ҹзј–е°ҶдёәеӨ§е®¶иҫ“еҮәжӣҙеӨҡй«ҳиҙЁйҮҸзҡ„е®һз”Ёж–Үз« пјҒ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ