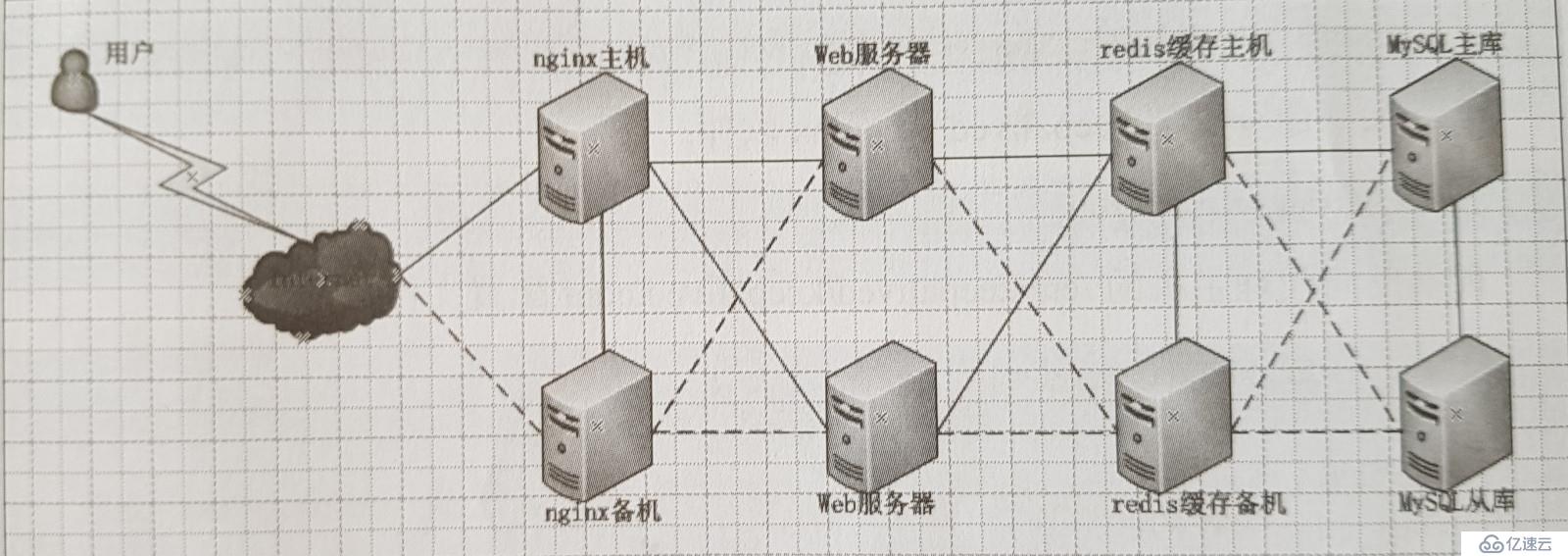

本案例设计采用四层模式实现,主要分为前端反向代理层,web层,数据库缓存层和数据库层。前端反向代理层采用主备模式,web层采用集群模式,数据库缓存层采用主备模式,数据库层采用主从模式。

拓扑图如下。 实线是正常情况下的数据流向连接,虚线是异常情况下的数据流向连接

安装带有nginx rpm软件包的源

rpm -ivh http://nginx.org/packages/centos/7/noarch/RPMS/\

nginx-release-centos-7-0.el7.ngx.noarch.rpm

yum install keepalived nginx -y

vim /etc/keepalived/keepalived.conf

global_defs {

route_id NGINX_HA ##主从服务器的ID不同

}

vrrp_script nginx { ##设置脚本

script "/opt/shell/nginx.sh"

interval 2 ##间隔2秒

}

vrrp_instance VI_1 {

state MASTER ##主为MASTER,从为BACKUP

interface ens33

virtual_router_id 51

priority 100 ##优先级,主的高于从

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

track_script { ##运行脚本

nginx

}

virtual_ipaddress {

192.168.x.x ##设置内网虚拟IP和外网虚拟IP

x.x.x.x

}

}

mkdir /opt/shell

vi /opt/shell/nginx.sh ##创建脚本,此脚本的目的是当keepalived启动的时候,nginx同时启动,且如果不关闭keepalived,nginx同样无法关闭

#!/bin/bash

k=`ps -ef | grep keepalived | grep -v grep | wc -l`

if [ $k -gt 0 ];then

/bin/systemctl start nginx.service

else

/bin/systemctl stop nginx.service

fi

chmod +x /opt/shell/nginx.sh ##给予脚本运行权限

接下来配置NGINX 的调度功能

vim /etc/nginx/nginx.conf

在http中添加

upstream tomcat_pool {

server 192.168.x.x:8080;

server 192.168.x.x:8080; ##两台tomcat的地址

ip_hash; #会话稳固功能,如果不用这条,需要另外做session共享

}

server {

listen 80;

server_name 192.168.x.x; #虚拟IP

location / {

proxy_pass http://tomcat_pool;

proxy_set_header X-Real-IP $remote_addr;

}

}

nginx -t -c /etc/nginx/nginx.conf ##测试配置文件语法

systemctl start keepalived.service ##nginx也会被打开

tar xf apache-tomcat-8.5.23.tar.gz

tar xf jdk-8u144-linux-x64.tar.gz

cp -rv jdk1.8.0_144/ /usr/local/java

vi /etc/profile

export JAVA_HOME=/usr/local/java

export JRE_HOME=/usr/local/java/jre

export PATH=$PATH:/usr/local/java/bin

export CLASSPATH=./:/usr/local/java/lib:/usr/local/java/jre/lib

source /etc/profile ##使系统识别java

输入 java -version 能看到版本号说明完成

cp -r apache-tomcat-8.5.23 /usr/local/tomcat8

ln -s /usr/local/tomcat8/bin/startup.sh /usr/bin/tomcatup ##启动tomcat

ln -s /usr/local/tomcat8/bin/shutdown.sh /usr/bin/tomcatdown ##关闭tomcat

netstat -anpt | grep 8080

## 看到8080 服务开启成功

通过客户端访问 http://192.168.x.x:8080 ##测试默认测试页是否正常显示

vi /usr/local/tomcat8/webapps/ROOT/index.jsp ##修改默认网页内容

输入调度服务器(虚拟IP) 地址,测试两台节点服务器的调度情况。

vim /usr/local/tomcat8/conf/server.xml

在<Host name="localhost" appBase="webapps"

unpackWARs="true" autoDeploy="true">

下插入

<Context path="" docBase="SLSaleSystem" reloadable="true" debug="0"></Context>

##日志调试信息debug为0表示信息越少,docBase指定访问目录

由于是模拟架构,本篇mysql用mariadb代替

yum install -y mariadb-server mariadb

systemctl start mariadb.service

systemctl enable mariadb.service

netstat -anpt | grep 3306

mysql_secure_installation ##常规安全设置

----------导入数据库-----------

mysql -u root -p < xxxx.sql ##导入商城网站数据库

mysql -uroot -p

show databases; ##确定导入成功

GRANT all ON xxxx.* TO 'root'@'%' IDENTIFIED BY 'abc123'; ##给数据库授权

flush privileges; ##刷新数据

----------------以下在两台tomcat节点做----------------

tar xf SLSaleSystem.tar.gz -C

/usr/local/tomcat8/webapps/

cd /usr/local/tomcat8/webapps/SLSaleSystem/WEB-INF/classes

vi jdbc.properties ##修改数据库IP地址是VRRP的虚拟IP,以及授权的用户名root和密码abc123。

------------网站测试------

http://192.168.x.x:8080/ ##默认的用户名admin 密码:123456

http://192.168.x.x ##输入虚拟地址测试登录,并且关闭主再测试登录

yum install redis -y

vi /etc/redis.conf

bind 0.0.0.0 ##修改

systemctl start redis.service

redis-cli -h 192.168.x.x -p 6379 ##测试连接

192.168.x.x:6379> set name test ##设置name 值是test

192.168.x.x:6379> get name ##获取name值

在从服务器上

266 slaveof 192.168.x.x 6379 ##主服务器的IP不是虚拟IP

redis-cli -h 192.168.x.x -p 6379 ##登录从,如能成功获取主上设置的值,说明主从同步成功

192.168.x.x:6379> get name

"test"

-------------配置商城项目中连接redis的参数---

vi /usr/local/tomcat8/webapps/SLSaleSystem/WEB-INF/classes/applicationContext-mybatis.xml

<!--redis 配置 开始-->

<constructor-arg value="192.168.x.x"/> ##虚拟IP

<constructor-arg value="6379"/>

------------以下测试缓存效果-----

redis-cli -h 192.168.x.x -p 6379 ##虚拟IP

192.168.175.188:6379> info

keyspace_hits:1 或者 keyspace_misses:2 ##关注这个值,命中数和未命中数

登录商城,然后反复点击需要数据库参与的操作页面,再回来检查keyspace_hits或者keyspace_misses: 值变化。

---------以下配置redis集群主从切换---只在主服务器是操作--------

vi /etc/redis-sentinel.conf

protected-mode no

sentinel monitor mymaster 192.168.x.x 6379 1 ##1表示1台从 注意:修改

sentinel down-after-milliseconds mymaster 3000 ##故障切换时间单位是毫秒

service redis-sentinel start ##启动集群

netstat -anpt | grep 26379

redis-cli -h 192.168.x.x -p 26379 info Sentinel ##查看集群信息

在主 和 从mysql服务器上

vim /etc/my.cnf

[mysqld]

binlog-ignore-db=mysql,information_schema

character_set_server=utf8

log_bin=mysql_bin

server_id=1 ## 主从服务器的 server_id 不相同

log_slave_updates=true

sync_binlog=1

systemctl restart mysqld

在 主MYSQL上 为 从服务器授予权限

mysql -u root -p

grant replication slave on *.* to 'replication'@'192.168.x.%' identified by '123456';

show master status;

+-------------------+----------+--------------+------------------+

| File | Position | Binlog_Do_DB | Binlog_Ignore_DB |

+-------------------+----------+--------------+------------------+

| master-bin.000002 | 335 | | |

+-------------------+----------+--------------+------------------+

在从服务器上

mysql -u root -p

change master to master_host='192.168.x.x',master_user='replication',master_password='123456',master_log_file='mysql_bin.000002',master_log_pos=335;

start slave;

show slave status \G;

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

## 出现这两条YES 则说明 MYSQL主从复制完成本案例数据库的架构简单了一点,配置文件也是默认的没有经过优化,如果数据库的压力很大,可以考虑优化,也可以使用读写分离架构,或者采用多主多从模式。

亿速云「云服务器」,即开即用、新一代英特尔至强铂金CPU、三副本存储NVMe SSD云盘,价格低至29元/月。点击查看>>

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。