本篇内容介绍了“Pytorch使用tensor特定条件判断索引的方法”的有关知识,在实际案例的操作过程中,不少人都会遇到这样的困境,接下来就让小编带领大家学习一下如何处理这些情况吧!希望大家仔细阅读,能够学有所成!

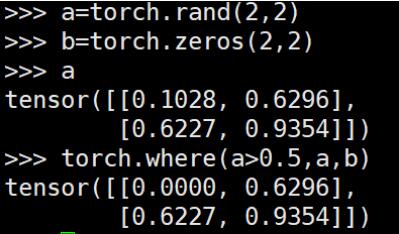

torch.where() 用于将两个broadcastable的tensor组合成新的tensor,类似于c++中的三元操作符“?:”

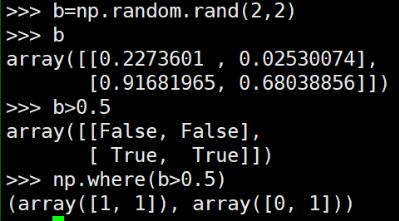

区别于python numpy中的where()直接可以找到特定条件元素的index

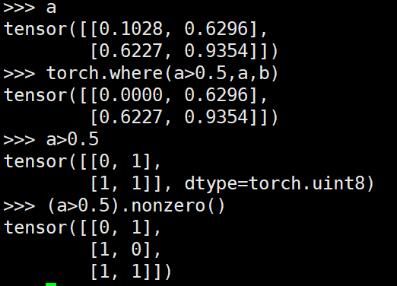

想要实现numpy中where()的功能,可以借助nonzero()

对应numpy中的where()操作效果:

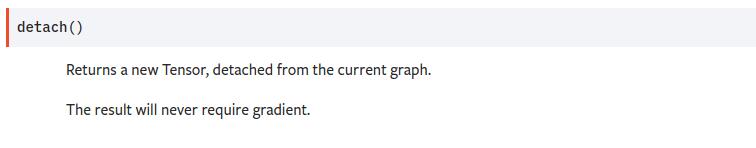

补充:Pytorch torch.Tensor.detach()方法的用法及修改指定模块权重的方法

detach的中文意思是分离,官方解释是返回一个新的Tensor,从当前的计算图中分离出来

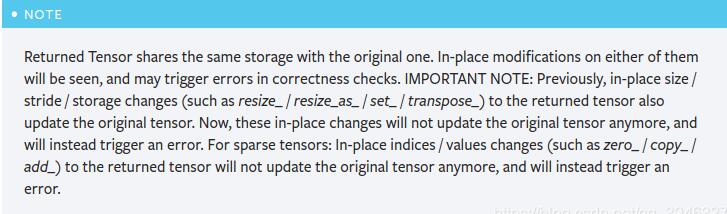

需要注意的是,返回的Tensor和原Tensor共享相同的存储空间,但是返回的 Tensor 永远不会需要梯度

import torch as t a = t.ones(10,) b = a.detach() print(b) tensor([1., 1., 1., 1., 1., 1., 1., 1., 1., 1.])

–假如A网络输出了一个Tensor类型的变量a, a要作为输入传入到B网络中,如果我想通过损失函数反向传播修改B网络的参数,但是不想修改A网络的参数,这个时候就可以使用detcah()方法

a = A(input) a = detach() b = B(a) loss = criterion(b, target) loss.backward()

import torch as t x = t.ones(1, requires_grad=True) x.requires_grad #True y = t.ones(1, requires_grad=True) y.requires_grad #True x = x.detach() #分离之后 x.requires_grad #False y = x+y #tensor([2.]) y.requires_grad #我还是True y.retain_grad() #y不是叶子张量,要加上这一行 z = t.pow(y, 2) z.backward() #反向传播 y.grad #tensor([4.]) x.grad #None

以上代码就说明了反向传播到y就结束了,没有到达x,所以x的grad属性为None

–假如A网络输出了一个Tensor类型的变量a, a要作为输入传入到B网络中,如果我想通过损失函数反向传播修改A网络的参数,但是不想修改B网络的参数,这个时候又应该怎么办了?

这时可以使用Tensor.requires_grad属性,只需要将requires_grad修改为False即可.

for param in B.parameters(): param.requires_grad = False a = A(input) b = B(a) loss = criterion(b, target) loss.backward()

“Pytorch使用tensor特定条件判断索引的方法”的内容就介绍到这里了,感谢大家的阅读。如果想了解更多行业相关的知识可以关注亿速云网站,小编将为大家输出更多高质量的实用文章!

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。