这篇文章给大家分享的是有关数据库中怎么使用batch-import工具向neo4j中导入海量数据的内容。小编觉得挺实用的,因此分享给大家做个参考,一起跟随小编过来看看吧。

1、batch-import原始项目地址:https://github.com/jexp/batch-import

这个工具是neo4j的作者之一Michael Hunger所编写,是在neo4j自带批量导入工具基础之上做的进一步优化,但是它在导入.gz压缩文件时,会出现关系无法导入的情况,所以如果要使用.gz压缩包进行导入,请使用我修改过的版本:https://github.com/mo9527/batch-import

2、环境准备

jdk:7以上

内存:8G以上,导入数据多的话会非常消耗内存,我自己导入的是将近1.5亿节点,3亿关系,用的是32G内存

3、导入步骤

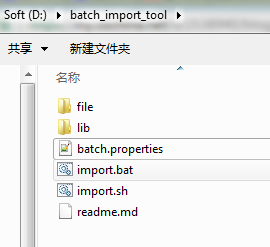

a)从github上clone下代码,并使用maven进行打包,打完包后的jar文件,与项目本身的依赖jar一起放到lib文件夹下,batch.properties文件和执行导入的脚本放在lib同级目录下,***的目录结构如下图:

ps:file文件夹是我自己将要导入的csv文件和.gz压缩包。

b)组装csv文件

说起这一步,可能需要你们根据自己的实际业务需求,手动写代码导csv文件了,这里我只讲一下csv文件格式一些要点:

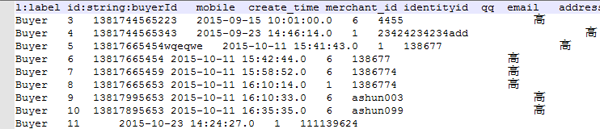

1)、节点csv文件

节点csv文件的***列是固定的,列值为此节点的label名称,第二列是index,它的列头是id:string:indexName 这种格式,解释一下,id是这一列的property名字,可以根据需要自己命名,string为字段的数据类型,indexName是neo4j数据库中将要导入的索引名称,我自己的文件格式如下:

然后,后面的列就是节点的property了,没什么特别的要求

2)、关系csv文件

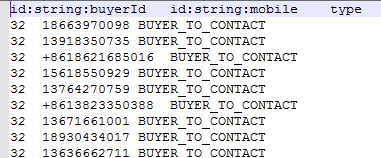

先看下我的关系csv文件:

关系的csv文件前两列要特别注意,***列是关系的起始节点,第二列是关系的结束节点,第三列是关系类型,后面的列是关系的property,可以随意了。他github上的说明没有说出一些注意点,这里要特别标明:

***列的起始节点的列头,也就是id:string:buyerId这个东西,这个玩意一定要和节点csv文件(上图)中定义的一模一样,第二列也是如此,要和结束节点的csv文件里的一样,不然他会找不到对应的关系。

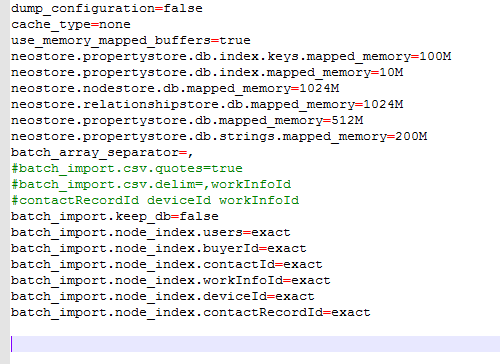

3)、修改batch.properties文件

主要修改两个地方,

如果是在现有的neo4j数据库中进行导入,请设置:

batch_import.keep_db=true

将节点csv文件中所有的索引名称加入到文件中,例如上面这个节点csv文件中的索引名称是buyerId,那就在文件中加入batch_import.node_index.buyerId=exact

以下是我本人的配置文件:

4、导入

linux和win环境的导入都差不多,只不过执行的脚本不一样,这里以win环境为例。

文件都准备好了,现在开始导入了。

打开cmd,cd到导入脚本的目录,也就是import.bat所在目录,执行命令:

import.bat test.db node.csv rel.csv

解释一下命令的几个参数:***个参数是数据库的目录,可以绝对路径指定到任意位置,第二个参数是节点csv文件,多个csv文件用逗号分隔,如果是压缩包,一定要注意,这里有个坑,不能把所有类型的node都放到一个压缩包中,一定要每个类型的node分开压缩,不然它只会导入***个类型的node节点,同理,关系的压缩包也要分开压缩,然后导入时用逗号分隔.gz文件。

好了,如果你的csv文件没有问题,内存足够用的话,现在就开始等待吧。

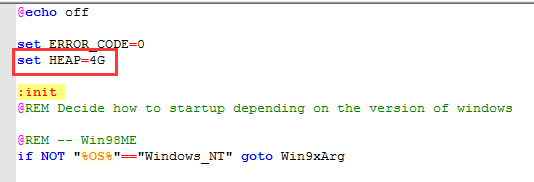

如果想修改导入工具的Heap大小,可以修改脚本文件中的 set HEAP=4G

温馨提示:如果节点文件中有中文的话,导入会非常慢的,除非你内存有128G,我有一个节点文件,里面只有一列是中文,而且中文最长不超过4个汉字,2000多万记录导了2个小时,注意我是32G内存,其他4000多万的节点,没有汉字的,基本上不超过2分钟。

感谢各位的阅读!关于“数据库中怎么使用batch-import工具向neo4j中导入海量数据”这篇文章就分享到这里了,希望以上内容可以对大家有一定的帮助,让大家可以学到更多知识,如果觉得文章不错,可以把它分享出去让更多的人看到吧!

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。