这篇文章主要介绍“Android Camera架构的知识点有哪些”的相关知识,小编通过实际案例向大家展示操作过程,操作方法简单快捷,实用性强,希望这篇“Android Camera架构的知识点有哪些”文章能帮助大家解决问题。

注: 本文流程为Camera API1到HAL1, 代码以及路径都基于高通平台Android 7.1源码, API2到HAL3大体流程和HAL1相近, 但API方面差异很大, 后续再补上.

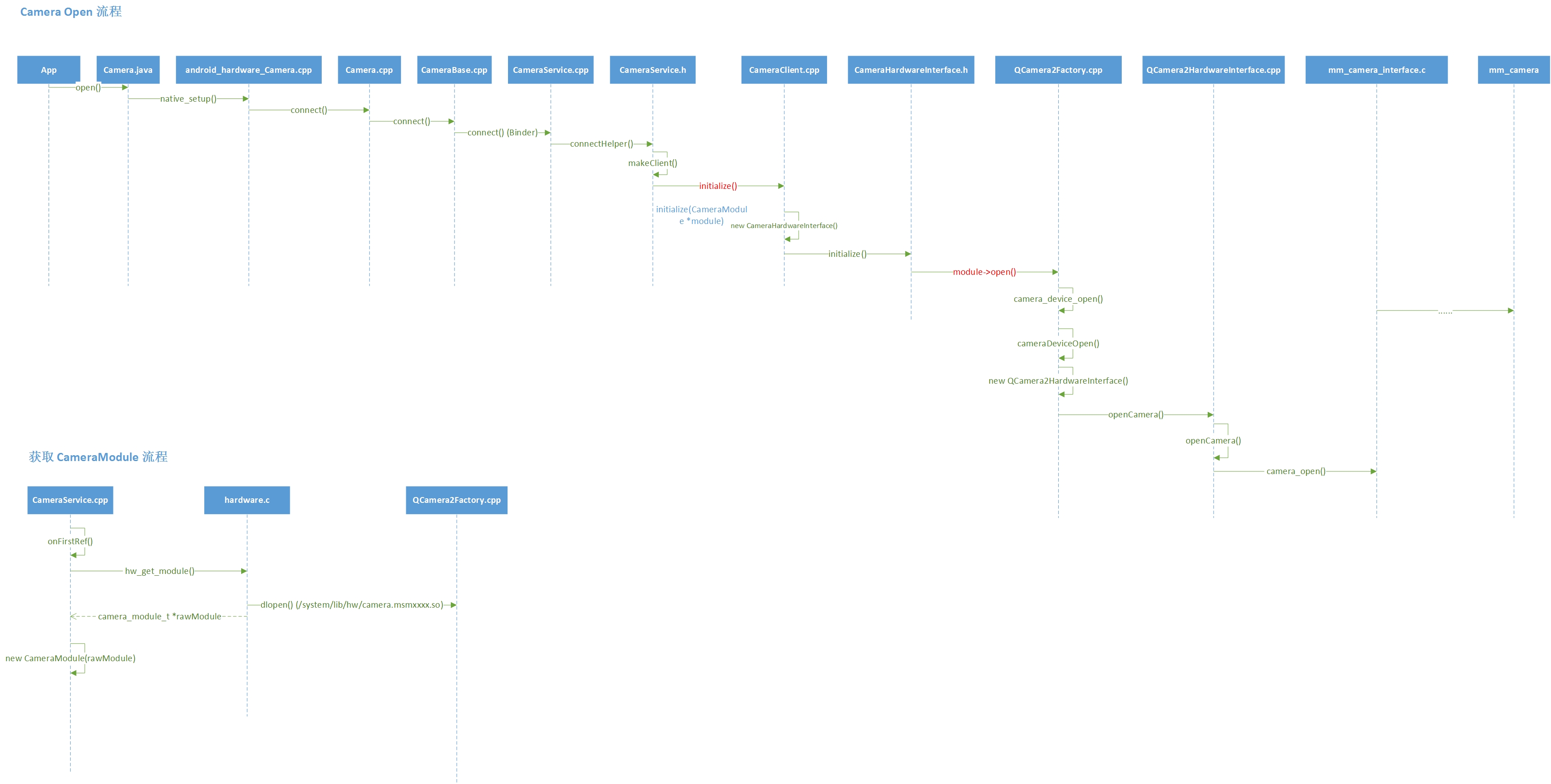

来看下App从调用Camera.open()到HAL层的流程.

温馨提示: 图片太大, 请通过查看原图来进行浏览

frameworks/base/core/java/android/hardware/Camera.java

Camera.java为App直接调用的接口, 编译为framework.jar

frameworks/base/core/jni/android_hardware_Camera.cpp

此部分为Java调用的JNI native部分代码, 编译为动态库 libandroid_runtime.so

frameworks/av/camera/Camera.cpp

frameworks/av/camera/CameraBase.cpp

App连接到CameraService部分的Client, 编译为动态库 libcamera_client

frameworks/av/services/camera/libcameraservice/CameraService.cpp

frameworks/av/services/camera/libcameraservice/CameraService.h

这个就是CameraService的代码了, App通过Binder来连接, 后面会详细讲一下连接过程比较难理解的地方, 编译为动态库 libcameraservice.so

frameworks/av/services/camera/libcameraservice/api1/CameraClient.cpp

这部分就是CameraService端的Client, 用于调用HAL层的接口, 编译后同样在 libcameraservice.so 中.

frameworks/av/services/camera/libcameraservice/device1/CameraHardwareInterface.h

Google定义的HAL接口, 由芯片厂商去实现, 以上代码是Google写的Android系统代码, HAL层及以下则是芯片厂商写的代码,

hardware/qcom/camera/QCamera2/HAL/QCamera2Factory.cpp

高通平台特有代码, 用于创建不同HAL版本的实例, 编译为动态库 camera.xxx.so, xxx代表平台, 比如msm8953则编译为 camera.msm8953.so

hardware/qcom/camera/QCamera2/HAL/QCamera2HWI.cpp

高通HAL的实现代码, 即QCamera2HardwareInterface的缩写, 上图中的QCamera2HardwareInterface.cpp应该为QCamera2HWI.cpp, 由于visio画的图源文件弄丢了, 所以没法改, 但要注意, QCamera2HWI.cpp中定义的类名就是QCamera2HardwareInterface, 此部分代码同样是编译到动态库 camera.xxx.so 中.

hardware/qcom/camera/QCamera2/stack/mm-camera-interface/src/mm_camera_interface.c

高通mm-camera接口, HAL层再往下就是和驱动相关的mm-camera了

vendor/qcom/proprietary/mm-camera/mm-camera2/

高通mm-camera部分代码, 由于我不是做驱动相关的, 对这部分不熟, 就不介绍了, mm-camera往下就是kernel部分了,就相当于到了Android最底层.

hardware/libhardware/hardware.c

此部分代码用来加载Camera的HAL层动态库, 加载之前首先会在几个列出的路径下选择对应的so库, 找到后通过dlopen进行调用, 得到相关的句柄.

上面流程中, 有如下几个点需要注意:

在上图中, CameraService.h中, makeClient()过后, 会调用 CameraClient 的initialize(CameraModule *module)函数, 其中CameraModule实例化则需要camera_module_t *rawModuel作为参数, rawModule则是通过dlopen()方式和HAL层的动态库关联起来(camera.xxx.so), 因此HAL层和CameraService实际是通过dlopen()方式建立联系的, 注意, 上面讲的实例化CameraModuel流程是在开机的时候进行的, 上面的图片中流程中onFirstRef()就是在开机时候调用的.

Client和Service连接过程是我个人认为整个流程中最难理解的部分, 之所以难, 是因为对C++方式实现进程间通信流程不熟悉造成了, 下面就来看下连接过程:

1.首先在Camera.cpp中调用CameraBase.cpp的connect()函数

sp<Camera> Camera::connect(int cameraId, const String16& clientPackageName,int clientUid, int clientPid){return CameraBaseT::connect(cameraId, clientPackageName, clientUid, clientPid);}2.CameraBase.cpp connect()代码

template <typename TCam, typename TCamTraits>sp<TCam> CameraBase<TCam, TCamTraits>::connect(int cameraId, const String16& clientPackageName, int clientUid, int clientPid){ALOGV("%s: connect", __FUNCTION__);sp<TCam> c = new TCam(cameraId);sp<TCamCallbacks> cl = c;const sp<::android::hardware::ICameraService>& cs = getCameraService();binder::Status ret;if (cs != nullptr) {TCamConnectService fnConnectService = TCamTraits::fnConnectService;ret = (cs.get()->*fnConnectService)(cl, cameraId, clientPackageName, clientUid, clientPid, /*out*/ &c->mCamera);}if (ret.isOk() && c->mCamera != nullptr) {IInterface::asBinder(c->mCamera)->linkToDeath(c);c->mStatus = NO_ERROR;} else {ALOGW("An error occurred while connecting to camera %d: %s", cameraId,(cs != nullptr) ? "Service not available" : ret.toString8().string());c.clear();}return c;}此部分代码中要注意两点:

1). TCamTraits::fnConnectService就是ICameraService类中的connect()函数的函数指针, 因为在Camera.cpp中, 其定义如下:

CameraTraits<Camera>::TCamConnectService CameraTraits<Camera>::fnConnectService =&::android::hardware::ICameraService::connect;所以(cs.get()->*fnConnectService)(....)就是在调用CameraService的connect()函数,

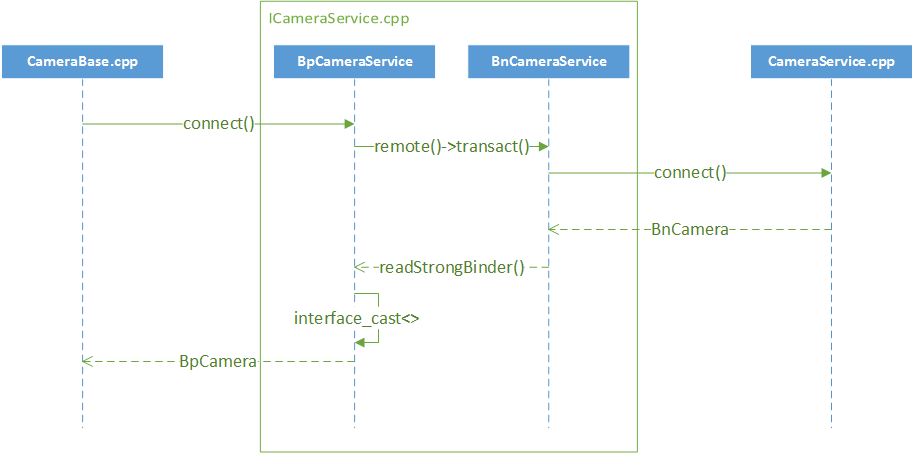

这部分调用也是通过Binder进行的, 流程图如下:

Camera Connect 过程

上面connect过程使用的Binder接口是ICameraService, Connect过程是为了得到ICamera在Client端的BpCamera实例, ICamera接口定义的方法才是具体对Camera进行操作的.

需要特别注意的是, 在Android 7.1的源码中你是找不到ICameraService.cpp源码的, 但在Android 4.4.4中是存在的(framework/av/camera/下面), 这是因为Android 7.1中通过定义了ICameraService.aidl后, 编译过程中会自动生成ICameraService.cpp文件, 生成的文件在Android编译的out目录下:

out/target/product/xxx/obj/SHARED_LIBRARIES/libcamera_client_intermediates/aidl-generated/src/aidl/android/hardware/ICameraService.cpp

注: xxx表示你lunch时选择的product

2). 经过第一步连接过后, 得到了一个ICamera对象指针 mCamera(实际代表BpCamera, 即客户端的接口), 后续我们调用Camera的其他方法, 比如startPreview(), 都是通过mCamera进行调用的.

connect完成后, 后续对camera的调用也是通过Binder进行, 接口定义在ICamera.h, 调用流程和第一步连接的过程一致, 就是Android IPC的基本操作 简而言之 就是 Camera.cpp -> ICamera.cpp(BpCamera) -> ICamera.cpp(BnCamera) -> CameraClient.cpp

这里需要注意的是, CameraClient.cpp是继承自BnCamera的, 这也是为什么在CameraService中的connect()函数中, 可以直接将CameraClient赋值给ICamera

一些继承关系如下:

// CameraService.h 中, Client继承自BnCamera

class Client : public hardware::BnCamera, public BasicClient {...};// CameraClient.h 中, CameraClient继承自Clientclass CameraClient : public CameraService::Client {...};Status CameraService::connect(const sp<ICameraClient>& cameraClient,int cameraId,const String16& clientPackageName,int clientUid,int clientPid,/*out*/sp<ICamera>* device) {//部分代码省略sp<Client> client = nullptr;ret = connectHelper<ICameraClient,Client>(cameraClient, id,CAMERA_HAL_API_VERSION_UNSPECIFIED, clientPackageName, clientUid, clientPid, API_1,/*legacyMode*/ false, /*shimUpdateOnly*/ false,/*out*/client);//部分代码省略/*client代表BnCamera, BpCamera中通过transact调到BnCamera,

然后再调用Client中定义的方法 */*device = client;return ret;}可以看到, 整个过程中主要涉及到两个Binder接口, ICamera和ICameraService, ICamera中的接口用于控制Camera具体操作, 比如设置参数, 打开/关闭预览等等, 而ICameraService中的接口负责连接Camera, 查询Camera信息(getNumberOfCameras() getCameraInfo()).

上面的流程没有说明CameraService是怎么启动的, 我们都知道Android系统的服务都是通过init.rc启动的, CameraService也不例外, 相关代码路径如下:

frameworks/av/camera/cameraserver/

路径下有个cameraserver.rc, 内容如下:

service cameraserver /system/bin/cameraserver

class main

user cameraserver

group audio camera input drmrpc

ioprio rt 4writepid /dev/cpuset/camera-daemon/tasks /dev/stune/top-app/tasks可见启动的是可执行文件cameraserver, 这部分代码就在main_cameraserver.cpp

int main(int argc __unused, char** argv __unused){signal(SIGPIPE, SIG_IGN);sp<ProcessState> proc(ProcessState::self());sp<IServiceManager> sm = defaultServiceManager();ALOGI("ServiceManager: %p", sm.get());CameraService::instantiate();ProcessState::self()->startThreadPool();IPCThreadState::self()->joinThreadPool();}很简单, 就是通过系统接口添加一个Service

从上面分析流程可以看出, Camera的整体代码分为一下几个部分:

Java API, 提供给App调用的接口

JNI, 因为底层和硬件打交道的都是C/C++, 所以JNI必不可少

Camera Client, 此Client通过Binder连接到CameraService

CameraService, 独立的进程, 单独存在, 开机就会启动

CameraService 端的Client, 此Client中通过 CameraHardwareInterface 调用到HAL层

HAL层, 芯片厂实现的部分代码

驱动部分, 包含芯片厂的一些代码和kernel代码

Android中还有很多类似的硬件都是用的这样的架构, 基本是 Java -> JNI -> Service -> HAL -> 驱动, 在阅读源码过程中, 对流程有疑问的时候, 最好的方法是在关键函数打印一些Log, 实际跑下流程, 看看整体架构的调用流程, 了解大体流程后, 根据需要再去抠一些细节, 这样效率会高一些.

关于“Android Camera架构的知识点有哪些”的内容就介绍到这里了,感谢大家的阅读。如果想了解更多行业相关的知识,可以关注亿速云行业资讯频道,小编每天都会为大家更新不同的知识点。

亿速云「云服务器」,即开即用、新一代英特尔至强铂金CPU、三副本存储NVMe SSD云盘,价格低至29元/月。点击查看>>

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。

原文链接:https://my.oschina.net/u/920274/blog/4988843