本篇内容主要讲解“docker在深度学习任务中的应用是什么”,感兴趣的朋友不妨来看看。本文介绍的方法操作简单快捷,实用性强。下面就让小编来带大家学习“docker在深度学习任务中的应用是什么”吧!

Docker是一种容器技术,它就像一个沙盒把应用程序隔离开来,不管有没有遇到过你至少听到某些应用程序不能兼容,最常见的就是升级某个系统,老版本跟新版本不能兼容,必须把老版本完全卸载掉。比如说oracle服务,如果把oracle安装到物理主机上,如果需要升级那将会比较痛苦。再比如说新手学习各种软件,apache、mysql、Python搞的电脑上乱七八糟的环境,想要重新安装都很痛苦。

有没有一种技术能够把这个环境隔离开?有那就是虚拟机,如果你为了一个小服务单独开一个虚拟机是不是太奢侈?这时候docker出现了,docker是一种容器区别于虚拟机,使用docker你可以打包、发布、运行任何应用程序,如果你经常碰到开发环境与生产环境不一致,或者经常需要配置复杂的环境,那你就可以考虑使用它,

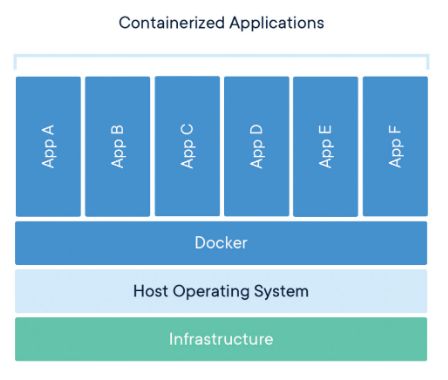

下图是介绍docker运行机制,可以看出应用程序在相互独立的同时,分享物理机的资源

Docker最先是一种开源产品,现在有了社区版和企业版docker-ce与docker-ee。社区版基本已经满足我们。

笔者强烈推荐docker一个原因,那就是可以共享环境,只要有一个人把复杂的环境配置并打包成镜像,类似git一样,commit一个版本,那么其他人就可以直接使用这个环境,而不需要做任何配置,减少人力物力不说,还霸道的使得所有人的生产环境一致。

正是这个原因,我想到了入门机器学习时候,需要配置caffe/tensorflow,并且cuda版本号要对应上,cuda与cudnn版本也要对应上。当时就设想能不能使用docker来解决这个问题,遗憾的是不行,docker无法使用GPU。

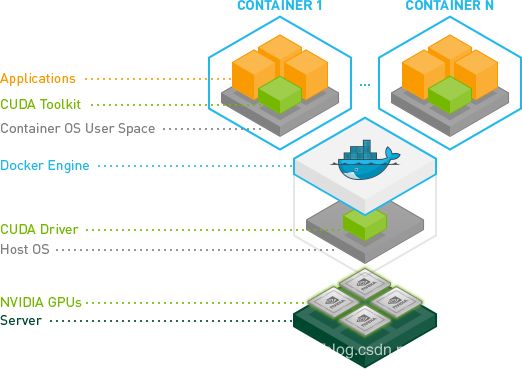

但是办法总比困难多,docker又发布出一个插件nvidia-docker,nvidia-docker是基于docker安装的,可以使得深度学习任务也能隔离开,这就意味着,我可以在一台物理主机上跑各种框架的深度学习任务,环境随机配,你开心就好。唯一的限制就是物理机上的cuda版本号要与docker容器中的cuda版本号一致,我觉得这个要求不过分。

下图是nvidia-docker的运行机制,我们可以看到他们直接的层次结构。应用程序共享GPU,且被隔离开。

安装docker这里不再累赘,官网安装地址:

https://docs.docker.com/install/linux/docker-ce/ubuntu/。

nvidia-docker 安装官网地址:

https://github.com/NVIDIA/nvidia-docker。

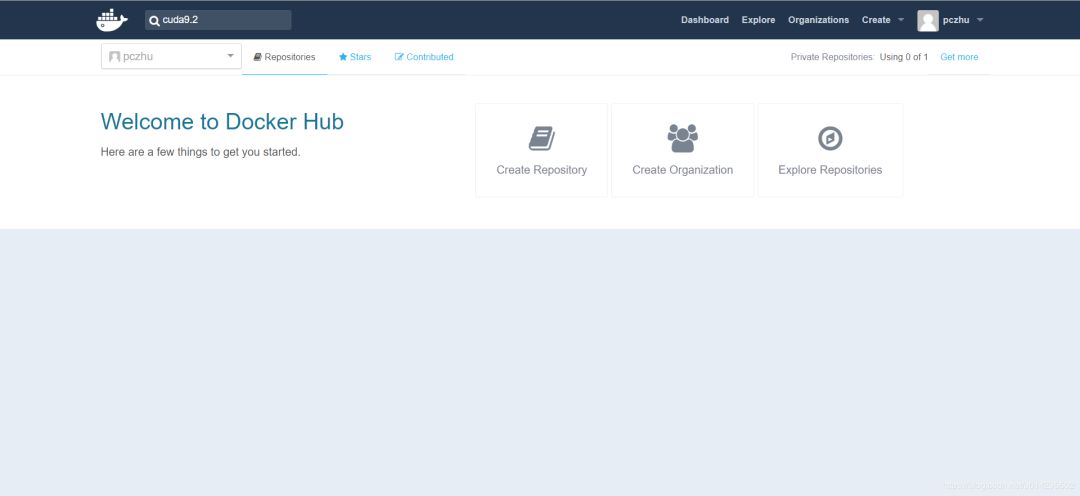

现在我需要一个ubuntu16.04+cuda9.2+cudnn7的开发环境,我可以选择下载镜像再去配置各种驱动,安装cuda、安装cudnn。但是我要秀一下更“懒的方式”。

在docker hub里面查询cuda9.2,找到星星最多的一个镜像

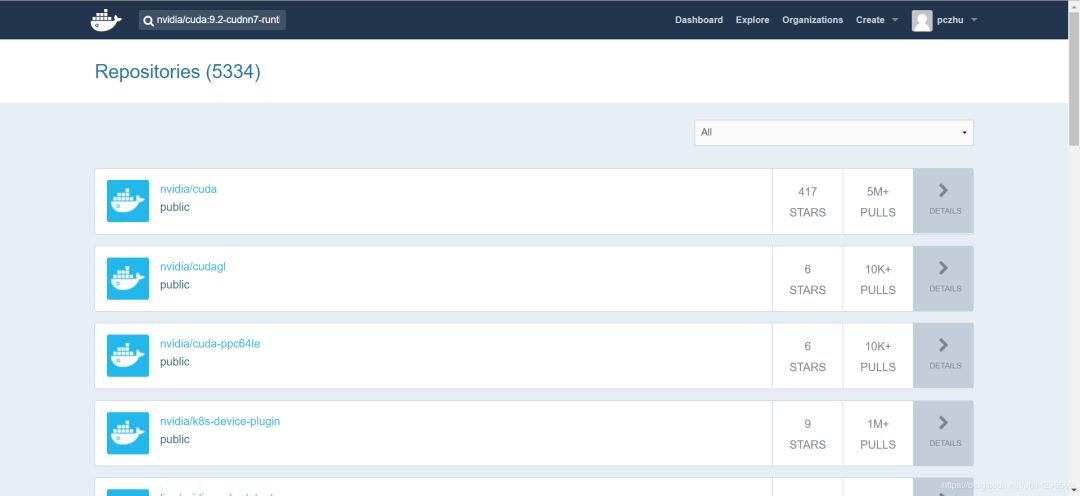

里面很多镜像,我找到一个符合我自己要求的。

拉取镜像:sudo docker pull nvidia/cuda:9.2-cudnn7-runtime-ubuntu16.04

查看拉取的镜像:sudo docker ps

基于这个镜像启动容器:

sudo nvidia-docker run -ti nvidia/cuda:9.2-cudnn7-runtime-ubuntu16.04 bash

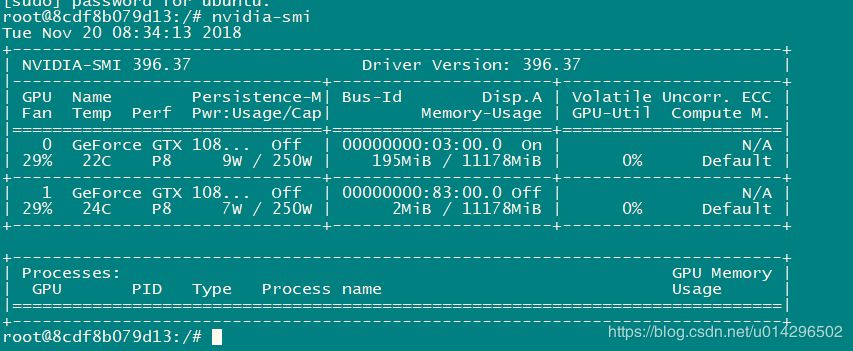

现在我已经进来了,完全就是一个干净的开发环境,等下,看看显卡驱动配置好了没。

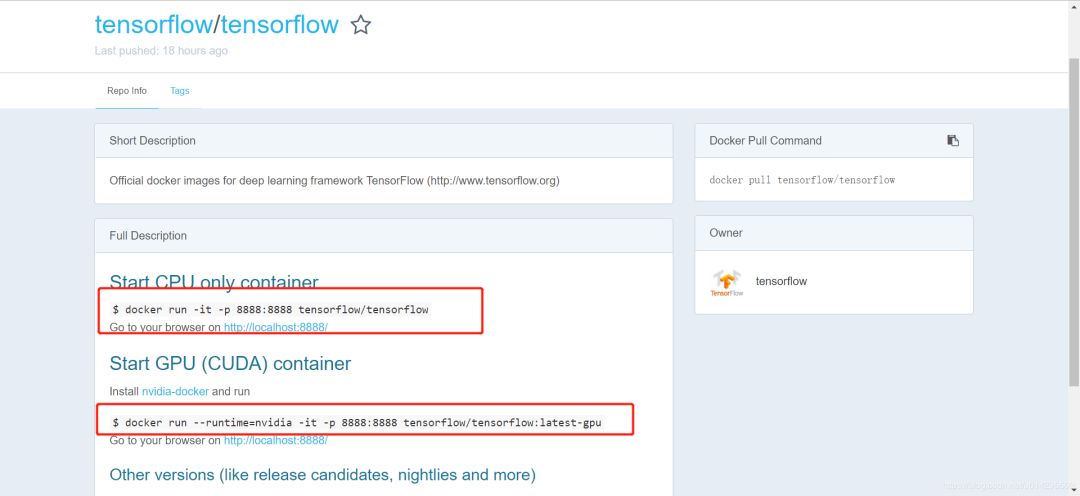

开心的不行,如果你对版本没有这个高的要求,那我们来github里面找找看看还有什么镜像,搜索 tensoflow.

到此,相信大家对“docker在深度学习任务中的应用是什么”有了更深的了解,不妨来实际操作一番吧!这里是亿速云网站,更多相关内容可以进入相关频道进行查询,关注我们,继续学习!

亿速云「云服务器」,即开即用、新一代英特尔至强铂金CPU、三副本存储NVMe SSD云盘,价格低至29元/月。点击查看>>

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。

原文链接:https://my.oschina.net/u/4585819/blog/4595591