小编给大家分享一下如何实现bigwig归一化,相信大部分人都还不怎么了解,因此分享这篇文章给大家参考一下,希望大家阅读完这篇文章后大有收获,下面让我们一起去了解一下吧!

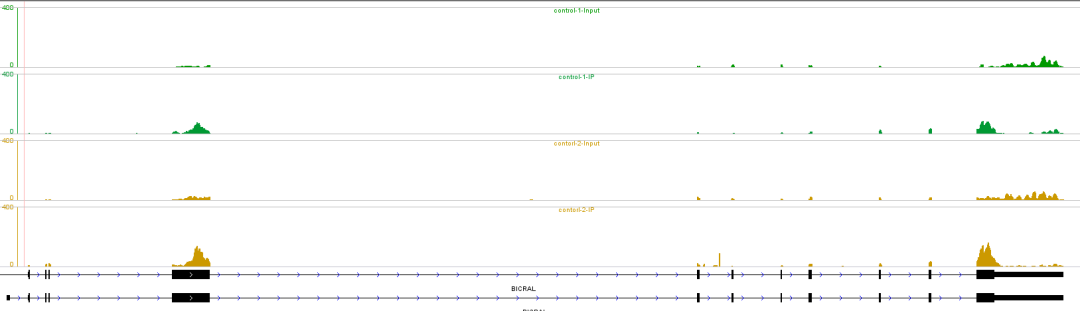

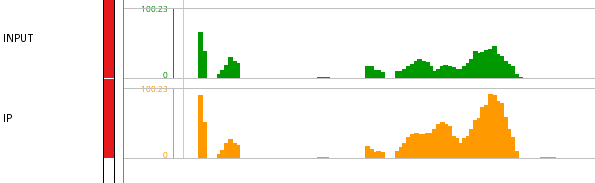

在chip_seq数据展示时,经常会用到bigwig文件,导入igvtools等基因组浏览器中,产生如下所示的图片

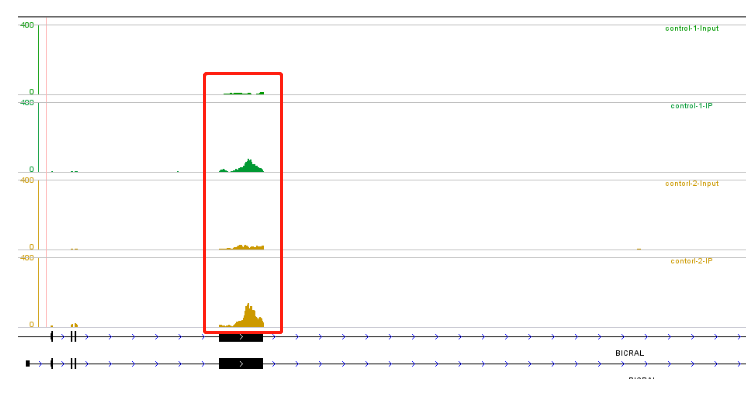

我们将IP样本相对Input样本中reads富集的区域定义为peak, 反映到上图中,则对应的为IP样本中reads出现了峰值,比如下图红色标记的区域

通过这种可视化的方式,可以直观的反映出peak区域的情况,但是在实际使用中需要注意归一化的问题。

bigwig文件本质上展示的是测序深度的分布信息,而原始的测序深度是和测序的reads量呈正相关关系的,比如Input样本测序5G, IP样本测序10G, 在原始的测序深度看,会看到Input样本相比IP样本,其测序深度是偏高的。当然这个是一个极端的例子,但是很好的说明了测序量的差异对原始的测序深度会有直接的影响。

为了消除样本间测序数据量差异的影响,很当然的我们想到了归一化,类似转录组中的定量策略,原始的测序深度就是raw count, 那么当然类似RPKM, CPM等归一化方式,对于bigwig文件而言,同样适用。

在deeptools中,提供了多种归一化方式

RPKM的公式如下

RPKM (per bin) = number of reads per bin / (number of mapped reads (in millions) * bin length (kb))

用法如下

deeptools bamCoverage \

-p 10 \

--bam input.bam \

--normalizeUsing RPKM \

--outFileName rpkm.bigwigCPM的公式如下

CPM (per bin) = number of reads per bin / number of mapped reads (in millions)

用法如下

deeptools bamCoverage \

-p 10 \

--bam input.bam \

--normalizeUsing CPM \

--outFileName cpm.bigwigBPM的公式如下

BPM (per bin) = number of reads per bin / sum of all reads per bin (in millions)

用法如下

deeptools bamCoverage \

-p 10 \

--bam input.bam \

--normalizeUsing BPM \

--outFileName bpm.bigwigRPGC的公式如下

RPGC (per bin) = number of reads per bin / scaling factor for 1x average coverage

scaling factor = (total number of mapped reads * fragment length) / effective genome size用法如下

deeptools bamCoverage \

-p 10 \

--bam input.bam \

--normalizeUsing RPGC \

--effectiveGenomeSize 2864785220 \

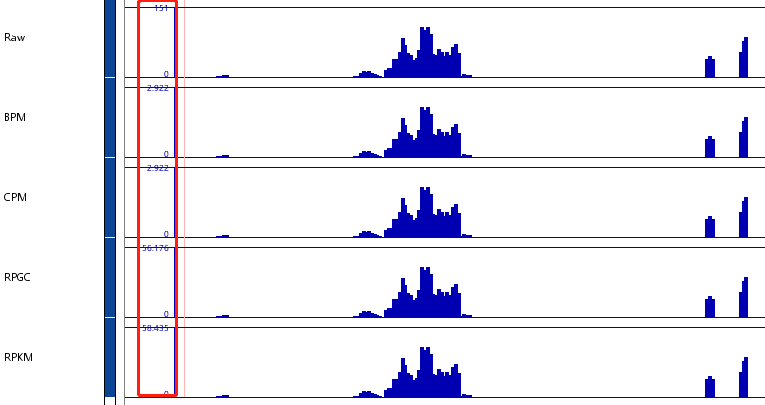

--outFileName rpgc.bigwig对于同一个样本而言,导入igvtools中,几种归一化方式产生的bigwig文件和原始的bigwig文件的峰形是完全一样的 ,示意如下

注意红色方框标记的纵轴的范围,可以看到不同方式,其纵轴范围不一样。

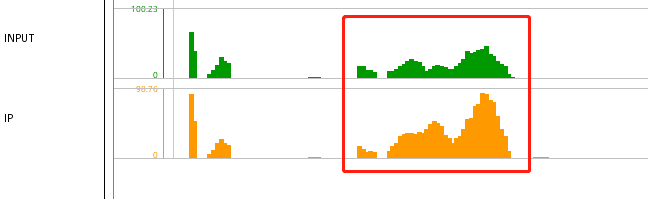

归一化主要用于样本间的比较, 比如在比较Input和Ip两个样本时,就应该使用归一化之后的数据,以RPKM为例,导入之后可以看到如下所示的结果

可以看到纵轴的范围是不一致的,为了更好的比较样本间的差异,我们需要把二者的纵轴范围调整成一致的,因为数据已经做了归一化处理,所以可以直接在同一范围内进行比较,设置成同一范围后,效果如下

对于上述多种归一化方式,其实都是可以拿来在样本间比较的。在实际操作中,由于RPKM的概念最为经典,应用的也最为广泛。

以上是“如何实现bigwig归一化”这篇文章的所有内容,感谢各位的阅读!相信大家都有了一定的了解,希望分享的内容对大家有所帮助,如果还想学习更多知识,欢迎关注亿速云行业资讯频道!

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。