1、删除osd

删除创建的osd。

数据和日志在同一个磁盘上的osd

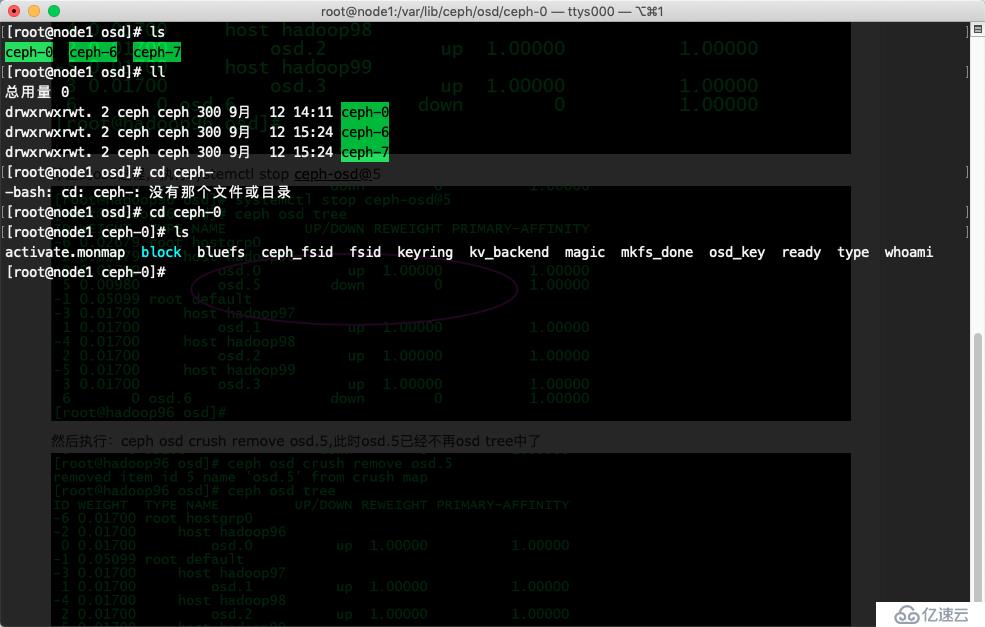

将osd.0踢出集群,执行ceph osd out 0

停止此osd进程,执行systemctl stop ceph-osd@0

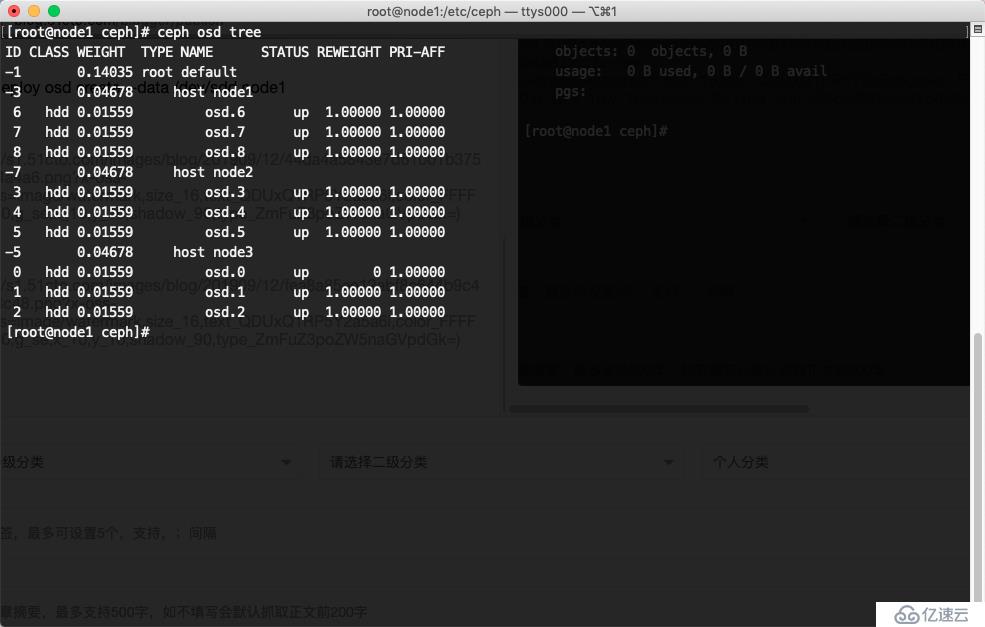

然后执行:ceph osd crush remove osd.0,此时osd.0已经不再osd tree中了

执行ceph auth del osd.0 和 ceph osd rm 0, 此时删除成功但是原来的数据和日志目录还在,也就是数据还在

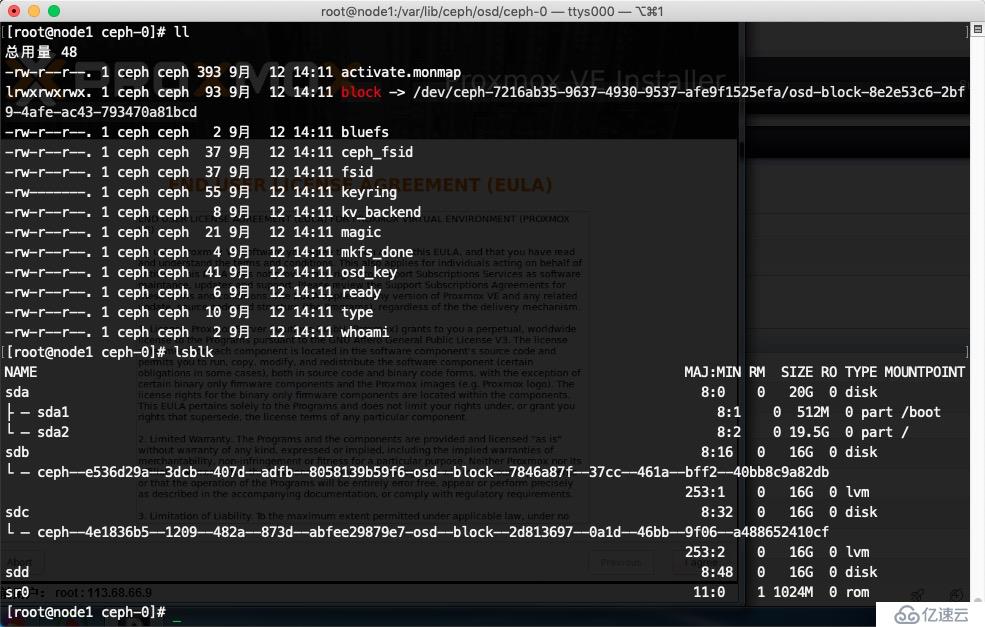

此时我们将/dev/sdd磁盘umount,然后将磁盘进行擦除那么数据就会被完全删除了,执行umount /dev/sdd,然后执行ceph-disk zap /dev/sdd

但是发现umount 不了,也无法删除文件夹

方法

创建osd

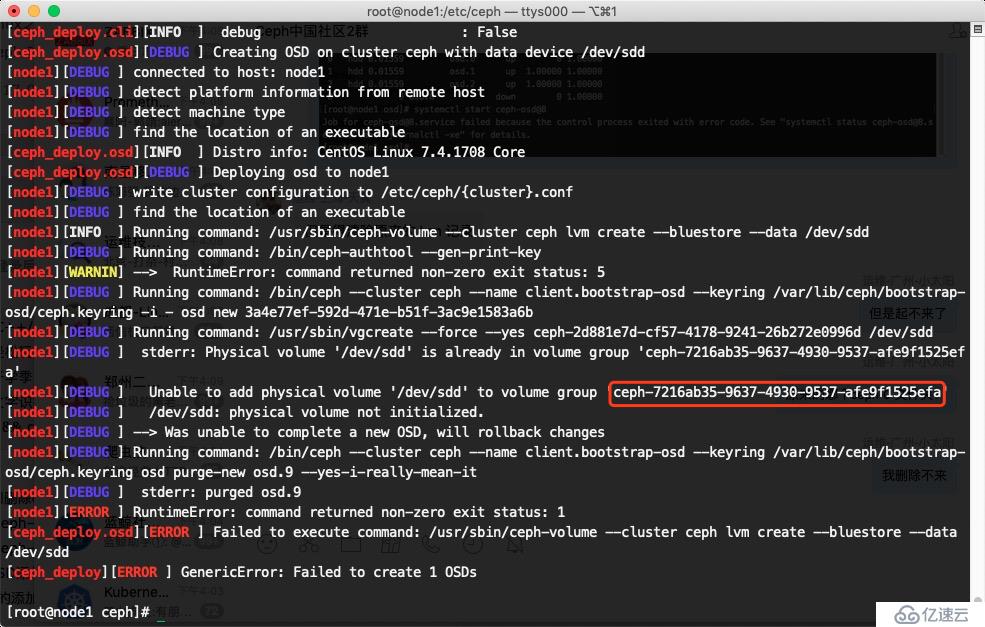

ceph-deploy osd create --data /dev/sdd node1

因为有原来的 lvm 记录,所以重新创建不了,提示原来的lvm有记录

记录下 vg 序列号

ceph-volume lvm list

删除vg记录

vgremove ceph-7216ab35-9637-4930-9537-afe9f1525efa

此时sdd 出来了

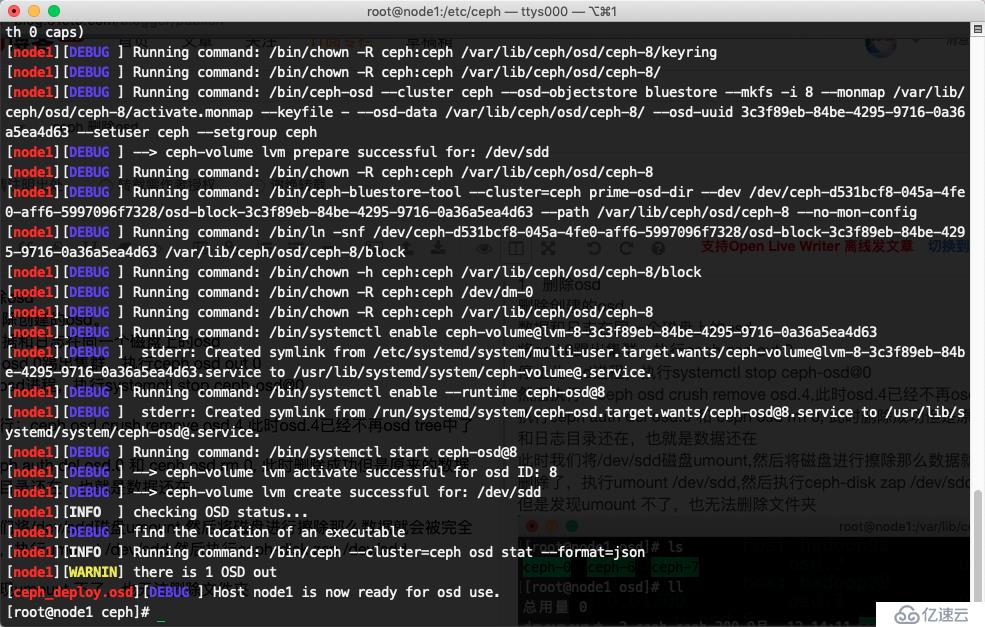

在次执行创建osd

ceph-deploy osd create --data /dev/sdd node1

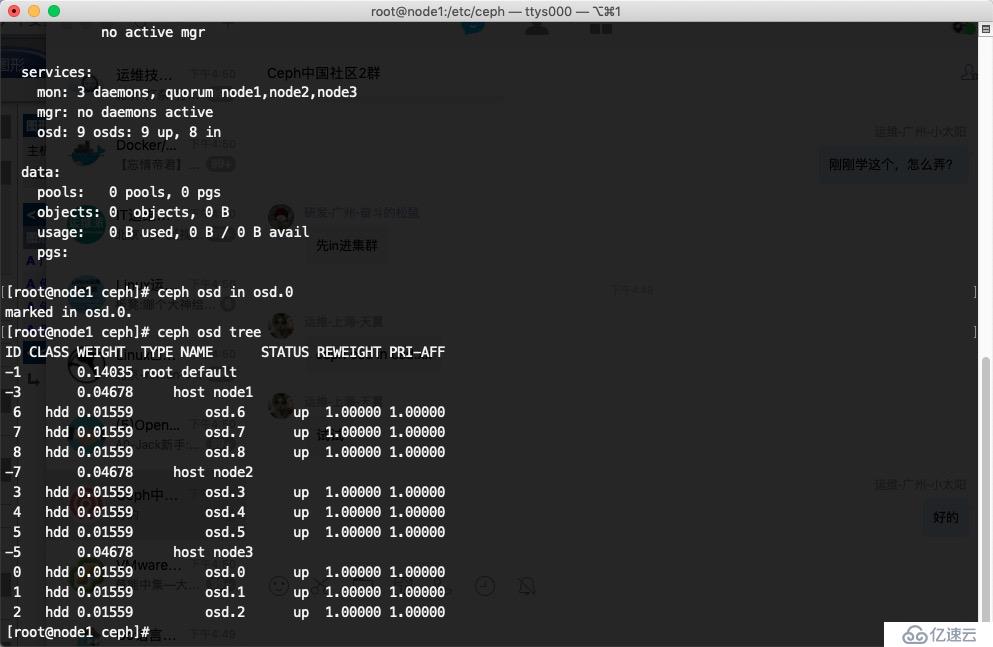

osd.0 in进集群

ceph osd in osd.0

亿速云「云服务器」,即开即用、新一代英特尔至强铂金CPU、三副本存储NVMe SSD云盘,价格低至29元/月。点击查看>>

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。