本篇文章给大家分享的是有关Python中在, 利用多线程实现不加锁分块读取文件,小编觉得挺实用的,因此分享给大家学习,希望大家阅读完这篇文章后可以有所收获,话不多说,跟着小编一起来看看吧。

多线程读取或写入,一般会涉及到同步的问题,否则产生的结果是无法预期的。那么在读取一个文件的时候,我们可以通过加锁,但读不像写操作,会导致文件错误,另外锁操作是有一定的耗时。因此通过文件分块,可以比较有效的解决多线程读问题,之前看到有人写的分块操作,比较复杂,需要实现建立好线程以及所读取块信息,在这里,我提供了一种比较简便的方法,以供参考。

#!/user/bin/env python #_*_coding:utf-8_*_ from threading import Thread import time from processing import Process, Queue from multiprocessing import Process file_path = 't' fd = open(file_path, 'r') def deal(thread_num): i = 1 line_list = [] #20是我的文件行数,正式情况下可以通过wc -l t获取 while i <= 20/thread_num: line_list.append(fd.readline()) i += 1 return line_list def todo(thread_name, line_list): # print 'thread_name:',thread_name,'start' for line in line_list: print str(thread_name) + ' counsume:' + line # print 'thread_name:', thread_name, 'end' if __name__ == '__main__': thread_num = 10 thread_list = [] for i in range(thread_num): line_list = deal(thread_num) t = Thread(target=todo, args=[i, line_list]) t.start() thread_list.append(t) for t in thread_list: t.join()

下面是文件格式:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

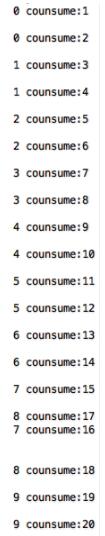

运行的结果如下:

以上就是Python中在, 利用多线程实现不加锁分块读取文件,小编相信有部分知识点可能是我们日常工作会见到或用到的。希望你能通过这篇文章学到更多知识。更多详情敬请关注亿速云行业资讯频道。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。