жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

вҖңи¶…иһҚеҗҲвҖқиҝҷдёӘжҰӮеҝөпјҢеҸҜд»Ҙз®ҖеҚ•зҗҶи§Јдёәпјҡе°ҶиҷҡжӢҹи®Ўз®—е№іеҸ°е’ҢеӯҳеӮЁиһҚеҗҲеҲ°дёҖиө·пјҢе°ҶжҜҸеҸ°жңҚеҠЎеҷЁйҮҢйқўиҮӘеёҰзҡ„зЎ¬зӣҳз»„жҲҗеӯҳеӮЁжұ пјҢд»ҘиҷҡжӢҹеҢ–зҡ„еҪўејҸжҸҗдҫӣж•°жҚ®дёӯеҝғжүҖйңҖиҰҒзҡ„и®Ўз®—гҖҒзҪ‘з»ңгҖҒе®үе…Ёд»ҘеҸҠеӯҳеӮЁзӯүITеҹәзЎҖжһ¶жһ„гҖӮеңЁиҝҷйҮҢпјҢд№ҹи®Іи§ЈдёҖдёӢи¶…иһҚеҗҲзӣёеҜ№дәҺдј з»ҹиҷҡжӢҹеҢ–ж–№жЎҲзҡ„дјҳеҠҝгҖӮжЁӘеҗ‘дёҺзәөеҗ‘зҡ„жү©еұ•жҖ§

йЎҫеҗҚжҖқд№үпјҢжЁӘеҗ‘жү©еұ•е°ұжҳҜеҪ“еҸ‘зҺ°еӯҳеӮЁе’Ңи®Ўз®—иө„жәҗдёҚеӨҹз”ЁдәҶпјҢжҢүйңҖж·»еҠ жңҚеҠЎеҷЁеҚіеҸҜгҖӮжҜ”еҰӮпјҢеҪ“з”ЁжҲ·зҡ„е…ұдә«еӯҳеӮЁеҶҷж»ЎдәҶпјҢз”ЁжҲ·дёҚеҫ—дёҚиҠұеӨ§д»·й’ұеҺ»иҙӯд№°дёҖдёӘж–°зҡ„еӯҳеӮЁжңәжҹңпјҢ然иҖҢжӯӨж—¶еӯҳеӮЁжңәжҹңзҡ„иө„жәҗеҲ©з”ЁзҺҮжҳҜеҫҲдҪҺзҡ„гҖӮиҖҢдҪҝз”Ёи¶…иһҚеҗҲж–№жЎҲзҡ„з”ЁжҲ·пјҢ他们еҸӘйңҖиҰҒжҠ•е…Ҙиҫғе°‘зҡ„иҙ№з”ЁеҺ»иҙӯд№°дёҖдёӘж–°зҡ„жңҚеҠЎеҷЁеҠ е…ҘйӣҶзҫӨпјҢеҚіеҸҜжү©еұ•еӯҳеӮЁз©әй—ҙгҖӮ

дҫҝжҚ·жҸҗдҫӣеӨҡеүҜжң¬пјҢжҸҗй«ҳж•°жҚ®е®үе…Ё

и¶…иһҚеҗҲж–№жЎҲеҸҜдҫҝжҚ·ж”ҜжҢҒ2-3дёӘеүҜжң¬гҖӮеҪ“жҹҗдәӣжңҚеҠЎеҷЁжҚҹеқҸж—¶пјҢиӢҘйҮҮз”Ёи¶…иһҚеҗҲж–№жЎҲпјҢжүҖйңҖиҰҒзҡ„ж•°жҚ®иҝҳдјҡеӯҳеңЁеҜ№еә”зҡ„еүҜжң¬йҮҢпјҢе·ҘдҪңиҝҳиғҪжӯЈеёёиҝӣиЎҢгҖӮиҖҢеҜ№жҜ”дәҺдј з»ҹзҡ„е…ұдә«еӯҳеӮЁпјҢз”ЁжҲ·жғіеҒҡдёӨдёӘеүҜжң¬ж—¶пјҢеҸӘеҘҪзЎ¬зқҖеӨҙзҡ®еҶҚд№°дёҖдёӘдёҖжЁЎдёҖж ·зҡ„еӯҳеӮЁи®ҫеӨҮеҒҡеӨҮд»ҪпјҢеўһеҠ дәҶдёҚе°‘ITжҠ•иө„гҖӮ

еҲҶеёғејҸеӯҳеӮЁпјҢжӢүиҝ‘и®Ўз®—е’ҢеӯҳеӮЁзҡ„и·қзҰ»

дј з»ҹзҡ„е…ұдә«еӯҳеӮЁеңЁж•°жҚ®иҜ»еҶҷж—¶пјҢйғҪйңҖиҰҒйҖҡиҝҮзҪ‘зәҝжҲ–е…үзәӨиҝӣиЎҢж•°жҚ®дј иҫ“гҖӮиҖҢи¶…иһҚеҗҲеҲҶеёғејҸзҡ„еӯҳеӮЁеңЁиҜ»ж•°жҚ®зҡ„ж—¶еҖҷпјҢеҹәжң¬йғҪжҳҜзӣҙжҺҘиҜ»еҸ–жң¬ең°зҡ„еүҜжң¬ж•°жҚ®пјҢеҮҸе°‘ж•°жҚ®жөҒз»ҸзҪ‘зәҝжҲ–е…үзәӨзҡ„ж—¶й—ҙпјҢеҠ еҝ«ж•°жҚ®иҜ»еҸ–йҖҹеәҰгҖӮ

иҪҜ硬件дёҖдҪ“еҢ–пјҢзңҒй’ұзңҒеҠӣзңҒеҝғ

и¶…иһҚеҗҲж–№жЎҲжүҖж”ҜжҢҒзҡ„иҪҜ硬件дёҖдҪ“еҢ–пјҢеҚіз”ЁжҲ·еҸҜд»ҘдёҖж¬ЎжҖ§иҪ»жқҫең°жҠҠдә‘ж•°жҚ®дёӯеҝғйғЁзҪІеҘҪпјҢе…¶дёӯеҢ…жӢ¬жңҚеҠЎеҷЁгҖҒжңҚеҠЎеҷЁиҷҡжӢҹеҢ–гҖҒеӯҳеӮЁиҷҡжӢҹеҢ–зӯүиҷҡжӢҹеҢ–иҪҜ件гҖӮеҜ№жҜ”дёҚе°‘з”ЁжҲ·дјҡеҲҶејҖиҙӯ买硬件е’ҢиҪҜ件пјҢйҮҮиҙӯжҲҗжң¬иҫғй«ҳгҖӮеҗҢж—¶пјҢиҪҜ硬件дёҖдҪ“жңәеңЁеҮәеҺӮж—¶е·Іе°ҶиҪҜ件жӨҚе…ҘеҲ°зЎ¬д»¶еҪ“дёӯпјҢ并且已з»ҸйҖҡиҝҮе…је®№жөӢиҜ•пјҢз”ЁжҲ·еҸҜзӣҙжҺҘжһ¶еҲ°жңәжҲҝпјҢйҖҡз”ө并з®ҖеҚ•й…ҚзҪ®еҚіеҸҜдҪҝз”ЁгҖӮ

жҖ»з»“и¶…иһҚеҗҲзү№зӮ№еҸҠдјҳеҠҝпјҡ

вҖў еҺ»дёӯеҝғеҢ–пјҡжІЎжңүдё“й—Ёзҡ„жҺ§еҲ¶иҠӮзӮ№пјҢж— йңҖиҖғиҷ‘жҺ§еҲ¶иҠӮзӮ№зҡ„еҚ•зӮ№й—®йўҳгҖӮ

вҖў еҺ»йӣҶдёӯеӯҳеӮЁпјҡдј з»ҹзҡ„з§Ғжңүдә‘йӣҶзҫӨжһ¶жһ„пјҢдҝқйҡңеҸҜз”ЁжҖ§жҳҜд»Ҙе…ұдә«еӯҳеӮЁж–№ејҸе®һзҺ°зҡ„гҖӮдҪҶе…ұдә«еӯҳеӮЁжң¬иә«е°ұжҳҜеҚ•зӮ№пјҢиҷҪ然еҸҜд»Ҙд»ҘеӨҡзЈҒзӣҳеҶ—дҪҷе·Із»ҸеҸҢжҺ§еҲ¶еҷЁзҡ„ж–№ејҸжҸҗй«ҳеҸҜз”ЁжҖ§пјҢдҪҶд»Қ然еӯҳеңЁIOйӣҶдёӯгҖҒжҖ§иғҪж— жі•жҸҗеҚҮзҡ„еӣ°еўғгҖӮ

вҖў жӣҙдҪҺзҡ„е»әи®ҫжҲҗжң¬пјҡеҺ»жҺүжҳӮиҙөзҡ„дёӯеҝғеҢ–еӯҳеӮЁпјҢзЈҒзӣҳеҲҶеёғеҲ°жң¬ең°зү©зҗҶжңҚеҠЎеҷЁпјҢжҠ•иө„жҲҗжң¬еӨ§е№…еәҰйҷҚдҪҺгҖӮ

вҖў еңЁзәҝжү©е®№пјҡдёҚеҒңжӯўжңҚеҠЎпјҢеҜ№зү©зҗҶжңәй…Қ件пјҲеҶ…еӯҳгҖҒcpuзӯүпјүиҝӣиЎҢжү©е®№пјҢз”ҡиҮіж–°еўһзү©зҗҶиҠӮзӮ№гҖӮ

PVEйӣҶзҫӨжҗӯе»әиҝҮзЁӢз®Җиҝ°пјҡпјҲ3дёӘз»“зӮ№PVE1-PVE3:192.168.26.210-212)

1гҖҒе®үиЈ…дёӢиҪҪpveе®ҳж–№ISOй•ңеғҸе®үиЈ…еҚіеҸҜпјҢж“ҚдҪңеҫҲз®ҖеҚ•и·ҹзқҖжҸҗзӨәдёӢдёҖжӯҘеҚіеҸҜпјҲеҰӮжһңжңүзү№еҲ«зҡ„еӯҳеӮЁй…ҚзҪ®жіЁж„Ҹе®үиЈ…зҡ„ж—¶еҖҷй…ҚзҪ®дёӢ,д№ҹеҸҜд»ҘеҗҺжңҹеҶҚиҝӣиЎҢи®ҫзҪ®дёҚиҝҮзӣёеҜ№еҸҜиғҪиҰҒз№Ғзҗҗдәӣпјү

е®үиЈ…жҲҗеҠҹеҗҺдҪҝз”ЁжөҸи§ҲеҷЁWEBзҷ»йҷҶж•Ҳжһңпјҡ

2гҖҒзҷ»йҷҶ(йҖҡиҝҮssh)дёүдёӘз»“зӮ№жӣҙж–°жәҗеҸҠзі»з»ҹгҖӮ

rm -f /etc/apt/sources.list.d/pve-enterprise.list

echo "deb http://download.proxmox.com/debian/pve stretch pve-no-subscription" >/etc/apt/sources.list.d/pve-install-repo.list

wget http://download.proxmox.com/debian/proxmox-ve-release-5.x.gpg -O /etc/apt/trusted.gpg.d/proxmox-ve-release-5.x.gpg

apt update && apt dist-upgrade

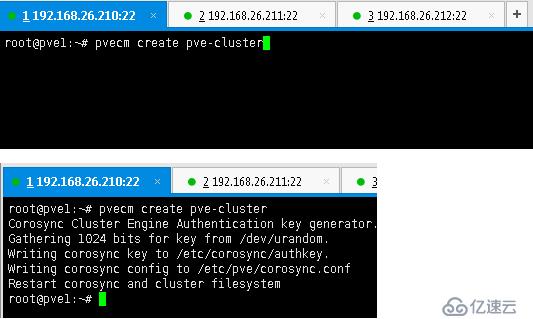

3гҖҒејҖе§ӢеҲӣе»әйӣҶзҫӨеңЁpve1дёҠжү§иЎҢroot@pve1:~# pvecm create pve-cluster

4гҖҒеңЁpve2дёҠжү§иЎҢroot@pve2:~# pvecm add 192.168.26.210жіЁж„ҸйңҖиҰҒиҫ“е…ҘеҜҶз Ғи®ӨиҜҒгҖӮ

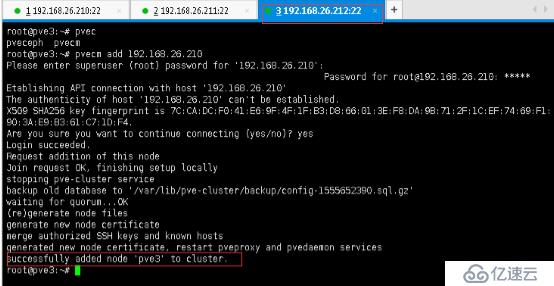

5гҖҒеҗҢж ·еңЁPVE3з»“зӮ№дёҠжү§иЎҢе‘Ҫд»Өroot@pve3:~# pvecm add 192.168.26.210еҗҢж ·йңҖиҰҒиҫ“е…ҘеҜҶз Ғи®ӨиҜҒ

6гҖҒйӣҶзҫӨжҲҗеҠҹеҲӣе»әжҹҘзңӢйӣҶзҫӨзҠ¶жҖҒпјҡдёүдёӘз»“зӮ№д»»дёҖдёҖдёӘдёҠйқўйғҪеҸҜд»ҘгҖӮ

root@pve1:~# pvecm status

еҶҚеҲҮжҚўдёҖдёӘз»“зӮ№иҜ•дёӢжҹҘзңӢзҠ¶жҖҒ

root@pve2:~# pvecm status

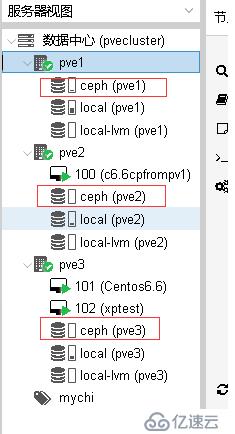

7гҖҒеӣһеҲ°WEBз®ЎзҗҶеҸ°еҸ‘зҺ°дёүдёӘз»“зӮ№йғҪе·Із»ҸеҮәзҺ°дәҶпјҲйӣҶдёӯдёӯд»»дёҖз»“зӮ№йғҪеҸҜд»Ҙпјү

8гҖҒдёәйӣҶзҫӨе»әз«ӢеҸҜйқ зҡ„еӯҳеӮЁпјҲCephеӯҳеӮЁпјҢжіЁж„ҸдёүдёӘйӣҶзҫӨз»“зӮ№йғҪйңҖиҰҒжү§иЎҢпјү

root@pve3:~# pveceph install --version luminous

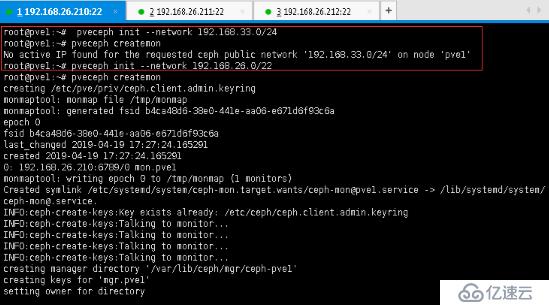

9гҖҒеҲқе§ӢеҢ–еӯҳеӮЁйӣҶзҫӨзҪ‘з»ңж®өпјҢд»ҘдҫҝиҝӣиЎҢйҖҡдҝЎпјҢжіЁж„ҸйңҖиҰҒе’ҢPVEйӣҶзҫӨеҗҢзҪ‘ж®өпјҢеҗҰеҲҷдјҡжҠҘй”ҷ(еҸӘйңҖеңЁPVE1з»“зӮ№дёҠжү§иЎҢдёҖж¬ЎеҚіеҸҜпјүпјҡ

root@pve1:~# pveceph init --network 192.168.33.0/24

No active IP found for the requested ceph public network '192.168.33.0/24' on node 'pve1'

жҚўжҲҗеҗҢзҪ‘ж®өпјҡ

root@pve1:~# pveceph init --network 192.168.26.0/22

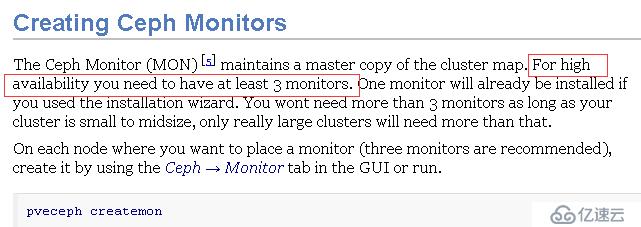

10гҖҒеҲӣе»әcephйӣҶзҫӨеӯҳеӮЁMonзӣ‘жҺ§пјҲдёүдёӘз»“зӮ№йғҪйңҖиҰҒпјҢдёҚ然й«ҳеҸҜз”ЁйғҪж— ж•ҲпјҢе®һжөӢжңүз»“зӮ№ж•…йҡңж—¶дјҡдёҖзӣҙеҚЎдҪҸпјҢиҮіеҲ°MONз»“зӮ№жҒўеӨҚпјү

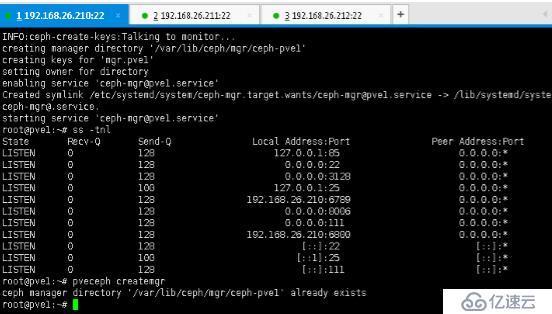

11гҖҒеҲӣе»әcephйӣҶзҫӨеӯҳеӮЁmgr(Creating Ceph Manager)еҗҢж ·йңҖиҰҒдёүдёӘз»“зӮ№йғҪе®үиЈ…дёҚз„¶ж— жі•е®һзҺ°й«ҳеҸҜз”ЁгҖӮ

pveceph createmgr #дҪҶжҸҗзӨәе·Із»ҸеӯҳеңЁпјҢеҺҹеӣ жҳҜе®үиЈ…зӣ‘жҺ§MONзҡ„ж—¶еҖҷиҮӘеҠЁе·Із»Ҹе®үиЈ…дёҠдәҶгҖӮ

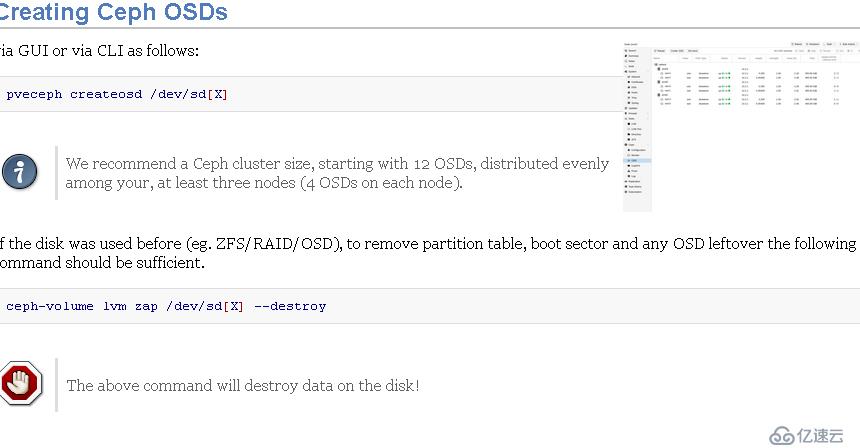

12гҖҒеҲӣе»әCeph OSDsпјҲCreating Ceph OSDsпјүеҗҢж ·дёүдёӘз»“зӮ№йғҪйңҖиҰҒжү§иЎҢдёҖж ·ж“ҚдҪңгҖӮ

13гҖҒеҲӣе»әйӣҶзҫӨеӯҳеӮЁиө„жәҗжұ пјҲCreating Ceph PoolsпјүжӯӨж“ҚдҪңеҸӘйңҖиҰҒд»»дёҖз»“зӮ№дёҠжү§иЎҢеҚіеҸҜгҖӮ

root@pve1:~# ceph osd pool create pvepool 128 128

жӯӨж—¶жҹҘзңӢдёӢеӯҳеӮЁйӣҶзҫӨзҠ¶жҖҒceph -s

жңүжҠҘиӯҰпјҡceph:health_warn clock skew detected on monзҡ„и§ЈеҶіеҠһжі•

йҖ жҲҗйӣҶзҫӨзҠ¶жҖҒhealth_warnпјҡclock skew detected on monиҠӮзӮ№зҡ„еҺҹеӣ дёҖиҲ¬жңүдёӨдёӘпјҢдёҖдёӘжҳҜmonиҠӮзӮ№дёҠntpжңҚеҠЎеҷЁжңӘеҗҜеҠЁпјҢеҸҰдёҖдёӘжҳҜcephи®ҫзҪ®зҡ„monзҡ„ж—¶й—ҙеҒҸе·®йҳҲеҖјжҜ”иҫғе°ҸгҖӮжҺ’жҹҘж—¶д№ҹеә”йҒөеҫӘе…Ҳ第дёҖдёӘеҺҹеӣ пјҢеҗҺ第дәҢдёӘеҺҹеӣ зҡ„ж–№ејҸгҖӮ

дҝ®ж”№ж—¶й—ҙеҒҸе·®йҳҲеҖјпјҲи®°еҫ—йҮҚеҗҜжңҚеҠЎпјү

# vi ceph.conf

еңЁglobalеӯ—ж®өдёӢж·»еҠ пјҡ

mon clock drift allowed = 2 mon clock drift warn backoff = 30

# ceph -s

жҳҫзӨәhealth_okиҜҙжҳҺй—®йўҳи§ЈеҶі

14гҖҒж·»еҠ RBDйӣҶзҫӨеӯҳеӮЁпјҲжү“ејҖжөҸи§ҲеҷЁзҷ»йҷҶWEBжҺ§еҲ¶еҸ°й…ҚзҪ®пјү

жіЁж„ҸйҖүжӢ©дҪҝз”Ёи¶…иһҚеҗҲCEPHжұ гҖӮ

жҹҘзңӢrbdйӣҶзҫӨеӯҳеӮЁй…ҚзҪ®дҝЎжҒҜ

15гҖҒжөӢиҜ•еҲӣе»әиҷҡжӢҹжңҚеҠЎеҷЁPVE1дёҠ

е®үиЈ…CENTOS6.6

pve3е®үиЈ…XP

е…ій—ӯе…¶е®ғиҠӮзӮ№пјҲиҠӮзӮ№1пјүдёҚеҪұе“Қе®үиЈ…ж“ҚдҪң

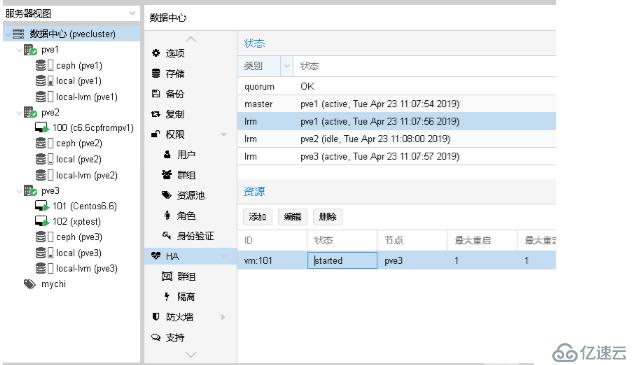

жөӢиҜ•й«ҳеҸҜз”Ёпјҡе…Ҳй…ҚзҪ®

жөӢиҜ•пјҡPVE3е…іжңәеҗҺ收еҲ°жҠҘиӯҰпјҲе®үиЈ…зҡ„ж—¶еҖҷй…ҚзҪ®дәҶйӮ®д»¶ең°еқҖзҡ„пјү

иҝҮдёӨеҲҶй’ҹиҝҳдјҡ收еҲ°дёҖе°ҒйӮ®д»¶пјҡжҸҗзӨәж•…йҡңе·Із»ҸжҲҗеҠҹиҪ¬з§»гҖӮ

иҷҡжӢҹжңҚеҠЎеҷЁе·Із»ҸиҪ¬з§»

зңӢдёӢWEBе№іеҸ°жөҸи§Ҳзҡ„зҠ¶жҖҒпјҡ

жҲ‘们жҒўеӨҚPVE3.

жҒўеӨҚеҗҺиҮӘеҠЁиҝҒ移еӣһеҺ»дәҶпјҢеӣ дёәе…¶жқғйҮҚй«ҳдәӣ(з”ҹдә§зҺҜзҺҜеўғдёҚе»әи®®зӣҙжҺҘеҸҲеӣһеҲҮпјҢж №жҚ®йңҖиҰҒй…ҚзҪ®пјүгҖӮ

Proxmoxдёӯе…ӢйҡҶиҷҡжӢҹжңҚеҠЎеҷЁ

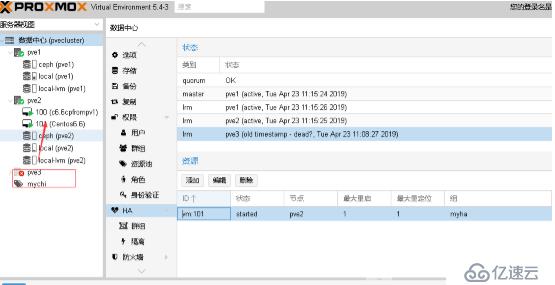

ProxmoxдёӯиҝҒ移иҷҡжӢҹжңҚеҠЎеҷЁпјҲpve3еҲ°pve1)

й…ҚзҪ®spiceжЁЎжӢҹз»Ҳз«Ҝзҷ»йҷҶ(е®һзҺ°еҸҜд»ҘзӣҙжҺҘдҪҝз”Ёз»Ҳз«Ҝи®ҫзҪ®иҒ”жҺҘж“ҚдҪңиҷҡжӢҹжңәе®һзҺ°дә‘жЎҢйқўпјүпјҡ

й…ҚзҪ®ж–Ү件дёӯж·»еҠ еҶ…е®№пјҡargs: -spice port=61001,disable-ticketing,seamless-migration=on

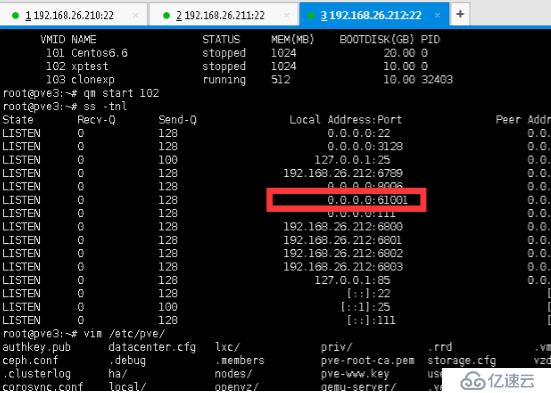

еҗҜеҠЁ102 иҷҡжӢҹжңҚеҠЎеҷЁqm start 102пјҲиҝҷйҮҢйҖҡиҝҮе‘Ҫд»ӨеҗҜеҠЁзҡ„пјүд№ҹеҸҜд»ҘйҖҡиҝҮWEBжҺ§еҲ¶еҸ°ж•ҲжһңдёҖж ·гҖӮ

еҗҜеҠЁеҗҺеҸ‘зҺ°еӨҡејҖж”ҫдәҶдёҖдёӘз«ҜеҸЈпјҢй…ҚзҪ®з»Ҳз«ҜжңәиҒ”жҺҘжӯӨз«ҜеҸЈеҚіеҸҜиҒ”жҺҘж“ҚдҪңжңҚеҠЎеҷЁгҖӮиҝҷйҮҢйҖҡиҝҮVirtViewerиҪҜ件模жӢҹзҷ»йҷҶгҖӮ

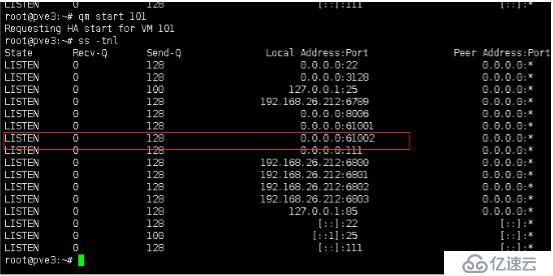

жҚўеҸ°жңҚеҠЎеҷЁеҶҚиҜ•пјҲlinux)пјҡ

еҗҢж ·йңҖиҰҒдҝ®ж”№й…ҚзҪ®ж–Ү件пјҡ

root@pve3:~# cat /etc/pve/qemu-server/101.conf

bootdisk: sata2

cores: 1

ide2: none,media=cdrom

memory: 1024

name: Centos6.6

net0: e1000=26:24:01:00:69:7D,bridge=vmbr0

numa: 0

ostype: l26

sata2: ceph:vm-101-disk-0,size=20G

scsihw: virtio-scsi-pci

smbios1: uuid=73100396-3804-4002-815b-4017d81199a9

sockets: 1

vmgenid: bb0d8fc0-a6c7-4283-81f3-6766c4f150a2

args: -spice port=61002,disable-ticketing,seamless-migration=on

дҝқеӯҳйҖҖеҮәеҗҜеҠЁиҷҡжӢҹжңҚеҠЎеҷЁ

иҒ”жҺҘж•Ҳжһңпјҡ

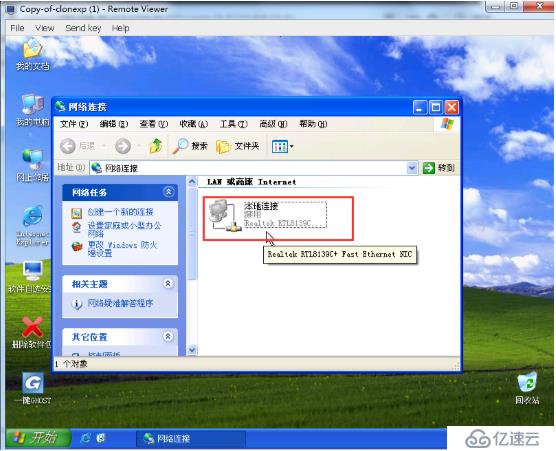

йңҖиҰҒиҜҙжҳҺзҡ„жҳҜз»Ҳз«ҜиҒ”жҺҘзҡ„жҳҜе№іеҸ°жңҚеҠЎеҷЁIPеҠ дёҠз«ҜеҸЈпјҢжҳҜеҹәдәҺз«ҜеҸЈзҡ„еә”з”ЁпјҢиҖҢжҲ‘们иҒ”дёҠжңҚеҠЎеҷЁеҗҺй…ҚзҪ®зҡ„иҷҡжӢҹжңҚеҠЎеҷЁдёҠзҪ‘з”Ёзҡ„IPең°еқҖпјҢеӣ жӯӨдёҚиҰҒж··дәҶпјҢеҚідҪҝжҲ‘们жҠҠзҪ‘еҚЎзҰҒз”ЁдәҶйҖҡиҝҮз»Ҳз«ҜиҝҳжҳҜиғҪиҒ”жҺҘзҡ„пјҢеҸӘжҳҜжңҚеҠЎеҷЁдёҚиғҪдёҠеӨ–зҪ‘з»ңпјҲе’Ңе…¶е®ғжңҚеҠЎеҷЁйҖҡдҝЎпјүзңӢдёӢеӣҫзүҮдёӯж•ҲжһңпјҢе’ҢжҲ‘们平常ејҖеҗҜиҝңзЁӢи®ҝй—®жҳҜжңүеҢәеҲ«зҡ„гҖӮ

cd

еҠҹиғҪж•ҲжһңжҡӮж—¶еұ•зӨәеҲ°иҝҷпјҢе…¶е®ғеҠҹиғҪеҸҠиЎҘе……еҗҺз»ӯж–Үз« еҶҚе®Ңе–„пјҢеҘҪд№…жІЎеҶҷж–ҮдәҶпјҢиҚүж–Үе ҶдәҶдёҖеӨ§е ҶгҖӮ

еҸӮиҖғпјҡhttps://pve.proxmox.com/pve-docs/chapter-pveceph.html

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ