机器之心报道

参与:张倩、蛋酱

昨天,知乎上出现了一个「救救 AI 领域,救救孩子!」的帖子,在社区内引起了广泛关注。AI 领域出了什么问题?怎么拯救?这篇文章将重点探讨这些问题。

原贴链接:https://zhuanlan.zhihu.com/p/127085043

发帖者认为,目前 AI 领域的「灌水」、造假乱象已经到了不可忽视的地步,因此呼吁大家揭露在论文或代码中发现的问题。为此,她创建了一个名为「AI 论文在线质疑」的专栏,希望大家可以将发现的问题反馈出来,一起讨论,借助大家的力量净化 AI 社区。

这一倡议得到了清华大学副教授刘知远等圈内研究者的支持。毕竟学术造假、灌水对 AI 领域的长期发展非常不利,尤其是前者。正如发帖者所说,科学研究是一个不断迭代的过程,「如果前人的顶会论文是造假的,后辈们后面 follow 的文章就如同建立在垃圾上的空中楼阁,岌岌可危。」

目前,很多顶会组委会、期刊编辑似乎都注意到了这个问题,因此越来越重视论文的可复现性,要求论文作者提交代码、鼓励重复性研究等。但投稿众多,官方力量有限,因此也需要借助「民间」力量。

CVPR 2019 暴露出的问题

作为一个长期存在的问题,国内社区对 AI 领域「灌水」、「造假」问题的关注似乎在 CVPR 2019 放榜之际达到了高潮。

CVPR 2019 最终收到有效投稿 5165 篇,比上一年投稿量足足增长了 50% 以上。当时,因为投稿量的大幅度增长,论文的在线协同编辑工具 overleaf 一度因为编辑人太多而崩溃。

华南理工谭明奎教授评论说:「当硬件领域的摩尔定律逐渐因为硬件极限而失效的时候,paper 发表数量接了班。」

从那时开始,越来越多的人意识到,今天的顶会已经不再是原来的顶会了。

人们对 CVPR 以及其他顶会所存在问题的不满,也终于爆发了出来。在知乎问题「2019 年 CVPR 有哪些糟糕的论文?」下面,多篇文章被拉出来,一条条地进行分析指责,这里面甚至包括 oral 论文,「让人觉得 CVPR 也不过如此」。

这样的「质疑」也存在于各个顶会,人工智能火了,从业者暴增,论文投稿数量暴增,让昔日光环加身的顶会显得「臃肿不堪」。

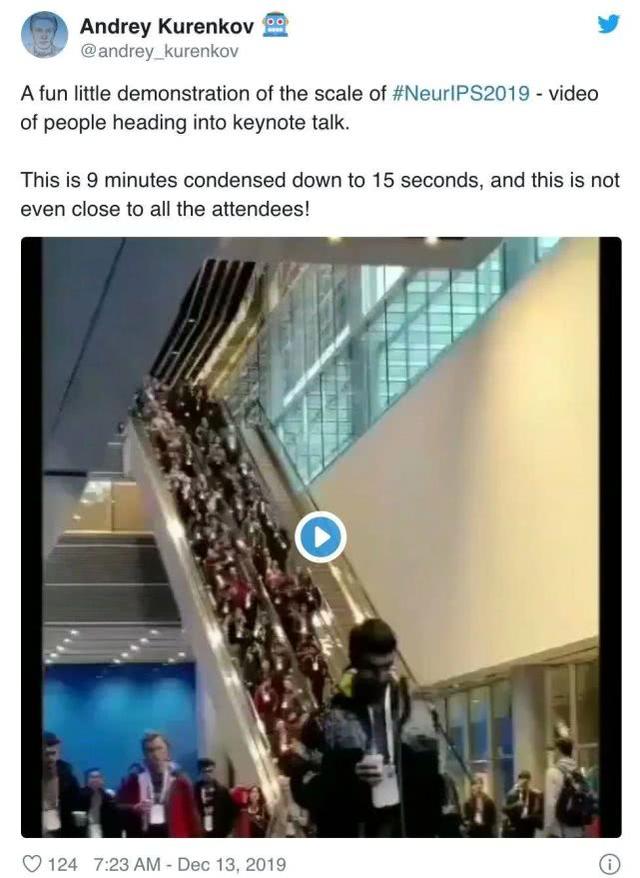

NeurIPS 2019

,投稿上万,1428 篇接收论文,57 场 workshop,13000 名参会者,远远看去,大会现场宛如演唱会……

ICLR 2020

,投稿量逐年上涨,2018 年 900 多篇,2019 年 1500 篇,2020 则达到了 2600 多篇。

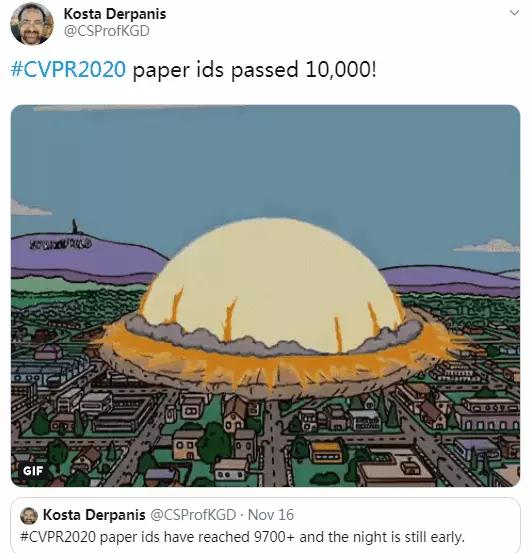

CVPR 2020

,投稿论文 ID 破万,有效投稿 6656 篇,比 CVPR 2018 相比整整翻了一番……

在 AI 领域待过的人,或多或少都有一个奇怪的焦虑(peer pressure):投完 NIPS 就想着 AAAI 投什么好,投完 AAAI 就在想 CVPR 投什么好。为什么可以有那么多工作可以投?不排除有少部分大佬和巨佬是真的可以做到有源源不断地产出 impressive 的 idea 并且能在短时间内对 idea 从理论到实践都进行详尽地验证,然而除了大佬以外的其他人呢?无他,纯灌水耳。(引自 @ 信息门下跑狗)

如何拯救?

问题说了一大堆,怎么解决呢?从目前各大顶会、期刊动向及个人建议来看,大体可以可以分为两个思路。一是从会议、期刊入手,制定更加严格的投稿政策(如要求提交代码),同时积极接收重复性研究和得出无效结果的研究;二是社区自发的「打假」运动,充分利用社区资源,「大家一起来找茬」。针对这两个思路,各方似乎已经开始了尝试。

NeurIPS 2020:「强烈建议」提交代码

从 NeurIPS 2019 开始,组委会就启动了鼓励提交论文代码的策略(非强制)。这一策略起到了一定的效果。在 NeurIPS 2019 的最后提交阶段,有 75% 的被接收论文附带了代码,相比 2018 年的 50% 有了很大的提升。

今年,组委会继续强化这一策略,从「鼓励」变成了「强烈建议」(仍不强制),还提供了提交代码的准则和模板。

这一规则是依据 2019 年审稿人的反馈决定的,据调查,每次审稿之后,13% 的审稿人表示看过代码,21% 的审稿人表示没看过,其余表示「不适用」,这也许是因为很多论文没有代码。在未提供代码的前提下,21% 的审稿人表示希望论文附有代码。并且组委会发现,随论文提交代码的质量与审稿人给出的评分高度相关。

Nature:鼓励重复性研究和无效结果研究

在今年 2 月的一篇社论文章中,《Nature》提出了一项倡议,指出研究机构、期刊都应该鼓励重复研究和得出无效结果(NULL results)的研究。文章强调,发表无效结果的研究者可以帮助社区将大量资金投向更富有成效的领域,更广泛地传播无效结果将最终促使社区改变他们的理论,使其更加适用于现实世界。

对此,这篇社论文章提出了两种策略。

首先,研究机构应该通过言语和行动来鼓励这种行为。去年,柏林健康研究所发出了一份书面倡议,鼓励该机构的研究者发表自己的重复性结果和无效结果,对抗复现危机。响应倡议的研究者将得到 1000 欧元的奖励。此外,该研究所还有一个 APP 和顾问,帮助研究人员确定应该联系哪些期刊、预印本平台或其他渠道来发表重复性研究和数据。该 APP 会提供有关预期发表费用、提交 deadline、论文格式、同行评审要求等信息。

其次,这篇文章指出,应该有更多期刊向社区强调发表重复性研究和无效结果的重要性,而且《Nature》明确表态,「在《Nature》中,重复性研究被放在与其他研究同等的高度。《Nature》欢迎提交可以为之前已发表工作提供见解的研究。」

创建 AI 领域 pubpeer?

期刊、会议虽然影响广泛,但面临海量的投稿,他们的力量也是有限的,所以才有了文章开头提到的倡议。对此,刘知远教授回复道:「可以考虑搞个 AI 版的 PubPeer」。

PubPeer 建立于 2012 年,是一个鼓励科研人员匿名对已发表的论文进行评论的网站。它相当于一个科学论坛,只要学者拥有 PubPeer 的账号,都可以对已发表过的论文进行评论,评论内容可以是批评、质疑、改进建议等。此前很多处于风暴中心的研究讨论都是在这个网站上发酵的,甚至有些论文会因此撤稿。

这种「打假」网站的存在可以在一定程度上震慑学术不端的研究者。如果 AI 领域能有类似网站,相信对于整个社区研究氛围的提升都有帮助。

推荐阅读:

《关于本次 CVPR2019 投稿的一些感想》https://zhuanlan.zhihu.com/p/50263270

《深度学习先驱 Bengio:AI 顶会论文的 Deadline 是时候取消了》

参考链接:

https://www.nature.com/articles/d41586-020-00530-6

https://medium.com/@NeurIPSConf/designing-the-reproducibility-program-for-neurips-2020-7fcccaa5c6ad

https://www.toutiao.com/i6813939858885575182/

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。