жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

е…Ёж–Үе…ұ 1925еӯ—пјҢйў„и®ЎеӯҰд№ ж—¶й•ҝ 4еҲҶй’ҹ

еӣҫзүҮжқҘжәҗпјҡunsplash.com/@multamedia

дҪ жҳҜеҗҰеҜ№жңәеҷЁеӯҰд№ жЁЎеһӢеҰӮдҪ•е·ҘдҪңж„ҹеҲ°еҘҪеҘҮпјҹиҝҷдәӣжЁЎеһӢеҶ…йғЁжҳҜеҰӮдҪ•иҝҗдҪңзҡ„пјҢе®ғ们жҳҜеҗҰеҖјеҫ—дҝЎд»»пјҹ

жң¬ж–Үе°Ҷе…ЁйқўжҰӮиҝ°д»Җд№ҲжҳҜеҸҜи§ЈйҮҠдәәе·ҘжҷәиғҪпјҲXAIпјүпјҢд»ҘеҸҠдёәд»Җд№ҲйңҖиҰҒXAIгҖӮиҜ»е®Ңжң¬ж–ҮеҗҺпјҢдҪ еә”иҜҘиғҪеӨҹзҗҶи§ЈXAIзҡ„еҝ…иҰҒжҖ§пјҢ并且еҸҜд»ҘиҖғиҷ‘жҳҜеҗҰйңҖиҰҒе°Ҷе…¶еә”з”ЁеҲ°MLйЎ№зӣ®жҲ–дә§е“ҒдёӯеҺ»гҖӮ

д»Җд№ҲжҳҜXAIпјҹ

еҸҜи§ЈйҮҠдәәе·ҘжҷәиғҪпјҲXAIпјүжҳҜжңәеҷЁеӯҰд№ дёӯдёҖдёӘзӣёеҪ“ж–°зҡ„йўҶеҹҹгҖӮеңЁиҝҷдёӘйўҶеҹҹдёӯпјҢз ”з©¶иҖ…иҜ•еӣҫејҖеҸ‘дёҖж¬ҫж–°жЁЎеһӢпјҢжқҘи§ЈйҮҠжңәеҷЁеӯҰд№ пјҲMLпјүжЁЎеһӢиғҢеҗҺзҡ„еҶізӯ–иҝҮзЁӢгҖӮ

XAIжңүи®ёеӨҡдёҚеҗҢзҡ„з ”з©¶еҲҶж”ҜпјҢдҪҶжҖ»зҡ„жқҘиҜҙпјҢиҰҒд№ҲжҳҜиҜ•еӣҫи§ЈйҮҠеӨҚжқӮзҡ„й»‘з®ұжЁЎеһӢзҡ„з»“жһңпјҢиҰҒд№ҲиҜ•еӣҫе°ҶеҸҜи§ЈйҮҠжҖ§зәіе…ҘеҪ“еүҚзҡ„жЁЎеһӢдҪ“зі»з»“жһ„дёӯгҖӮ第дёҖз§Қж–№жі•иў«з ”з©¶иҖ…е№ҝжіӣйҮҮз”ЁпјҢиҝҷз§Қж–№жі•дёҚиҖғиҷ‘иҜ•жЁЎеһӢзҡ„еҹәжң¬дҪ“зі»пјҢеҸӘиҜ•еӣҫи§ЈйҮҠMLжЁЎеһӢеҒҡдәҶд»Җд№ҲгҖӮиў«з§°дёәжЁЎеһӢдёҚеҸҜзҹҘзҡ„XAIгҖӮ

дёәд»Җд№ҲйңҖиҰҒXAIпјҹ

жҲ‘们еҸҜд»ҘдёҫдҫӢжқҘиҜҙжҳҺгҖӮйҡҸзқҖеҪ“еүҚж·ұеәҰеӯҰд№ пјҲDLпјүзҡ„еҸ‘еұ•пјҢеҜ№дәҺDLжЁЎеһӢжқҘиҜҙпјҢжӢҘжңүеҮ зҷҫдёҮдёӘеҸӮж•°жҳҜйқһеёёе…ёеһӢзҡ„пјҒе°ҶиҝҷдәӣеҸӮж•°дёҺе·Із»ҸдҪҝз”ЁдәҶеҮ еҚҒе№ҙзҡ„з®ҖеҚ•зәҝжҖ§еӣһеҪ’жЁЎеһӢиҝӣиЎҢжҜ”иҫғпјҢе°ұдјҡзҗҶи§ЈDLжЁЎеһӢеҲ°еә•жңүеӨҡеӨҚжқӮгҖӮ

дәӢе®һдёҠпјҢDLжЁЎеһӢе·Із»ҸеҜ№еҫҲеӨҡиЎҢдёҡдә§з”ҹдәҶе·ЁеӨ§зҡ„еҪұе“ҚпјҢдҪҶе…¶дёӯи®ёеӨҡд»Қ然被用дҪңй»‘з®ұзі»з»ҹгҖӮиҝҷ并дёҚжҳҜдёҖ件еҘҪдәӢпјҢе°Өе…¶жҳҜз”ЁиҝҷдәӣжЁЎеһӢжқҘдҪңеҮәиғҪеӨҹдә§з”ҹе·ЁеӨ§зӨҫдјҡеҪұе“Қзҡ„еҶізӯ–ж—¶гҖӮ

XAIи§ЈеҶідәҶд»Җд№Ҳй—®йўҳпјҹ

XAIиҜ•еӣҫеӣһзӯ”дёүз§ҚдёҚеҗҢзұ»еһӢзҡ„й—®йўҳпјҡдёәд»Җд№Ҳпјҹд»Җд№Ҳж—¶еҖҷпјҹжҖҺд№ҲеҒҡпјҹеҰӮжһңеңЁејҖеҸ‘MLдә§е“Ғж—¶йҒҮеҲ°д»ҘиҝҷдёүдёӘе…ій”®иҜҚжҸҗй—®зҡ„й—®йўҳж—¶пјҢе°ұеҸҜиғҪйңҖиҰҒжұӮеҠ©дәҺXAIгҖӮд»ҘдёӢжҳҜеңЁMLйЎ№зӣ®дёӯйҒҮеҲ°зҡ„дёҖдәӣе…ёеһӢй—®йўҳпјҡ

В· дёәд»Җд№ҲMLжЁЎеһӢдјҡеҒҡеҮәиҝҷж ·зҡ„йў„жөӢпјҹ

В· д»Җд№Ҳж—¶еҖҷиғҪзӣёдҝЎиҝҷдёӘжЁЎеһӢзҡ„йў„жөӢпјҹ

В· д»Җд№Ҳж—¶еҖҷиҝҷдёӘжЁЎеһӢдјҡеҒҡеҮәй”ҷиҜҜзҡ„йў„жөӢпјҹ

В· жҖҺд№ҲеҒҡиғҪзә жӯЈиҝҷдёӘжЁЎеһӢзҡ„й”ҷиҜҜпјҹ

еӣһзӯ”иҝҷдәӣй—®йўҳпјҢйңҖиҰҒе°ҶXAIжЁЎеһӢ/жҰӮеҝөиһҚеҗҲеҲ°M1йЎ№зӣ®/дә§е“ҒдёӯеҺ»гҖӮ

д»Җд№Ҳж—¶еҖҷйңҖиҰҒXAIпјҹ

еңЁжҜҸдёӘMLйЎ№зӣ®дёӯпјҢжҹҗз§ҚзЁӢеәҰдёҠпјҢеҸҜиғҪйңҖиҰҒеҗ‘е®ўжҲ·жҲ–еҗҢдәӢжҸҗдҫӣMLжЁЎеһӢзҡ„еҶізӯ–иҝҮзЁӢгҖӮXAIеңЁMLзҡ„еә”з”ЁдёӯиҮіе…ійҮҚиҰҒпјҢMLзі»з»ҹзҡ„еҶізӯ–зӣҙжҺҘеҪұе“Қдәә们зҡ„з”ҹжҙ»пјҢеҜ№зӨҫдјҡдә§з”ҹе·ЁеӨ§еҪұе“ҚгҖӮ

дёҖдәӣдәәеҸҜиғҪдјҡи®ӨдёәпјҢеңЁеӨ§еӨҡж•°жғ…еҶөдёӢпјҢжңҖз»Ҳзҡ„еҶіе®ҡжҳҜз”ұдәә们еҒҡеҮәзҡ„гҖӮдҪҶжҳҜпјҢи®ёеӨҡ专家дјҡдҪҝз”ЁеӨҚжқӮзҡ„MLзі»з»ҹжқҘеё®еҠ©д»–们еҒҡеҶіе®ҡгҖӮеҰӮжһңMLзі»з»ҹдёҚиғҪи§ЈйҮҠе®ғеҒҡеҶіе®ҡзҡ„еҺҹзҗҶпјҢйӮЈд№ҲеҜ№дәҺ专家жқҘиҜҙпјҢе°ұеҫҲйҡҫдҝЎд»»MLзі»з»ҹпјҢ并且дјҡеӯҳеңЁйЈҺйҷ©пјҒ

XAIжңүе“Әдәӣзҡ„еёёи§Ғз”ЁдҫӢпјҹ

зӣ®еүҚпјҢAI/MLжӯЈеңЁдҪҝз”Ёзҡ„жүҖжңүйўҶеҹҹйғҪжңүXAIз”ЁдҫӢпјҒжң¬ж–ҮдёҚдјҡеҲ—еҮәжүҖжңүз”ЁдҫӢпјҢиҖҢжҳҜз”ЁдёӨдёӘдҫӢеӯҗжқҘиҜҙжҳҺпјҢеҪ“MLжЁЎеһӢзҡ„еҶізӯ–дёҘйҮҚеҪұе“Қдәә们зҡ„з”ҹжҙ»ж—¶пјҢдёәд»Җд№ҲйңҖиҰҒXAIпјҢд»ҘеҸҠеҰӮдҪ•дҪҝз”ЁXAIгҖӮд»ҘдёӢдҫӢеӯҗжқҘжәҗдәҺеҢ»еӯҰе’ҢйҮ‘иһҚйўҶеҹҹгҖӮ

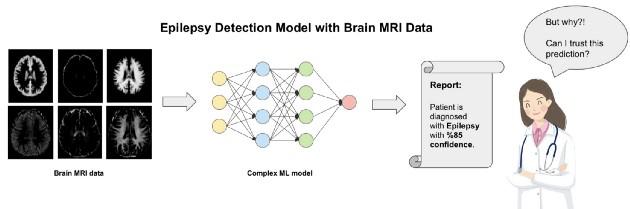

з”ЁдҫӢдёҖпјҡдёәд»Җд№ҲеҢ»еӯҰMLеә”з”ЁйңҖиҰҒXAIпјҹ

еҒҮи®ҫдёҖдёӘз—…дәәеҺ»еҢ»йҷўжЈҖжҹҘеҘ№/д»–жҳҜеҗҰжӮЈжңүзҷ«з—«гҖӮеҢ»з”ҹе°Ҷз—…дәәи„‘йғЁзҡ„ж ёзЈҒе…ұжҢҜеӣҫеғҸиҫ“е…ҘеҲ°дёҖдёӘеӨҚжқӮзҡ„MLжЁЎеһӢдёӯпјҢз”ҹжҲҗзҡ„жҠҘе‘Ҡд»Ҙ85%зҡ„зҪ®дҝЎеәҰиҜҠж–ӯз—…дәәжӮЈжңүзҷ«з—«гҖӮд»ҘдёӢжҳҜеҢ»з”ҹеҸҜиғҪдјҡй—®зҡ„дёҖдәӣй—®йўҳпјҡ

В· жҲ‘иҰҒжҖҺд№ҲзӣёдҝЎиҝҷдёӘжЁЎеһӢзҡ„жҠҘе‘Ҡе‘ўпјҹ

В· жЁЎеһӢжҳҜеҹәдәҺж ёзЈҒе…ұжҢҜеӣҫеғҸзҡ„е“Әдәӣзү№еҫҒпјҢеҒҡеҮәдәҶиҝҷдёӘеҶіе®ҡпјҹ

В· MLжЁЎеһӢеҒҡеҮәиҝҷдёӘеҶіе®ҡзҡ„ж–№ејҸеҜ№жҲ‘жңүж„Ҹд№үеҗ—пјҹжҲ‘жҖҺд№ҲзҹҘйҒ“иҝҷдёӘжЁЎеһӢзҡ„еҶізӯ–иҝҮзЁӢжҳҜд»Җд№Ҳпјҹ

В· еҰӮжһңиҝҷд»ҪжҠҘе‘ҠжҳҜй”ҷиҜҜзҡ„пјҢжҲ–иҖ…жЁЎеһӢзҡ„еҶізӯ–иҝҮзЁӢдёҚеӨҹеҮҶзЎ®пјҢиҜҘжҖҺд№ҲеҠһпјҹ

жӯӨеӨ–иҝҳжңүеҫҲеӨҡй—®йўҳпјҒеҸҜд»ҘзңӢеҮәпјҢйҷӨйқһMLжЁЎеһӢзҡ„еҶізӯ–иҝҮзЁӢиў«е‘ҲзҺ°еҮәжқҘпјҢ并且еҸҜд»Ҙиў«йӘҢиҜҒпјҢеҗҰеҲҷеҢ»з”ҹ并дёҚдјҡдҝЎд»»жЁЎеһӢзҡ„еҶізӯ–з»“жһңгҖӮ

еҢ»еӯҰеә”з”Ёдёӯзҡ„зҷ«з—«жЈҖжөӢзі»з»ҹ

з”ЁдҫӢдәҢпјҡдёәд»Җд№ҲйҮ‘иһҚMLеә”з”ЁйңҖиҰҒXAIпјҹ

еҒҮи®ҫдёҖдёӘдәәеҺ»йҮ‘иһҚжңәжһ„з”іиҜ·дҪҸжҲҝиҙ·ж¬ҫгҖӮйҮ‘иһҚжңәжһ„дјҡдҪҝз”ЁеӨҚжқӮзҡ„MLжЁЎеһӢжқҘиҺ·еҸ–е®ўжҲ·зҡ„家еәӯдәәеҸЈе’ҢйҮ‘иһҚеҺҶеҸІзӯүдҝЎжҒҜпјҢ并еҲӣе»әдёҖд»ҪжҠҘе‘ҠпјҢжқҘиҜҙжҳҺе®ўжҲ·жҳҜеҗҰжңүиө„ж јиҺ·еҫ—иҙ·ж¬ҫгҖӮ

еҰӮжһңиҜҘе®ўжҲ·иҝҗж°”дёҚдҪіпјҢзі»з»ҹи®Өе®ҡд»–/еҘ№жІЎжңүиө„ж јиҺ·еҫ—иҙ·ж¬ҫгҖӮйӮЈд№Ҳй—®йўҳжҳҜдҪҝз”ЁиҝҷдёӘзі»з»ҹзҡ„е•ҶдёҡдәәеЈ«иғҪеҗҰдҝЎд»»иҜҘжЁЎеһӢзҡ„еҶіе®ҡгҖӮиҝҷдёҺеүҚйқўзҡ„дҫӢеӯҗдёӯйқўдёҙзҡ„й—®йўҳзӣёеҗҢгҖӮд»ҘдёӢжҳҜдҪҝз”ЁиҜҘжЁЎеһӢзҡ„е•ҶдёҡдәәеЈ«еҸҜиғҪдјҡй—®зҡ„дёҖдәӣй—®йўҳпјҡ

В· еҰӮжһңе®ўжҲ·й—®дёәд»Җд№Ҳд»–/еҘ№зҡ„иҙ·ж¬ҫз”іиҜ·иў«жӢ’з»қпјҢжҲ‘иҜҘжҖҺд№Ҳеӣһзӯ”е‘ўпјҹ

В· MLжЁЎеһӢиғҪи§ЈйҮҠе’ҢиҜҒе®һе…¶еҶізӯ–иҝҮзЁӢпјҢд»ҘдҫҝжҲ‘们еҗ‘е®ўжҲ·жҠҘе‘Ҡеҗ—пјҹ

В· еңЁд»Җд№Ҳжғ…еҶөдёӢпјҢиҝҷдёӘжЁЎеһӢдёҚиғҪеҒҡеҮәжӯЈзЎ®зҡ„йў„жөӢпјҹжҲ‘们жҳҜеҗҰдјҡеӣ дёәдҝЎд»»MLжЁЎеһӢеҶізӯ–иҖҢеӨұеҺ»дёҖдёӘеҝ иҜҡзҡ„е®ўжҲ·пјҹ

жӯӨеӨ–д№ҹиҝҳжңүеҫҲеӨҡй—®йўҳпјҒеҰӮжһңдёҖ家公еҸёдҪҝз”ЁеӨҚжқӮзҡ„MLжЁЎеһӢпјҢ并且иҝҷдәӣжЁЎеһӢзҡ„еҶізӯ–еҜ№д»–们зҡ„е®ўжҲ·жңүеҫҲеӨ§еҪұе“ҚпјҢйӮЈд№Ҳе°ұеҸҜиғҪдјҡеҮәзҺ°еҫҲеӨҡй—®йўҳгҖӮ

йҮ‘иһҚеә”з”ЁдёӯдҪҝз”Ёзҡ„иҙ·ж¬ҫжЁЎеһӢ

XAIзҡ„жңӘжқҘжҳҜд»Җд№Ҳпјҹ

XAIзҡ„жңӘжқҘеҫҲйҡҫйў„жөӢпјҢеӣ дёәиҝҷжҳҜAI/MLйўҶеҹҹзҡ„дёҖдёӘзӣёеҪ“ж–°зҡ„йўҶеҹҹпјҢи®ёеӨҡз ”з©¶дәәе‘ҳиҝҳжӯЈеңЁз§ҜжһҒз ”з©¶ж–°зҡ„XAIжЁЎеһӢгҖӮ然иҖҢпјҢеҸҜд»ҘеҹәдәҺеҪ“еүҚзҡ„з ”з©¶и¶ӢеҠҝе’ҢиЎҢдёҡйңҖжұӮеҜ№XAIжЁЎеһӢиҝӣиЎҢйў„жөӢгҖӮеҮ е№ҙеҗҺпјҢеҪ“XAIжЁЎејҸеңЁеҗ„иЎҢдёҡзҡ„еә”з”ЁеҸҳеҫ—жӣҙеҠ жҲҗзҶҹж—¶пјҢеҸҜиғҪдјҡеҸ‘з”ҹд»ҘдёӢжғ…еҶөпјҡ

В· MLжЁЎеһӢе°ҶиғҪеӨҹи§ЈйҮҠиҮӘиә«зҡ„з»“жһңпјҒпјҲеҸҜд»Ҙе°Ҷе…¶жғіиұЎжҲҗгҖҠиҘҝйғЁдё–з•ҢгҖӢйҮҢзҡ„жңәеҷЁдәәиғҪеӨҹиҝӣиЎҢвҖңеҲҶжһҗвҖқпјү

В· жӣҙеӨҡеҸҜи§ЈйҮҠзҡ„жЁЎеһӢдјҡдә§з”ҹпјҢз”ЁжҲ·еҸҜдёҺе…¶дәӨдә’并дҝ®ж”№пјҲжҲ–ж”№иҝӣпјүз»“жһңгҖӮ

В· еӣ дёәжЁЎеһӢжҳҜеҸҜи§ЈйҮҠзҡ„пјҢ并且еҸҜд»ҘзҹҘйҒ“е®ғжҳҜеҰӮдҪ•еҒҡеҮәеҶіе®ҡзҡ„пјҢжүҖд»Ҙз”ЁжҲ·д№ҹи®ёиғҪеӨҹе°ҶиҮӘиә«зҹҘиҜҶжіЁе…ҘжЁЎеһӢпјҒ

еңЁе“ӘйҮҢеҸҜд»ҘеӯҰд№ жӣҙеӨҡе…ідәҺXAIзҡ„зҹҘиҜҶпјҹ

зҪ‘дёҠжңүеҫҲеӨҡеҸҜдҫӣеӯҰд№ зҡ„еңЁзәҝжқҗж–ҷгҖӮеҸҜи§ЈйҮҠMLжүӢеҶҢпјҲ

https://christophm.github.io/interpretable-ml-book/пјүжҳҜеҜ№XAIеҪ“еүҚж–№жі•зҡ„жҖ»дҪ“жҰӮиҝ°пјҢеҰӮжһңдҪ иҝҳдёҚзҶҹжӮүиҝҷдёӘйўҶеҹҹпјҢиҝҷдёӘжүӢеҶҢе°ҶжҳҜдёҖдёӘеҘҪзҡ„е…Ҙй—ЁгҖӮзҫҺеӣҪеӣҪйҳІйғЁй«ҳзә§з ”究计еҲ’еұҖпјҲDARPAпјүе…¬еёғдәҶдёҖд»Ҫе…ідәҺXAIдҪҝз”Ёзҡ„规еҲ’еӣҫпјҲhttps://www.darpa.mil/attachments/XAIProgramUpdate.pdfпјүпјҢеұ•зӨәдәҶ他们еңЁдёҚеҗҢXAIжЁЎеһӢе’Ңж–№жі•дёҠзҡ„е·ҘдҪңи®ЎеҲ’пјҢд»ҘеҸҠеҰӮдҪ•е°ҶXAIеә”з”ЁдәҺMLжЁЎеһӢгҖӮ

https://www.toutiao.com/a6728565544158495246/

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ