这篇文章给大家介绍mybatis-plus中大数据插入太慢如何解决,内容非常详细,感兴趣的小伙伴们可以参考借鉴,希望对大家能有所帮助。

我发现不管改成Mybatis Batch提交或者原生JDBC Batch的方法都不起作用,实际上在插入的时候仍然是一条条记录的插,速度远不如原来Mybatis的foreach拼接SQL的方法。

// 第一步判断更新或添加

String[] splitUserId = userGroup.getUserId().split(",");

String[] spiltUserName = userGroup.getUserName().split(",");

if (StringUtils.isBlank(userGroup.getId())) {

userGroup.setNum(spiltUserName.length);

userGroupMapper.insert(userGroup);

} else {

userGroup.setNum(spiltUserName.length);

userGroupMapper.updateById(userGroup);

}

/* 第二部删除中间表信息,字段冗余 */

Map<String, Object> columnMap = new HashMap<String, Object>();

columnMap.put("USER_GROUP_ID", userGroup.getId());

groupUsersService.removeByMap(columnMap);

/* 第三步,批量保存中间表 */

if (splitUserId.length != 0) {

List<GroupUsers> groupUsersList = Lists.newArrayList();

for (int i = 0; i < splitUserId.length; i++) {

GroupUsers gu = new GroupUsers();

gu.setUserId(splitUserId[i]);

gu.setUserName(spiltUserName[i]);

gu.setUserGroupId(userGroup.getId());

groupUsersList.add(gu);

}

groupUsersService.saveBatch(groupUsersList);

}就是这样的一种情景也很符合大部分的开发场景,可就是1000条数据的情况下用了8秒 ,这可能与计算机的性能有很大的关系,但就是如此也不至于用八秒钟,那么用户体验会很惨的。

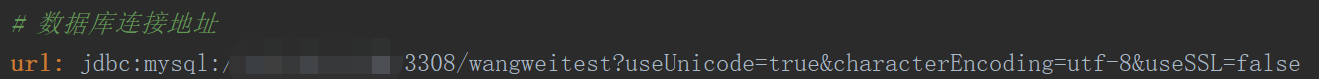

JDBC连接URL字符串中需要新增一个参数:rewriteBatchedStatements=true url: jdbc:mysql://192.168.1.143:3306/rt_xxxxxx_test?useUnicode=true&characterEncoding=utf-8&rewriteBatchedStatements=true

MySQL的JDBC连接的url中要加rewriteBatchedStatements参数,并保证5.1.13以上版本的驱动,才能实现高性能的批量插入。

MySQL JDBC驱动在默认情况下会无视executeBatch()语句,把我们期望批量执行的一组sql语句拆散,一条一条地发给MySQL数据库,批量插入实际上是单条插入,直接造成较低的性能。

只有把rewriteBatchedStatements参数置为true, 驱动才会帮你批量执行SQL

另外这个选项对INSERT/UPDATE/DELETE都有效

最近项目用的mybatis-plus做的映射,有个批处理文件内容的需求,在使用mybatis-plus的批处理方法saveBatch时发现速度特别慢,测试从1000到10000到80000条基本上是线性增加,80000条时差不多要90秒。

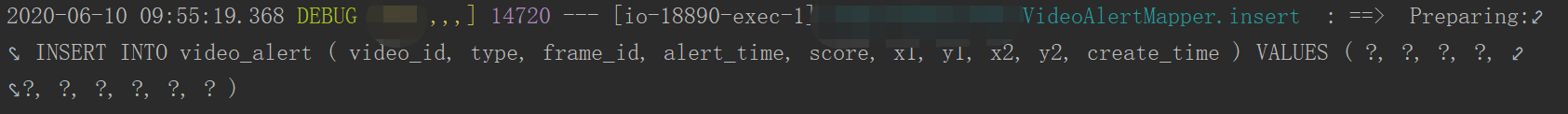

经debug排查sql语句是批量执行,所以应该不是框架本身的问题,由于用的是公司的手脚架,在mysql连接配置中发现了问题

这里少配置了一个参数rewriteBatchedStatements=true

结果

修改前24w数据大概在254709 ms

修改后24w数据大概在42506 ms

单次批量插入10000条大概在1700ms

关于mybatis-plus中大数据插入太慢如何解决就分享到这里了,希望以上内容可以对大家有一定的帮助,可以学到更多知识。如果觉得文章不错,可以把它分享出去让更多的人看到。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。