1.sqoop2-shell 进入 shell

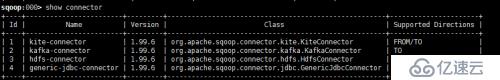

2.show connector 显示支持的连接方式

3.show link -all 查看已有连接的信息

ink with id 1 and name .168.1.188-1464317401319 (Enabled: true, Created by Administrator at 5/27/16 10:50 AM, Updated by Administrator at 5/27/16 10:50 AM)

Using Connector generic-jdbc-connector with id 4

Link configuration

JDBC Driver Class: com.mysql.jdbc.Driver

JDBC Connection String: ****************************************

Username:

Password:

JDBC Connection Properties:

4. create link -c 4 表示创建基于connector4 的link

创建的时候要输入步骤3显示的信息

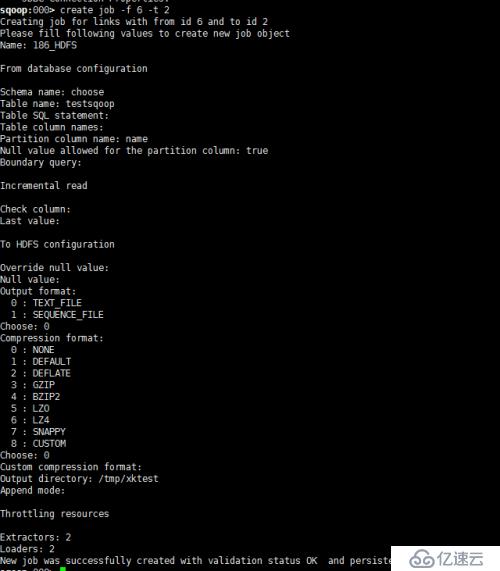

5create job -f -t

-f 从哪个link

-t 到哪个link

(schema name,table name )和 table sql statement 是互斥的只能写其中一个

table sql statement 要写${CONDITIONS}

check column 和last value 两个参数用作增量更新

这里选择普通文件(TEXT_FILE)和不压缩(NONE)的方式进行导入,方便查看导入文件

创建成功会返回id

用show job -jid 18 查看job,id为18的详细信息

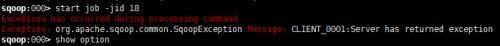

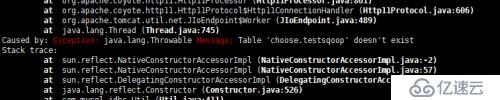

6.如果报错,想要显示具体的错误信息,可以执行下列语句。

sqoop:000> set option -name verbose -value true

Verbose option was changed to true

设置前

设置后,可以在报错信息中查看具体错误信息并排查。

start job -jid 18 -s

-s:表示实时显示job的执行进度,默认不写的话,只会显示到job开始

7status job -jid 18

显示 id为18的job的执行状态

显示执行成功

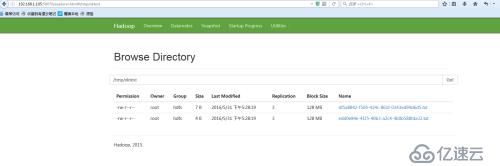

8.查看Hdfs控制台

表明已经导入成功,如果还不放心 可以用

hadoop dfs -cat /tmp/xktest/文件名

来查看文件具体内容是否和表中的相同。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。