这篇文章将为大家详细讲解有关如何理解Spark Streaming中动态Batch Size实现,文章内容质量较高,因此小编分享给大家做个参考,希望大家阅读完这篇文章后对相关知识有一定的了解。

Batch Duration和Process Time并不是线性相关的,当数据量增大时,仅仅增大Batch Duration是不能够解决问题的,还跟RDD涉及的算子有关。

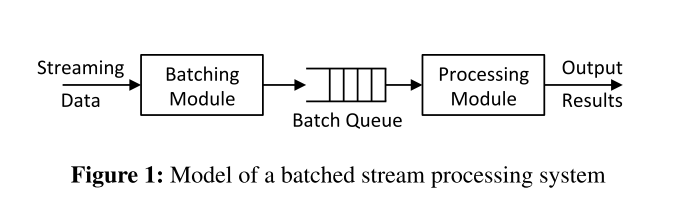

传统的数据处理应用中,采用J2EE和数据库的架构模式,但是当一秒内接收到的数据单台机器无法容纳或者无法处理时,就需要采用分布式流系统来处理接收到的数据。

采用分布式流处理系统时,还会遇到数据量突发增大,此时需要考虑峰值。论文《dynamic_batching》提到动态Batch Size的思想,尽量把Batch变小,处理就会越快,也就越安全。

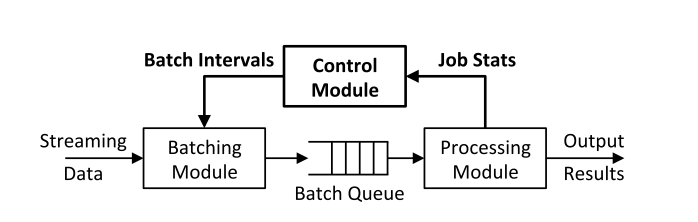

引入控制模块,从Process Time的信息来改变Batch Interval。

引入控制模块,从Process Time的信息来改变Batch Interval。

关于如何理解Spark Streaming中动态Batch Size实现就分享到这里了,希望以上内容可以对大家有一定的帮助,可以学到更多知识。如果觉得文章不错,可以把它分享出去让更多的人看到。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。