本篇内容介绍了“如何解决HBase-Spark无法在Spark2编译通过的问题”的有关知识,在实际案例的操作过程中,不少人都会遇到这样的困境,接下来就让小编带领大家学习一下如何处理这些情况吧!希望大家仔细阅读,能够学有所成!

1

编译异常

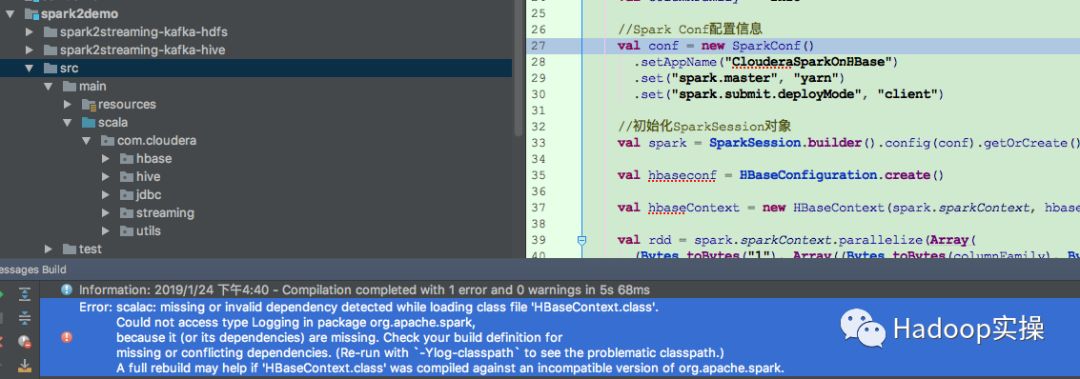

在Spark2代码中使用hbase-spark依赖包访问HBase时,编写的代码无法完成编译,在编译的过程中提示如下错误:

Error:scalac: missing or invalid dependency detected while loading class file 'HBaseContext.class'.

Could not access type Logging in package org.apache.spark,

because it (or its dependencies) are missing. Check your build definition for

missing or conflicting dependencies. (Re-run with `-Ylog-classpath` to see the problematic classpath.)

A full rebuild may help if 'HBaseContext.class' was compiled against an incompatible version of org.apache.spark.

运行工程编译命令时提示“Could not access type Logging in package org.apache.spark”

2

问题分析

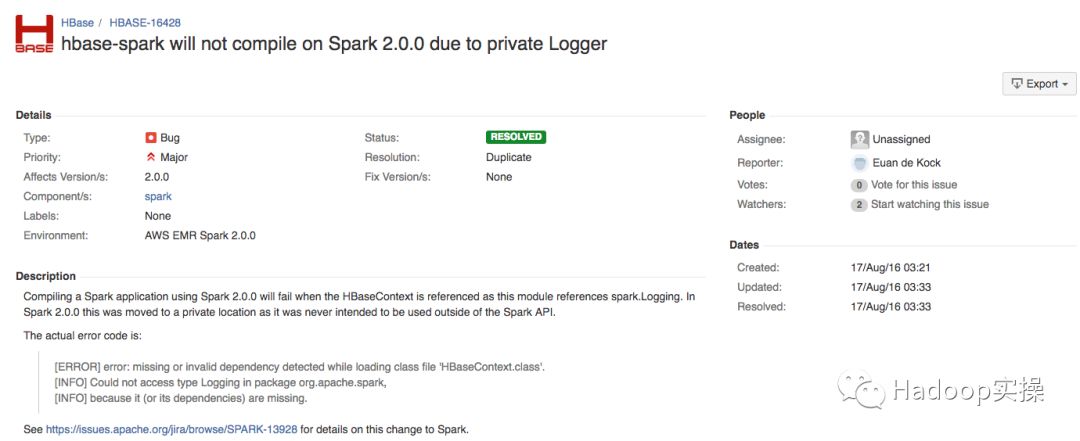

经过查看资料找到HBase官网的一个JIRA,地址:

https://issues.apache.org/jira/browse/HBASE-16428

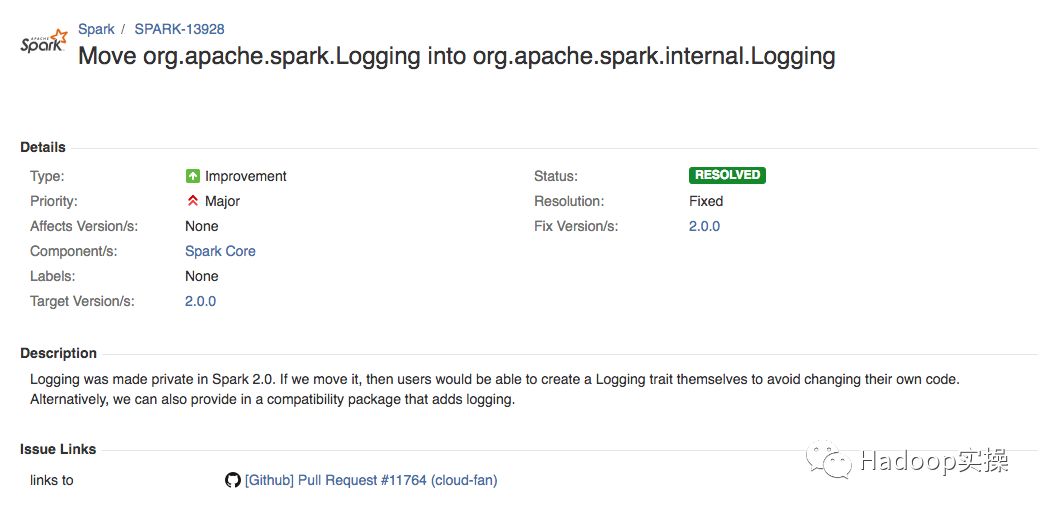

JIRA中找到在代码中引用了HBaseContext时,使用Spark2编译Spark应用程序将会失败,因为HBaseContext模块引用了org.apache.spark.Logging。在Spark2中,由于Logging被移动到一个私有的包下导致。同样也有Spark2的一个JIRA说明该问题:

https://issues.apache.org/jira/browse/SPARK-13928

3

问题解决

为了完成编译,这里Fayson使用如下做法解决该问题:

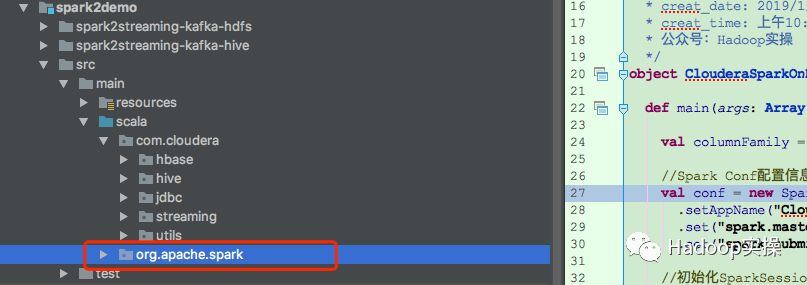

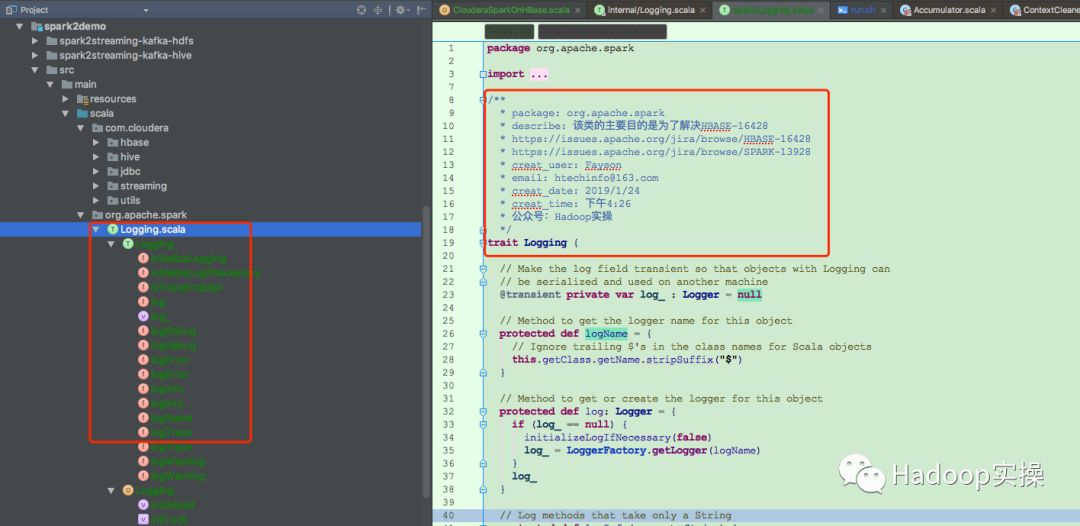

1.在自己的工程下创建一个org.apache.spark的包

2.在org.apache.spark包下创建一个Trait类型的Logging.scala类型,该类的内容通过Spark2源码找到

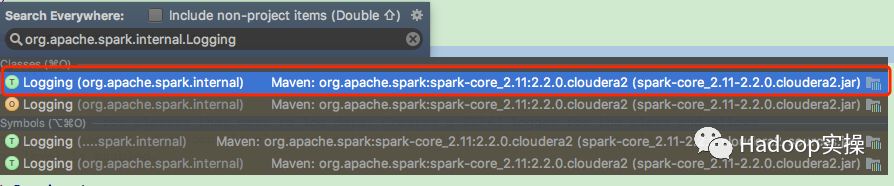

将spark-core工程下org.apache.spark.internal.Logging类内容拷贝至我们工程下创建的org.apache.spark.Logging类中。

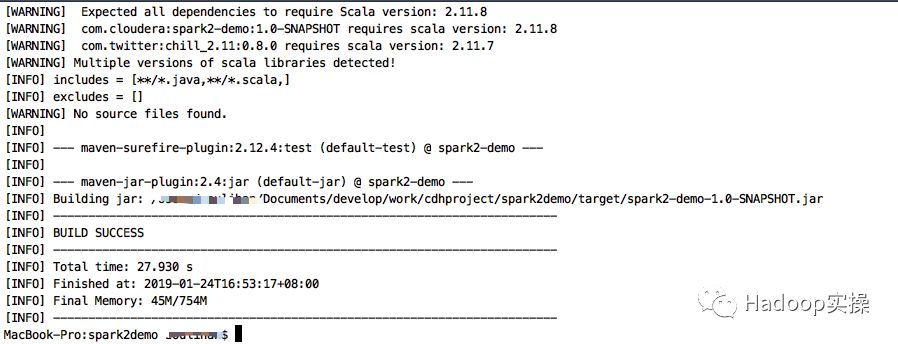

4.完成上述操作后,再次执行编译,可以正常的完成编译

4

总结

1.通过异常分析,由于Logging类在Spark2中私有化了,那在自己的工程中创建重写一个Logging类方式解决该问题。

2.Logging类的内容要确保与对应Spark2版本代码一致,避免造成一些莫名其妙的问题。

“如何解决HBase-Spark无法在Spark2编译通过的问题”的内容就介绍到这里了,感谢大家的阅读。如果想了解更多行业相关的知识可以关注亿速云网站,小编将为大家输出更多高质量的实用文章!

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。