怎么进行Hive原理实践,针对这个问题,这篇文章详细介绍了相对应的分析和解答,希望可以帮助更多想解决这个问题的小伙伴找到更简单易行的方法。

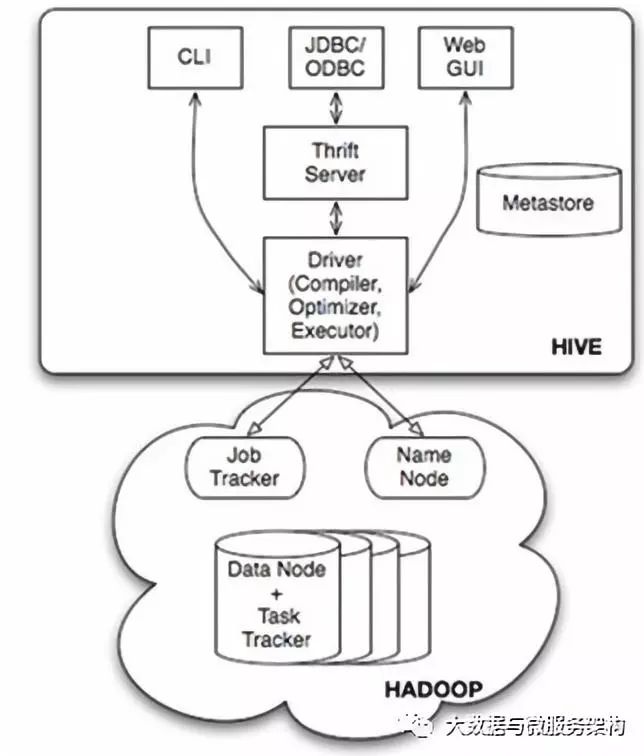

Hive基本架构

Driver组件:核心组件,整个Hive的核心,该组件包括Complier(编译器)、Optimizer(优化器)和Executor(执行器),它们的作用是对Hive SQL语句进行解析、编译优化,生成执行计划,然后调用底层的MapReduce计算框架。

Metastore组件:元数据服务组件,这个组件存储Hive的元数据。支持的关系型数据库有Derby和MySQL。

CLI:命令行接口

Thrift Server:提供JDBC和ODBC接入能力,用户进行可扩展且跨语言的服务开发。Hive集成了该服务,能让不同的编程语言调用Hive的接口。

Hive Web Interface(HWI):Hive客户端提供了一种通过网页方式访问Hive所提供的服务。这个接口对应Hive的HWI组件。

Hive通过CLI、JDBC/ODBC 或者HWI接收相关的Hive SQL查询,并通过Driver组件进行编译,分析优化,最后变成可执行的MapReduce。

HIVE SQL

hive表:分内部表和外部表

内部表:会把hdfs目录文件移动到hive对应的目录。删除表对应的表接口和文件也会一起删除。

外部表:不会移动关联的hdfs文件,删除表只会删除表结构。

使用场景:如果数据的所有处理都在hive中进行,那么更倾向于选择内部表,但如果Hive和其它工具针对相同的数据集做处理,那么外部表更合适。

分区和分桶

分区可以让数据的部分查询变更更快,表或者分区可以进一步划分为桶,桶通常在原始数据中加入一些额外的结构,这些结构可以用于高效查询。

分桶通常有两个原因:一是高效查询,二是高效的进行抽样。

Hive SQL执行原理:

大致归三类:select语句、group by 语句、join语句。

流程:输入分片->Map阶段->Combiner(可选)->Shuffle阶段(分区、排序、分隔、复制、合并等过程)-> Reduce阶段-> 输出文件。

其他SQL on Hadoop技术:Impala、Drill、HAWQ、Presto、Dremel、Spark SQL。

Hive优化

主要挑战数据倾斜:group by 引起的倾斜优化、Count distinct 优化、大表join小表(mapjoin)优化、大表join大表优化。

关于怎么进行Hive原理实践问题的解答就分享到这里了,希望以上内容可以对大家有一定的帮助,如果你还有很多疑惑没有解开,可以关注亿速云行业资讯频道了解更多相关知识。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。