这篇“Python如何实现抖音热搜定时爬取功能”文章的知识点大部分人都不太理解,所以小编给大家总结了以下内容,内容详细,步骤清晰,具有一定的借鉴价值,希望大家阅读完这篇文章能有所收获,下面我们一起来看看这篇“Python如何实现抖音热搜定时爬取功能”文章吧。

整个热榜共50条数据,本次爬取的内容:排名、热度、标题、链接。

requests 是一种非常简单的方法,由于该页面没有反爬措施,所以直接get 请求页面即可。

import requests

import pandas as pd

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/94.0.4606.54 Safari/537.36'

}

url = 'https://tophub.today/n/K7GdaMgdQy'

page_text = requests.get(url=url, headers=headers).text

page_text

可以看到,只需要几行代码,数据就很轻松地获取到了。

将selenium设置为无头浏览器,打开指定url获取页面数据。

from selenium import webdriver

option = webdriver.ChromeOptions()

option.add_argument('--headless')

driver = webdriver.Chrome(options=option)

url = 'https://tophub.today/n/K7GdaMgdQy'

driver.get(url)

page_text = driver.page_source两种爬取方法都能够成功获取到数据,但requests相对简洁,整个代码运行速度也更快,如果页面数据不是动态加载的话,用requests相对方便。

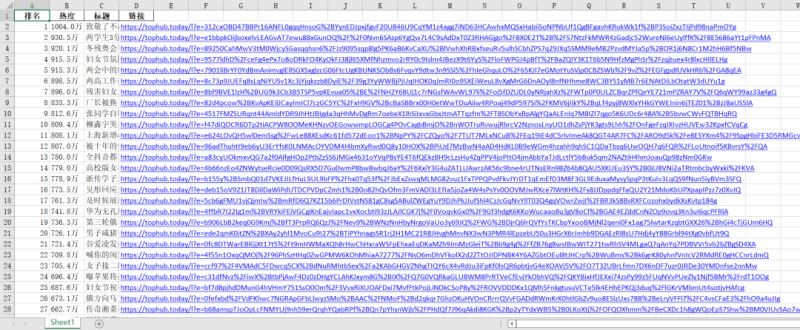

现在用lxml库解析我们爬取的数据,并保存到excel中。

tree = etree.HTML(page_text)

tr_list = tree.xpath(

'//*[@id="page"]/div[2]/div[2]/div[1]/div[2]/div/div[1]/table/tbody/tr')

df = pd.DataFrame(columns=['排名', '热度', '标题', '链接'])

for index, tr in enumerate(tr_list):

hot = tr.xpath('./td[3]/text()')[0]

title = tr.xpath('./td[2]/a/text()')[0]

article_url = tr.xpath('./td[2]/a/@href')[0]

df = df.append({

'排名': index + 1,

'热度': hot,

'标题': title,

'链接': article_url}, ignore_index=True)

df['链接'] = 'https://tophub.today' + df['链接']

df运行结果

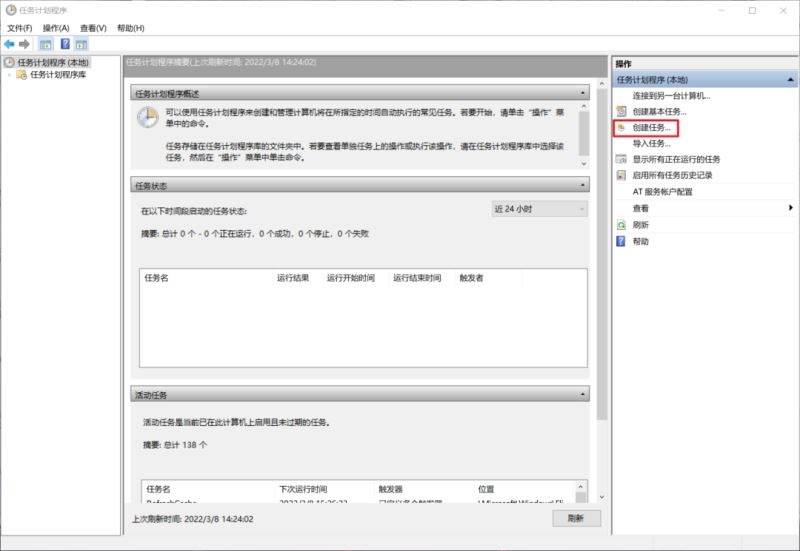

至此,爬取代码已经完成,想要实现每小时自动运行代码,可以使用任务计划程序。

打开任务计划程序,【创建任务】

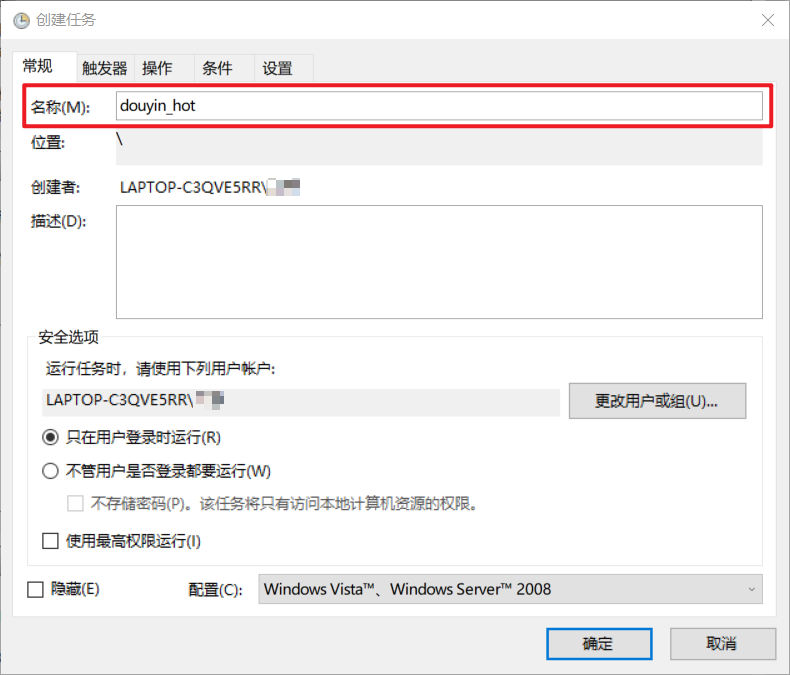

输入名称,名称随便起就好。

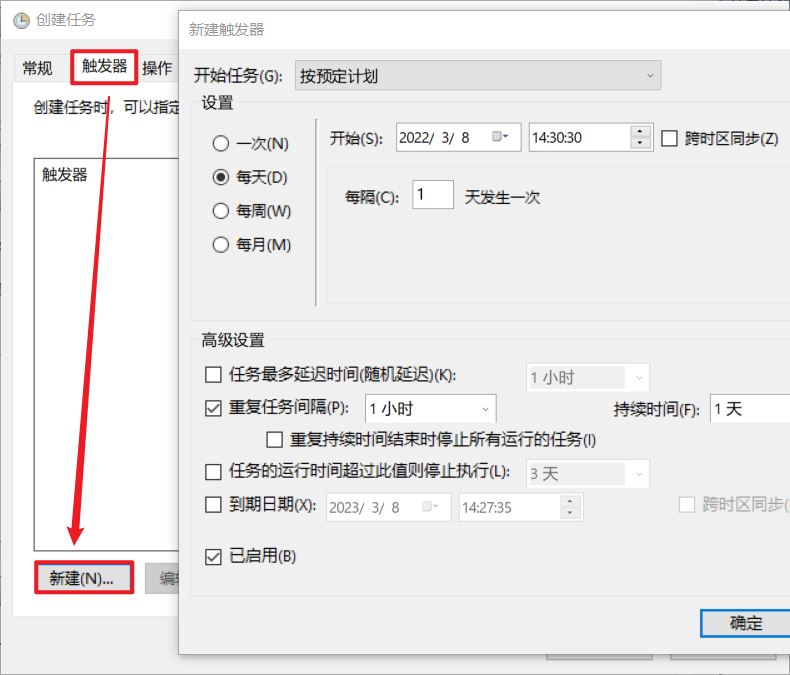

选择【触发器】>>【新建】>>【设置触发时间】

选择【操作】>>【新建】>>【选择程序】

最后确认即可。到时间就会自动运行,或者右键任务手动运行。

以上就是关于“Python如何实现抖音热搜定时爬取功能”这篇文章的内容,相信大家都有了一定的了解,希望小编分享的内容对大家有帮助,若想了解更多相关的知识内容,请关注亿速云行业资讯频道。

亿速云「云服务器」,即开即用、新一代英特尔至强铂金CPU、三副本存储NVMe SSD云盘,价格低至29元/月。点击查看>>

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。