жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

еңЁдәҶи§ЈдәҶS2Dеҹәжң¬жҰӮеҝөеҸҠжһ¶жһ„д»ҘеҗҺпјҢжҲ‘们жҺҘдёӢжқҘеҒҡдёҖдәӣе…·дҪ“зҡ„й…ҚзҪ®еҸҠжөӢиҜ•гҖӮжң¬е®һйӘҢзҺҜеўғжҗӯеңЁvCenter6.0u2дёҠпјҢй…ҚзҪ®еӣӣеҸ°иҷҡжңәдҪңдёәS2Dзҡ„иҠӮзӮ№пјҢжҜҸеҸ°иҷҡжңәзҡ„е…·дҪ“й…ҚзҪ®еҰӮдёӢпјҡ

OSпјҡWindows 2016 datacenter

4 vCPU& 8GB RAM

4 vNics

1дёӘ40GBзЈҒзӣҳиЈ…OSпјӣеҸҰеӨ–еҶҚж·»еҠ 2 x 50GBпјҲжЁЎжӢҹPCIe SSDпјүпјӣ2 x 100GBпјҲжЁЎжӢҹSSDпјүпјӣ4 x 300GBпјҲHDDпјү

жң¬жөӢиҜ•зҡ„и®ҫжғіжҳҜе°ҶжЁЎжӢҹзҡ„NVMe PCIe SSDзЈҒзӣҳдҪңдёәиҜ»еҶҷзј“еӯҳдҪҝз”ЁпјҢиҖҢжҠҠSSDе’ҢHDDдҪңдёәе®№йҮҸеұӮгҖӮS2Dжң¬иә«еҫҲзҒөжҙ»пјҢж”ҜжҢҒе…Ёй—Әеӯҳй…ҚзҪ®жҲ–иҖ…ж··еҗҲзЈҒзӣҳй…ҚзҪ®пјҢеҸ–еҶідәҺе®ўжҲ·з»“еҗҲе…¶еә”з”ЁеҜ№жҖ§иғҪпјҢе®№йҮҸеҸҠд»·ж јзҡ„з»јеҗҲиҖғйҮҸгҖӮдёӘдәәж„ҹи§үе®һйҷ…еә”з”ЁдёӯдёӨеұӮзЈҒзӣҳй…ҚзҪ®жҳҜжҜ”иҫғеҗҲйҖӮзҡ„гҖӮиҝҷйҮҢжЁЎжӢҹдёүеұӮй…ҚзҪ®жҳҜеёҢжңӣиғҪжӣҙеӨҡең°жөӢиҜ•жҺўеҜ»е…¶е·ҘдҪңжңәеҲ¶гҖӮеҫ®иҪҜдёӢйқўиҝҷзҜҮеҚҡе®ўж–Үз« еҫҲеҘҪең°и§ЈйҮҠдәҶS2Dзј“еӯҳеҺҹзҗҶеҸҠжңҖдҪіе®һи·өпјҢиҝҷйҮҢе°ұдёҚеҶҚиөҳиҝ°гҖӮеҸӘиҰҒдҪҝз”Ёеҫ®иҪҜи®ӨиҜҒеҲ—иЎЁйҮҢзҡ„硬件пјҢеңЁеҗҜз”ЁS2Dж—¶зі»з»ҹдјҡиҮӘеҠЁе°ҶжңҖй«ҳеұӮзә§зҡ„зЈҒзӣҳи®ҫзҪ®дёәиҜ»еҶҷзј“еӯҳпјҲй»ҳи®Өй’ҲеҜ№SSDзЈҒзӣҳеҸӘдҪңдёәеҶҷзј“еӯҳпјӣй’ҲеҜ№HDDзЈҒзӣҳдҪңдёәиҜ»еҶҷзј“еӯҳпјүгҖӮдҪҶеңЁиҷҡжӢҹжңәдёҠжөӢиҜ•ж—¶пјҢзЈҒзӣҳзұ»еһӢе’ҢдҪҝз”Ёж–№ејҸжңүж—¶йңҖиҰҒжүӢе·ҘжҢҮе®ҡгҖӮеҗҺз»ӯжӯҘйӘӨйҮҢжңүе…·дҪ“е‘Ҫд»Өе’ҢжҲӘеӣҫдҫӣеӨ§е®¶еҸӮиҖғгҖӮ

https://docs.microsoft.com/en-us/windows-server/storage/storage-spaces/understand-the-cache

дёӢйқўжҲ‘们иҝҮжёЎеҲ°е…·дҪ“зҡ„й…ҚзҪ®жӯҘйӘӨпјҡ

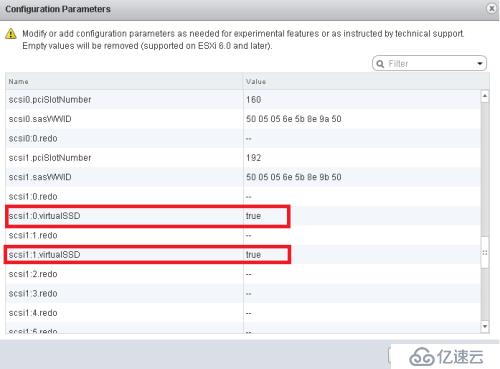

1.жҲ‘们е°ҶеңЁеҗҺз»ӯжӯҘйӘӨйҮҢз”ЁPowershellе‘Ҫд»ӨжҢҮе®ҡ50GBзЈҒзӣҳзұ»еһӢдёәSCMпјӣиҝҷйҮҢе…Ҳзј–иҫ‘жҜҸдёҖеҸ°иҷҡжңәзҡ„ vmxй…ҚзҪ®ж–Ү件пјҢж·»еҠ пјҡscsi x:x.virtualSSD = "true"гҖӮжҲ–иҖ…жү“ејҖиҷҡжңәи®ҫзҪ®йҖүйЎ№--гҖӢVM option--гҖӢAdvanced Settings--гҖӢConfiguration Parameters--гҖӢEdit Configuration,еңЁеҰӮдёӢз•ҢйқўйҮҢзӣҙжҺҘж·»еҠ пјҢе°ҶеҜ№еә”зҡ„дёӨеқ—100GBзЈҒзӣҳи®ҫзҪ®дёәSSDзұ»еһӢпјҡ

2. е°ҶеӣӣеҸ°иҷҡжңәе®үиЈ…еҘҪW2016еҗҺпјҢж·»еҠ жүҖйңҖзҡ„вҖңfile and storage servicesвҖқи§’иүІеҸҠ"failover cluster"еҠҹиғҪпјҢеҒҡеҘҪзҪ‘з»ңзӯүеҹәжң¬й…ҚзҪ®пјҢеҠ е…ҘеҹҹгҖӮеҸҜж №жҚ®йңҖиҰҒдҪҝз”ЁVM-Host affinityзҡ„и®ҫзҪ®е°ҶиҷҡжңәеҲҶеҲ«зҪ®дәҺдёҚеҗҢзҡ„зү©зҗҶжңәдёҠд»ҘеўһеҠ й«ҳеҸҜз”ЁжҖ§гҖӮеҸҜеҲҶеҲ«е°ҶдёӨеқ—иҷҡжӢҹзҪ‘еҚЎй…ҚзҪ®дёәTeamпјҢй…ҚзҪ®дёҚеҗҢзҡ„зҪ‘ж®өпјҢеҲҶеҲ«з”ЁдәҺз”ҹдә§зҪ‘з»ңе’ҢClusterиҠӮзӮ№зҡ„йҖҡдҝЎгҖӮ

3.е°Ҷиҷҡжңәй…ҚзҪ®зҫӨйӣҶж—¶е®№жҳ“иў«еҝҪз•ҘеҚҙеҸҲиҮіе…ійҮҚиҰҒзҡ„з»ҶиҠӮжҳҜзі»з»ҹж—¶й’ҹзҡ„и®ҫзҪ®гҖӮиҷҡжңәе®үиЈ…дәҶVMware Toolsд№ӢеҗҺпјҢй»ҳи®ӨдјҡеңЁд»ҘдёӢжғ…еҶөиҮӘеҠЁе°ҶVMзҡ„ж—¶й—ҙе’Ңе®ҝдё»жңәж—¶й’ҹеҒҡж ЎеҮҶпјҡпјҲ1пјүиҷҡжңәзі»з»ҹйҮҚеҗҜжҲ–иҖ…д»ҺжҢӮиө·зҠ¶жҖҒжҒўеӨҚж—¶пјӣпјҲ2пјүиҷҡжңәVMotionеҲ°е…¶д»–дё»жңәж—¶пјӣпјҲ3пјүеҲӣе»әжҲ–иҖ…жҒўеӨҚеҝ«з…§пјҢжҲ–е…¶д»–е‘Ҫд»ӨеҜјиҮҙиҮӘеҠЁи§ҰеҸ‘жӯӨзұ»ж“ҚдҪңж—¶пјӣпјҲ4пјүйҮҚеҗҜVMWARE ToolжңҚеҠЎд»ҘеҗҺгҖӮеҰӮжһңе®ҝдё»жңәж—¶й’ҹдёҚеҮҶеҲҷдјҡеҜјиҮҙеҫҲеӨҡй—®йўҳгҖӮжүҖд»Ҙе»әи®®ж №жҚ®VMware KB1189е…ій—ӯиҝҷеҮ еҸ°S2DиҠӮзӮ№зҡ„VMWARE Toolsж—¶й’ҹеҗҢжӯҘжңҚеҠЎпјҢејҖеҗҜзі»з»ҹWindows TimeжңҚеҠЎпјҢдҪҝе…¶иҮӘеҠЁе’ҢеҹҹжҺ§еҒҡж—¶й’ҹеҗҢжӯҘгҖӮеҰӮжһңзҪ‘з»ңйҮҢжңүзІҫеҮҶзҡ„ж—¶й’ҹжңҚеҠЎеҷЁеҲҷжӣҙеҘҪгҖӮ

https://kb.vmware.com/selfservice/microsites/search.do?language=en_US&cmd=displayKC&externalId=1189

4.еҒҡеҘҪзҫӨйӣҶеҲӣе»әеүҚзҡ„еҮҶеӨҮе·ҘдҪңпјҢжҜ”еҰӮд»ІиЈҒзӣҳзҡ„й…ҚзҪ®зӯүгҖӮжҺҘдёӢжқҘеңЁеӣҫеҪўз•ҢйқўйҮҢжҲ–иҖ…д»Ҙз®ЎзҗҶе‘ҳиә«д»ҪиҝҗиЎҢPowershellпјҢиҫ“е…Ҙд»ҘдёӢе‘Ҫд»ӨдёәжҜҸдёҖеҸ°дё»жңәж·»еҠ Failover Clusteringзҡ„еҠҹиғҪпјҲеҰӮжһңиҝҳжІЎжңүж·»еҠ пјүпјҢ并еҲӣе»әж–°зҡ„зҫӨйӣҶпјҡ

Add-WindowsFeature -Name failover-clustering -IncludeManagementTools -ComputerName xxx.yourdomain.com -Verbose -Credential yourdomain\administrator

New-Cluster -Name xxxx -StaticAddress x.x.x.x -Node node1.yourdomain.com,node2.yourdomain.com,node3.yourdomain.com,node4.yourdomain.com -Verbose

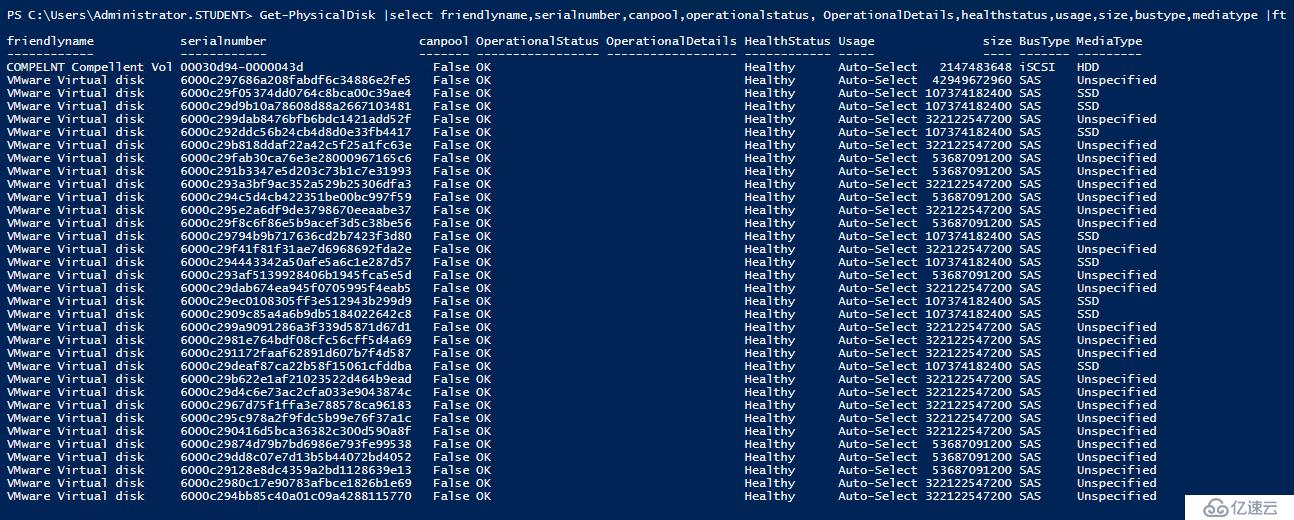

5.жү“ејҖе»әеҘҪзҡ„зҫӨйӣҶиҠӮзӮ№йҮҢзҡ„Powershell ISEпјҢиҫ“е…Ҙзұ»дјјд»ҘдёӢе‘Ҫд»ӨжҹҘзңӢжүҖжңүиҠӮзӮ№иҙЎзҢ®еҮәжқҘзҡ„зү©зҗҶзЈҒзӣҳиҜҰз»ҶдҝЎжҒҜпјҡ

Get-PhysicalDisk |select friendlyname,serialnumber,canpool,operationalstatus, OperationalDetails,healthstatus,usage,size,bustype,mediatype|ft

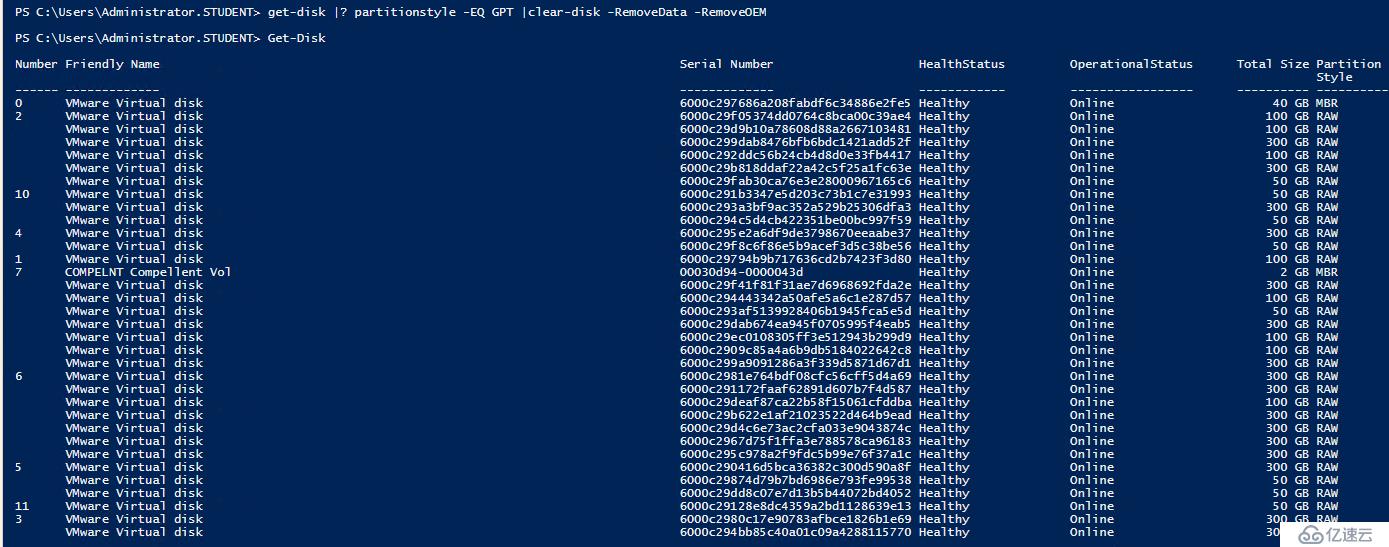

е°ҸжҸҗйҶ’пјҡеҰӮжһңжөӢиҜ•жҳҜеңЁзү©зҗҶе№іеҸ°дёҠиҝӣиЎҢпјҢжңҖеҘҪе…Ҳз”ЁClear-disk -removedata -removeOEMе‘Ҫд»Өе°ҶжүҖжңүиҠӮзӮ№з”Ёд»Ҙжһ„е»әеӯҳеӮЁжұ зҡ„зЎ¬зӣҳзҡ„дҝЎжҒҜе…ЁйғЁжё…йҷӨе№ІеҮҖгҖӮиҜҘе‘Ҫд»ӨжӯЈеёёжү§иЎҢзҡ„еүҚжҸҗжҳҜеҜ№еә”зЈҒзӣҳйңҖиҰҒдҝқжҢҒеңЁзәҝзҠ¶жҖҒгҖӮиҫ“еҮәз»“жһңзұ»дјјдёӢеӣҫпјҢеңЁPartition StyleдёҖж ҸпјҢзЈҒзӣҳе…ЁйғЁжҳҜRAWзҠ¶жҖҒпјҡ

6.еңЁз”ҹдә§зҺҜеўғжҗӯе»әS2Dж—¶пјҢиҜ·зЎ®дҝқеҗ„зұ»зЎ¬д»¶ж»Ўи¶іеҫ®иҪҜе®ҳж–№зҡ„е…је®№еҲ—иЎЁгҖӮеңЁжң¬жөӢиҜ•зҺҜеўғдёӯпјҢжҹҘзңӢзү©зҗҶзЈҒзӣҳж•°йҮҸпјҢзҠ¶жҖҒйғҪжІЎжңүй—®йўҳеҗҺпјҢеҰӮжһңеҸ‘зҺ°жңүдәӣзұ»еһӢзЈҒзӣҳжІЎжңүиў«жӯЈзЎ®иҜҶеҲ«пјҢеҸҜе°қиҜ•з”Ёе‘Ҫд»ӨжүӢе·ҘжҢҮе®ҡе…¶зЈҒзӣҳзұ»еһӢпјҢдҪҶжҳҜзЈҒзӣҳзұ»еһӢжҳҜе…¶еңЁеӯҳеӮЁжұ йҮҢзҡ„еұһжҖ§д№ӢдёҖпјҢжүҖд»Ҙеҝ…йЎ»е…ҲжҠҠжүҖжңүзЈҒзӣҳж·»еҠ еҲ°еӯҳеӮЁжұ еҗҺжүҚиғҪжүӢе·Ҙи®ҫзҪ®е…¶зұ»еһӢгҖӮиҝҷйҮҢжҲ‘们е…ҲејҖеҗҜS2DпјҢ并жҡӮж—¶е…ій—ӯзј“еӯҳпјҢ并跳иҝҮзЈҒзӣҳжЈҖжөӢпјҡ

Enable-ClusterS2D -CacheState disabled -AutoConfig:0 -SkipEligibilityChecks

7.з”ЁNew-storagepoolе‘Ҫд»ӨеҲӣе»әиҮӘе·ұзҡ„еӯҳеӮЁжұ пјҢеҲӣе»әж—¶еҸҜд»Ҙе°ҶдёҚеҗҢзҡ„зЈҒзӣҳж”ҫзҪ®дәҺдёҚеҗҢзҡ„жұ дёӯгҖӮиҝҷйҮҢжҲ‘们е°ҶжүҖжңүзЈҒзӣҳж”ҫе…ҘдёҖдёӘеӯҳеӮЁжұ вҖңmys2dpool1вҖқгҖӮ

New-StoragePool -StorageSubSystemFriendlyName *cluster* -FriendlyName mys2dpool1 -ProvisioningTypeDefault Fixed -PhysicalDisks (Get-PhysicalDisk|? canpool -EQ "true")

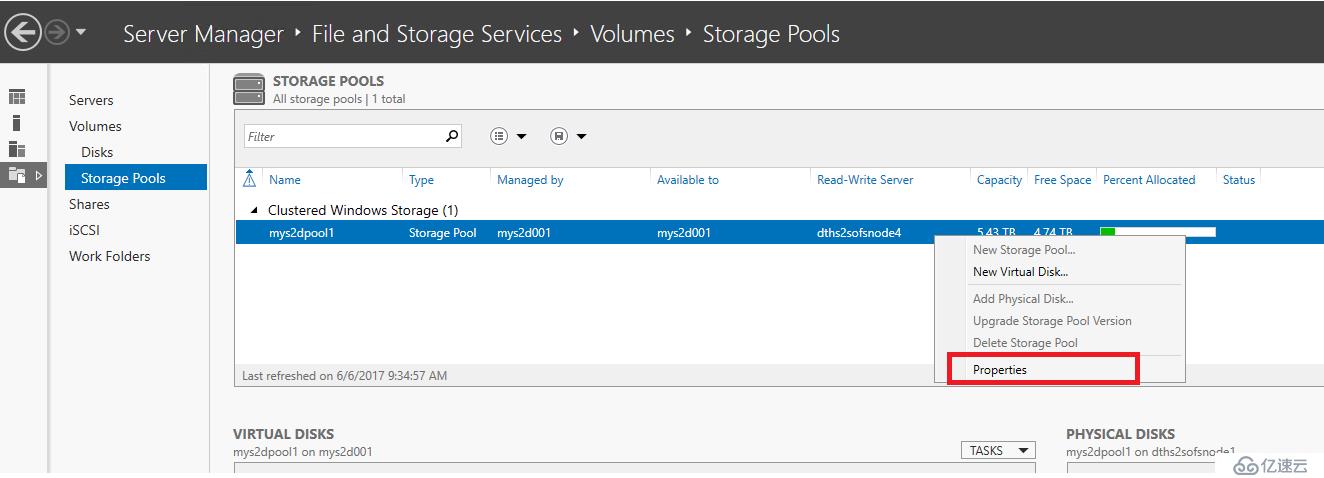

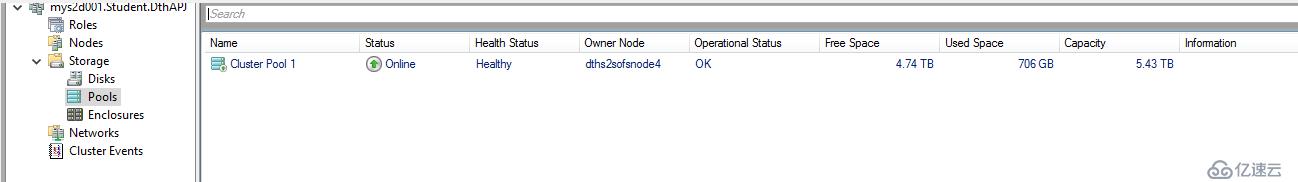

е®ҢжҲҗеҗҺеҸҜз”ЁGet-storagepoolе‘Ҫд»ӨжҹҘзңӢе…¶зҠ¶жҖҒгҖӮжҲ–иҖ…иҝӣе…ҘServer ManagerеӣҫеҪўз•ҢйқўжҹҘзңӢпјҢеҰӮдёӢеӣҫзӨәпјҡ

еңЁFailover ManagerйҮҢзҡ„зҠ¶жҖҒпјҡ

дёӢеӣҫжҳҜеҠ е…ҘеӯҳеӮЁжұ еҗҺзҡ„зү©зҗҶзЈҒзӣҳиҜҰз»ҶдҝЎжҒҜпјҢеҸҜд»ҘзңӢеҲ°пјҢйҷӨдәҶ8еқ—SSDзЈҒзӣҳеӨ–пјҢ300GBзҡ„HDDе’Ң50GBзҡ„NVMe PCIe SSDзұ»еһӢзЈҒзӣҳйғҪжІЎжңүиў«иҜҶеҲ«пјҡ

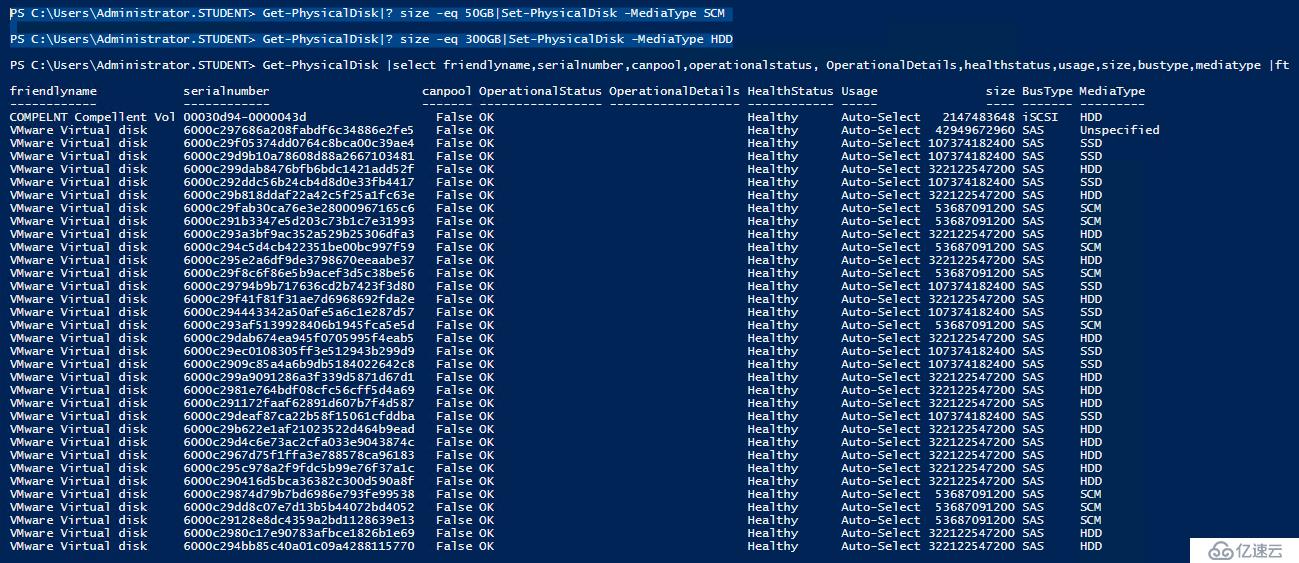

8.жҺҘдёӢжқҘз”ЁдёӢйқўе‘Ҫд»Өе°ҶжІЎжңүиҜҶеҲ«зҡ„50GBзЈҒзӣҳжҢҮе®ҡдёәSCMзұ»еһӢпјҡ

Get-PhysicalDisk |where {$_.mediatype -eq "unspecified" -and $_.canpool} | Set-PhysicalDisk -MediaType SCM

иҜҘе‘Ҫд»ӨеҸҜзҒөжҙ»з»„еҗҲпјҢеҰӮж №жҚ®зЈҒзӣҳеӨ§е°ҸиҝӣиЎҢеҲҶзұ»жҢҮе®ҡпјҢжҲ‘们еҶҚз”ЁдёӢйқўе‘Ҫд»Өе°Ҷ300GBзЈҒзӣҳзұ»еһӢи®ҫзҪ®дёәHDDпјҡ

Get-PhysicalDisk|where{$_.size -eq 322122547200}|Set-PhysicalDisk -MediaType HDD

е®ҢжҲҗеҗҺGet-physicaldiskе‘Ҫд»Өиҫ“еҮәеҰӮдёӢеӣҫзӨәпјҡ

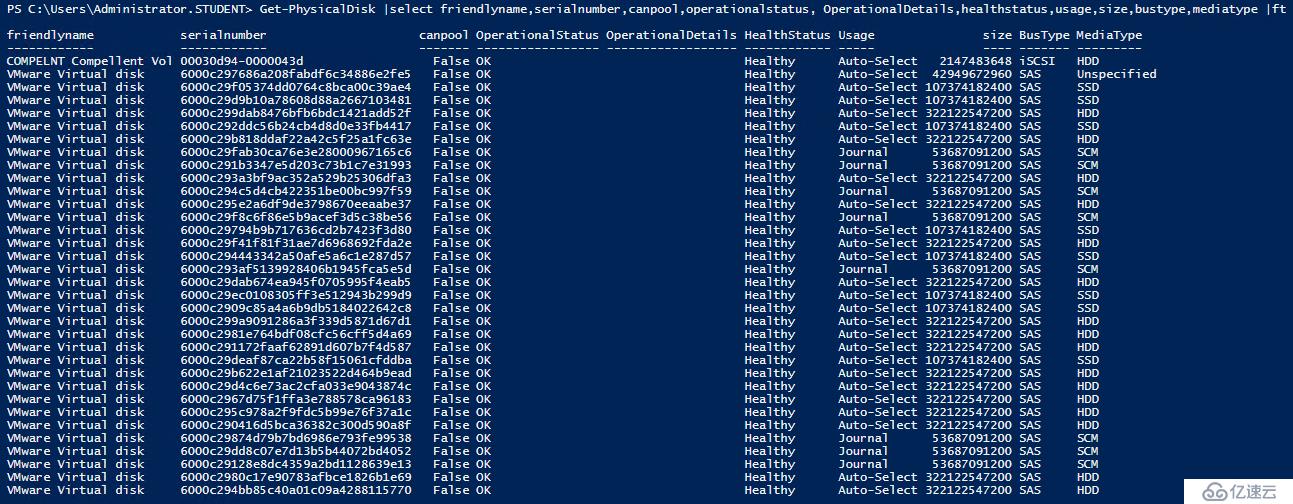

9.S2Dзі»з»ҹеңЁеҲӣе»әеӯҳеӮЁжұ ж—¶дјҡиҮӘеҠЁжҠҠжңҖй«ҳеұӮзә§зҡ„зЈҒзӣҳеҪ“еҒҡиҜ»еҶҷзј“еӯҳз”ЁгҖӮжң¬дҫӢдёӯйңҖиҰҒжүӢе·Ҙи°ғж•ҙжҠҠSCMжҢҮе®ҡдёәзј“еӯҳеұӮпјҲjournalпјүпјҡ

Get-PhysicalDisk|where{$_.mediatype -eq "scm"}|Set-PhysicalDisk -Usage Journal

е®ҢжҲҗеҗҺеҶҚз”Ёget- physicaldiskе‘Ҫд»ӨжҹҘзңӢжңҖеҗҺзү©зҗҶзЈҒзӣҳзҠ¶жҖҒгҖӮзЎ®дҝқж— иҜҜгҖӮ

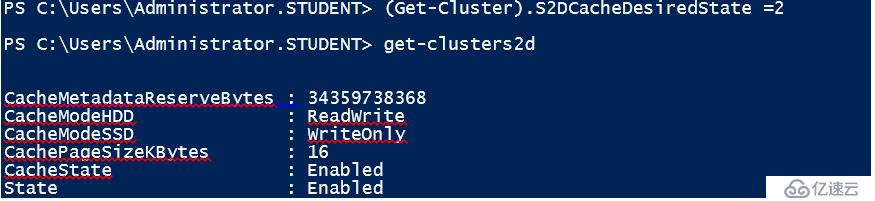

10.жҺҘзқҖејҖеҗҜS2Dзҡ„зј“еӯҳ:

(Get-Cluster).S2DCacheDesiredState= 2

е®ҢжҲҗеҗҺеҸҜз”ЁGet-clusters2dжҹҘзңӢе…¶зҠ¶жҖҒпјҡ

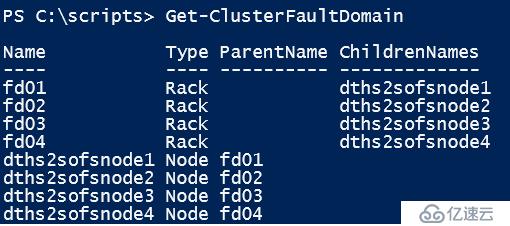

11.е’ҢVMWARE VSANзұ»дјјпјҢS2Dд№ҹеҸҜд»Ҙж”ҜжҢҒдёҚеҗҢзұ»еһӢзҡ„ж•…йҡңеҹҹд»ҘеўһејәеңЁз”ҹдә§зҺҜеўғйҮҢзҡ„й«ҳеҸҜз”ЁжҖ§гҖӮе…¶ж•…йҡңеҹҹзұ»еһӢеҢ…жӢ¬пјҡNodeгҖҒRackгҖҒChassisгҖҒSiteзӯүгҖӮиҝҷйҮҢжҲ‘们еҲӣе»ә4дёӘеҹәдәҺRackзҡ„ж•…йҡңеҹҹпјҢ并жҠҠ4еҸ°иҠӮзӮ№еҲҶеҲ«ж”ҫзҪ®дәҺдёҚеҗҢзҡ„ж•…йҡңеҹҹйҮҢпјҡ

1..4|ForEach-Object {New-ClusterFaultDomain -Name fd0$_ -FaultDomainType rack}

1..4|ForEach-Object {Set-ClusterFaultDomain -Namedths2sofsnode$_ -Parent fd0$_}

е®ҢжҲҗз”ЁGet-ClusterfaultdomainеҸҜзңӢеҲ°зұ»дјјеҰӮдёӢз»“жһңпјҡ

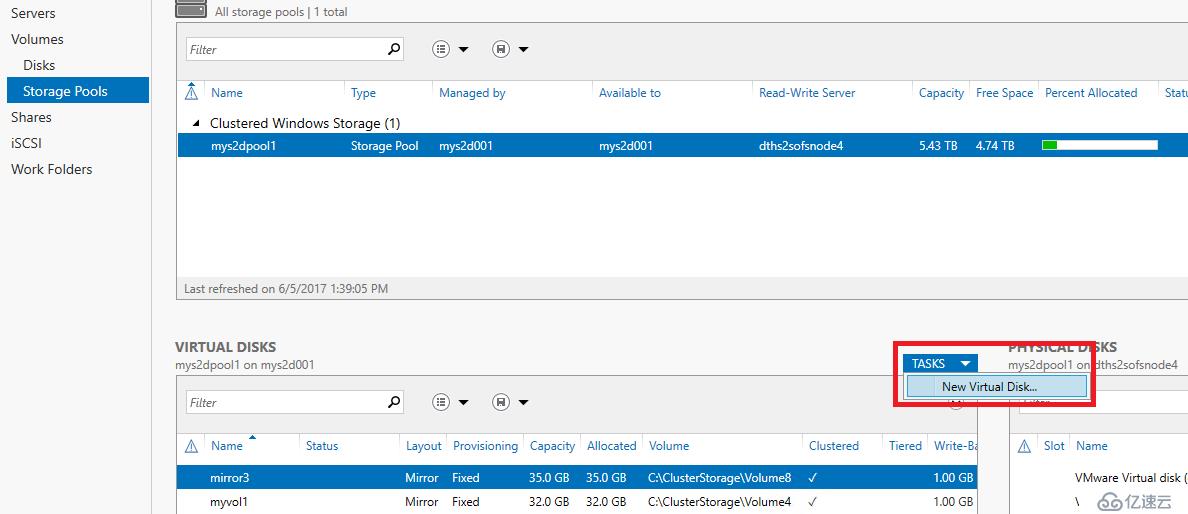

12.еҲӣе»әVirtual DiskпјҲStorage Spaceпјүзҡ„иҝҮзЁӢеҫҲз®ҖеҚ•пјҢеҸҜд»ҘйҖҡиҝҮServerManagerзҡ„еӣҫеҪўз•ҢйқўпјҢд№ҹеҸҜд»ҘйҖҡиҝҮPowershellе‘Ҫд»ӨгҖӮйңҖиҰҒжіЁж„Ҹзҡ„жҳҜйҖҡиҝҮеӣҫеҪўз•ҢйқўеҒҡж—¶еҸҜд»ҘиҮӘе®ҡд№үзҡ„йҖүйЎ№еҫҲе°‘пјҢи·ҹзқҖеҗ‘еҜјз®ҖеҚ•еҮ жӯҘе°ұеҸҜд»Ҙе®ҢжҲҗпјӣйҖҡиҝҮPowershellеҲӣе»әиғҪз»ҷе®ўжҲ·жӣҙеӨҡзҡ„зҒөжҙ»жҖ§гҖӮжҜ”еҰӮдёӢйқўжҲ‘们用 New-Virtualdiskе‘Ҫд»ӨеҲӣе»әдёҖдёӘеҗҚдёәвҖңtestshrink1вҖқзҡ„VDпјҢеӨ§е°Ҹ20GBпјҢDural ParityеёғеұҖгҖӮ

New-VirtualDisk -StoragePoolFriendlyName mys2dpool1 -FriendlyName testshrink1 -Size 20GB -ResiliencySettingName parity -PhysicalDiskRedundancy 2

Server ManagerйҮҢйқўеҲӣе»әVDзҡ„йҖүйЎ№еҰӮдёӢеӣҫзӨәпјҡ

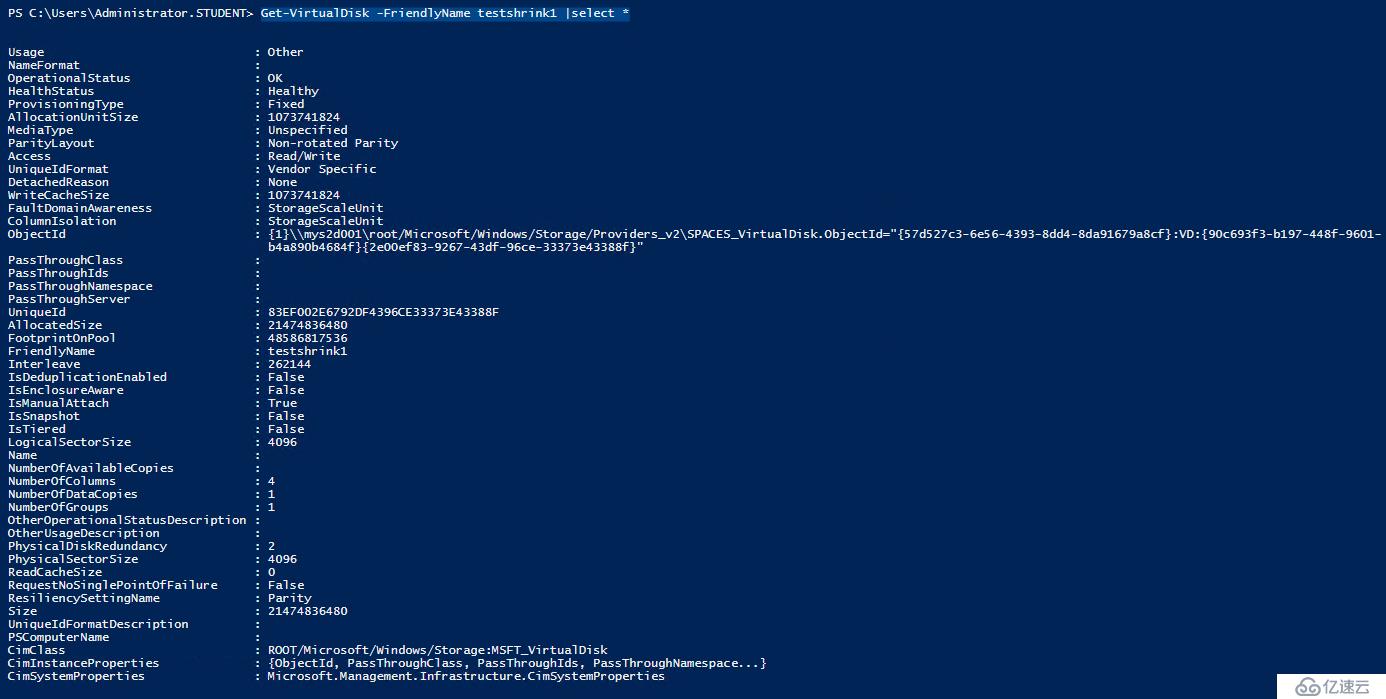

е®ҢжҲҗеҗҺеҸҜеңЁServer ManagerйҮҢжҹҘзңӢе…¶зҠ¶жҖҒпјҢд№ҹеҸҜд»Ҙз”Ёд»ҘдёӢе‘Ҫд»ӨеңЁPowershellйҮҢжҹҘзңӢпјҡ

Get-VirtualDisk -FriendlyName testshrink1 |select *

иҫ“еҮәдҝЎжҒҜеҰӮдёӢпјҢеҸҜд»ҘзңӢеҲ°пјҢзјәзңҒзҠ¶жҖҒдёӢиҜҘеҚ·зҡ„еҶҷзј“еӯҳдёә1GBпјҡ

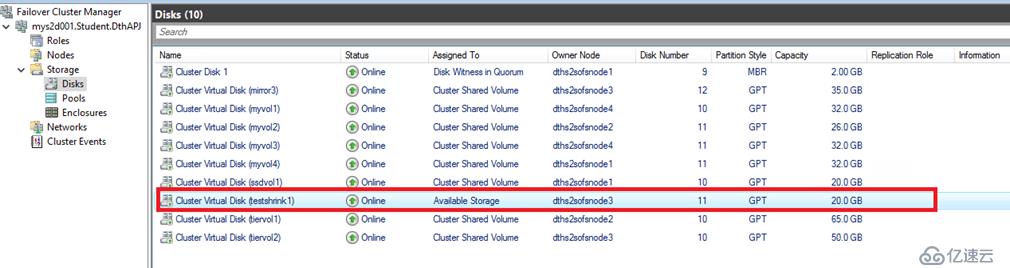

дёӢеӣҫжҳҜеңЁFailover Clusterз®ЎзҗҶз•ҢйқўзңӢеҲ°зҡ„дҝЎжҒҜпјҢжӯӨж—¶еҚіеҸҜеңЁиҜҘVDзҡ„Owner NodeйҮҢпјҢд»ҺзЈҒзӣҳз®ЎзҗҶйҮҢйқўеҲқе§ӢеҢ–пјҢж јејҸеҢ–жҲҗNTFSжҲ–иҖ…ReFSпјҢ然еҗҺеңЁзҫӨйӣҶз®ЎзҗҶеҷЁйҮҢеҸҜе°Ҷе…¶иҪ¬жҚўдёәCSVж јејҸдҪҝз”ЁгҖӮ

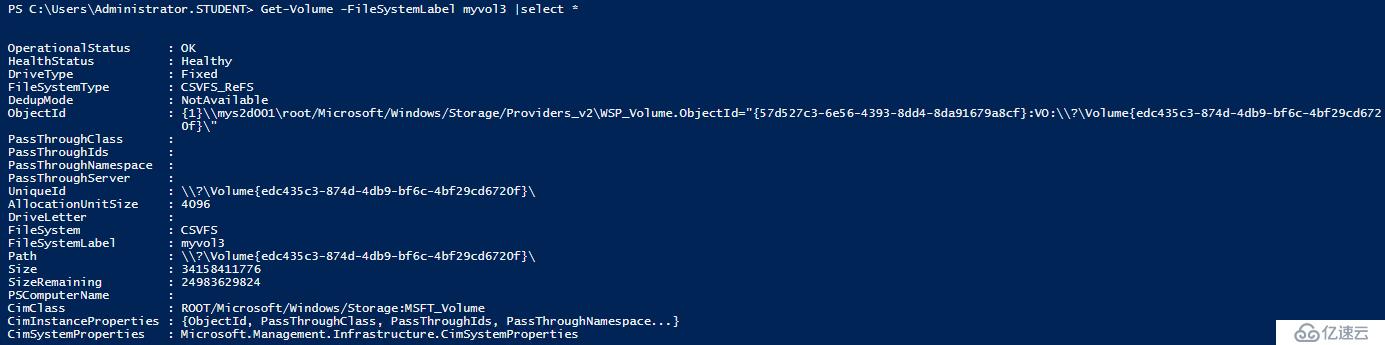

13.жҲ‘们д№ҹеҸҜд»ҘдёҖжӯҘеҲ°дҪҚпјҢзӣҙжҺҘеңЁPowershellйҮҢеҲӣе»әдёҖдёӘReFSеҚ·вҖңmyvol3вҖқпјҢ并еҒҡжҲҗCSVпјҢеёғеұҖдёәдёӨд»ҪжӢ·иҙқзҡ„Mirrorпјҡ

New-Volume -StoragePoolFriendlyName mys2dpool1 -FriendlyName myvol3 -FileSystem CSVFS_ReFS -Size 25GB -ResiliencySettingName mirror -PhysicalDiskRedundancy 1

еҗҢж ·пјҢз”ЁGet-volumeе‘Ҫд»ӨеҸҜжҹҘзңӢе…¶иҜҰз»ҶдҝЎжҒҜпјҡ

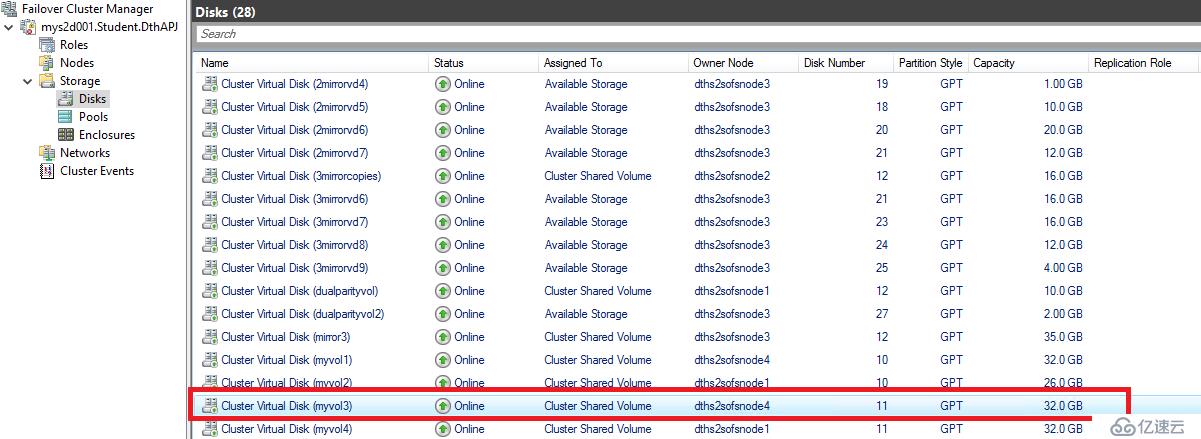

дёӢйқўжҳҜеңЁFaliover ManagerйҮҢзңӢеҲ°зҡ„зҠ¶жҖҒпјҡ

дёӢйқўжҳҜеңЁFaliover ManagerйҮҢзңӢеҲ°зҡ„зҠ¶жҖҒпјҡ

з»Ҷеҝғзҡ„еҗҢеӯҰеҸҜиғҪеҸ‘зҺ°пјҢжҲ‘们еңЁеҲӣе»әж—¶е®ҡд№үзҡ„еӨ§е°ҸжҳҜ25GBпјҢжҖҺд№Ҳз”ҹжҲҗеҗҺзҡ„еӨ§е°ҸеҚҙжҳҜ32GBпјҹ

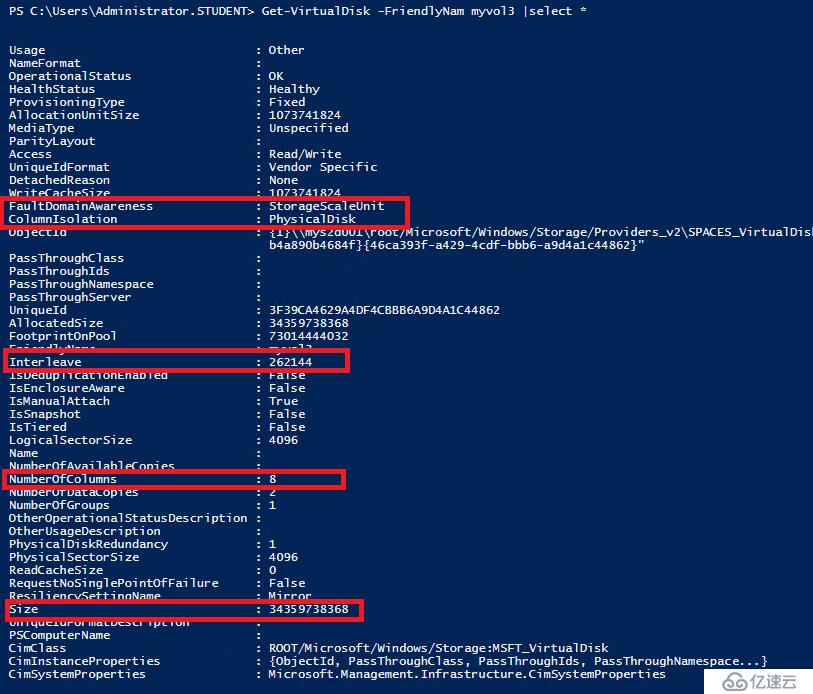

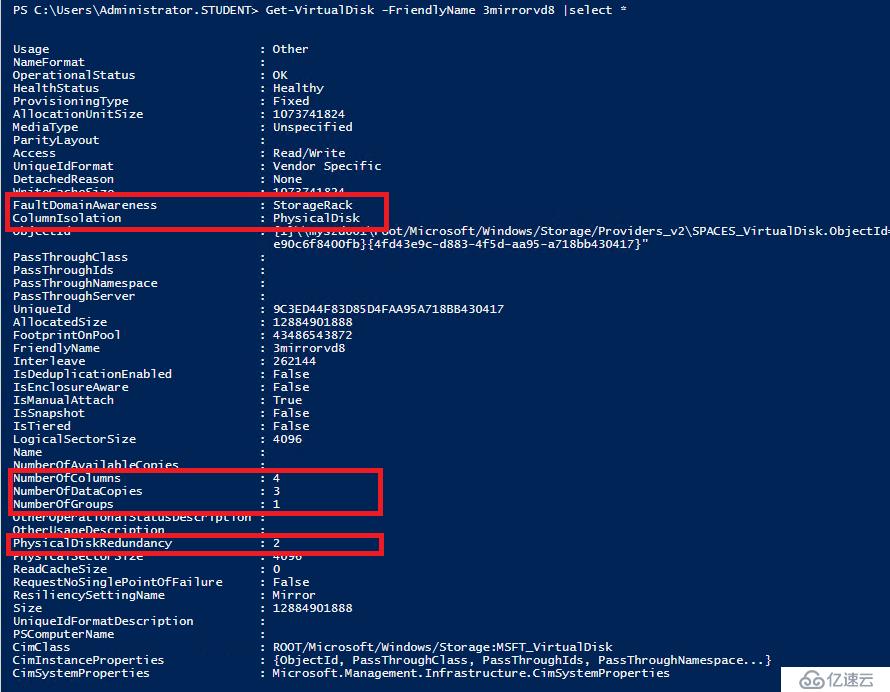

йӮЈд№ҲжҲ‘们еҶҚз”ЁGet-VirtualdiskжҹҘзңӢиҝҷдёӘеҚ·еҜ№еә”VDзҡ„з»ҶиҠӮдҝЎжҒҜпјҡ

жіЁж„ҸдёҠеӣҫзәўжЎҶйҮҢзҡ„еҸӮж•°й…ҚзҪ®гҖӮиҝҷйҮҢе…Ҳд»Ӣз»ҚеҮ дёӘStorage SpaceйҮҢзҡ„йҮҚиҰҒжҰӮеҝөпјҡ

SlabпјҡеӯҳеӮЁжұ йҮҢз»„жҲҗVirtual Diskзҡ„еҹәжң¬еҚ•дҪҚгҖӮеӯҳеӮЁжұ йҮҢзҡ„зЈҒзӣҳйғҪиў«еҲ’жҲҗдёҖеқ—еқ—зҡ„SlabпјҢ然еҗҺд»Ҙз”ЁжҲ·е®ҡд№үзҡ„ж•°жҚ®дҝқжҠӨж–№ејҸпјҲMirrorжҲ–иҖ…Parityпјүз»„жҲҗиҷҡжӢҹзЈҒзӣҳеҲҶй…Қз»ҷдё»жңәдҪҝз”ЁгҖӮS2DйҮҢжҜҸеқ—slabеӨ§е°Ҹдёә256MBгҖӮ

ColumnпјҡеҸҜд»Ҙз®ҖеҚ•ең°зҗҶи§ЈдёәжқЎеёҰе®ҪеәҰпјҢеҚіStorage SpaceеңЁд»ҘжқЎеёҰж–№ејҸеҫҖVDйҮҢеҶҷж•°жҚ®ж—¶пјҢеҢ…еҗ«дәҶеӨҡе°‘еқ—зү©зҗҶзЈҒзӣҳгҖӮзҗҶи®әдёҠиҜҙColumnеӨҡдәҶпјҢеҗҢж—¶е·ҘдҪңзҡ„зЈҒзӣҳж•°йҮҸд№ҹеӨҡдәҶпјҢIOPSд№ҹжңүзӣёеә”еўһеҠ гҖӮе®һйҷ…жғ…еҶөдёӢпјҢеӣ дёәжңүиҜ»еҶҷзј“еӯҳзҡ„еӯҳеңЁпјҢйңҖиҰҒиҝӣдёҖжӯҘжөӢиҜ•columnдёҚеҗҢеёҰжқҘзҡ„жҖ§иғҪе·®еҲ«гҖӮ

InterleaveпјҡеҸҜд»Ҙз®ҖеҚ•зҗҶи§ЈдёәжқЎеёҰж·ұеәҰпјҢеҚіStorage SpaceеңЁд»ҘжқЎеёҰж–№ејҸеҫҖVDйҮҢеҶҷж•°жҚ®ж—¶пјҢжңҖз»ҲиҗҪең°еҲ°жҜҸеқ—зЈҒзӣҳдёҠзҡ„ж•°жҚ®пјҢS2DйҮҢй»ҳи®Өдёә256KBгҖӮ

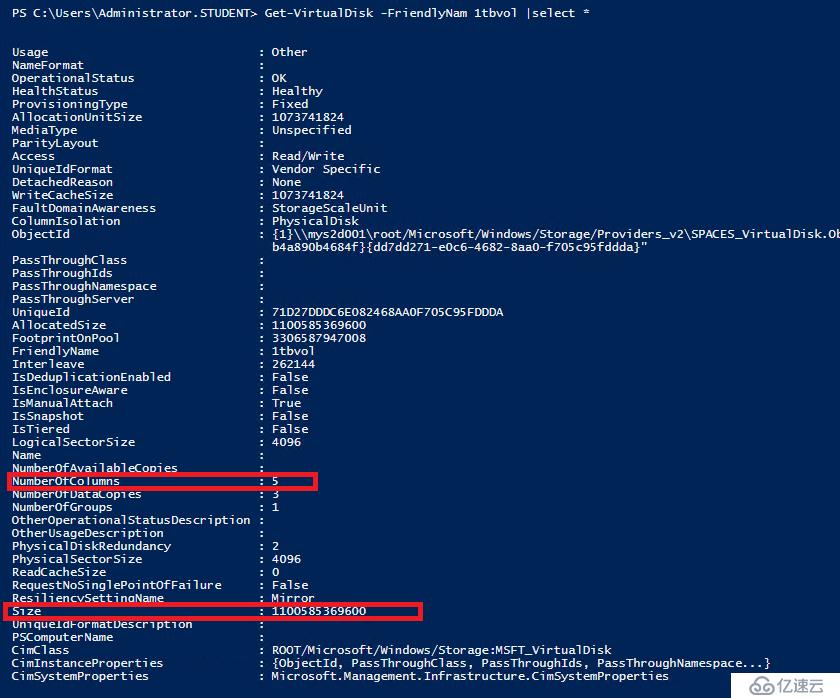

еңЁS2DйҮҢпјҢеҫ®иҪҜе»әи®®еҲӣе»әVDж—¶пјҢColumnе’ҢInterleaveеҖјжңҖеҘҪйғҪдёҚиҰҒжүӢе·Ҙи®ҫзҪ®пјҢзі»з»ҹдјҡиҮӘеҠЁиҝӣиЎҢжңҖдјҳй…ҚзҪ®гҖӮиҖҢSlabеӨ§е°ҸжҳҜдёҚеҸҜи°ғзҡ„гҖӮдҪҶдёҠеӣҫйҮҢзңӢеҲ°зҡ„VD"myvol3"е®һйҷ…е°әеҜёи¶…иҝҮе®ҡд№үе°әеҜёеҫҲеӨҡзҡ„еҺҹеӣ е°ұеңЁдәҺдёҚеҗҢзҡ„Columnзҡ„йҖүжӢ©гҖӮеҰӮдёҠеӣҫзӨәпјҢзі»з»ҹиҮӘеҠЁдёәдёӨи·ҜMirrorеёғеұҖзҡ„вҖңmyvol3вҖқй…ҚзҪ®дәҶ"NumbersofcolumnвҖқдёә8пјҢ笔иҖ…зҢңжөӢжҜҸдёҖд»Ҫж•°жҚ®зҡ„жҜҸдёӘеүҜжң¬еҶҷе…Ҙж—¶йғҪдјҡи·Ё8еқ—зЈҒзӣҳпјҢиҖҢжҜҸеқ—зЈҒзӣҳд»Ҙ256MBзҡ„Slabйў„е…ҲеҲҶй…Қз©әй—ҙпјҢеҠҝеҝ…дјҡйҖ жҲҗеӨҡдҪҷзҡ„з©әй—ҙзҡ„еҲҶй…ҚгҖӮеҲӣе»әVDж—¶е®ҡд№үзҡ„е°әеҜёи¶Ҡе°ҸпјҢиҝҷдёӘзҺ°иұЎи¶ҠжҳҺжҳҫгҖӮ笔иҖ…иҜ•иҝҮеҲӣе»ә1GBзҡ„дёӨи·ҜMirrorзҡ„VDпјҢз”ҹжҲҗеҗҺзҡ„еӨ§е°ҸеҚҙжҳҜ8GBпјӣиҖҢеҰӮжһңеҲӣе»әеҫҲеӨ§зҡ„VDпјҢеҸҚиҖҢжІЎжңүжҳҺжҳҫеӨҡдҪҷз©әй—ҙзҡ„еҲҶй…ҚдәҶгҖӮжүҖд»ҘеңЁзңҹжӯЈз”ҹдә§зҺҜеўғдёӢпјҢеёҰжқҘзҡ„еҪұе“Қеә”иҜҘдёҚеӨ§гҖӮеҰӮдёӢеӣҫдёә1TB VDзҡ„иҜҰз»ҶдҝЎжҒҜпјҡ

еҸҰеӨ–пјҢзі»з»ҹиҮӘеҠЁдёәVDвҖңmyvol3вҖқй…ҚзҪ®дәҶвҖңfaultdomainawarenessвҖқеҖј вҖңStorageScaleUnitвҖқпјҢеҚід»Ҙжү©еұ•еҚ•дҪҚдёәеҹәжң¬зҡ„ж•…йҡңеҹҹгҖӮиҖҢе®һйҷ…з”ҹдә§зҺҜеўғйҮҢпјҢйңҖиҰҒж №жҚ®зҺ°еңәжғ…еҶөе®ҡд№үзңҹжӯЈиғҪжҸҗй«ҳзі»з»ҹе®№й”ҷеәҰзҡ„ж•…йҡңеҹҹгҖӮж•…йҡңеҹҹзұ»еһӢеҪ“еүҚжңүвҖңphysicaldiskвҖқгҖҒвҖңStorageChassisвҖқгҖҒвҖңStorageEnclosureвҖқгҖҒвҖңStorageRackвҖқе’ҢвҖңStorageSacleUnitвҖқдә”з§ҚйҖүжӢ©гҖӮз»“еҗҲд№ӢеүҚжҲ‘们еҲӣе»әзҡ„вҖңStorageRackвҖқж•…йҡңеҹҹпјҢжҲ‘们д№ҹеҸҜд»Ҙз”Ёзұ»дјјеҰӮдёӢе‘Ҫд»ӨеҲӣе»әVDж—¶е®ҡд№үе°ҶжҜҸдёӘж•°жҚ®еүҜжң¬еӣәе®ҡеңЁжҜҸдёӘж•…йҡңеҹҹеҶ…пјҢжӯӨдҫӢдёӯжҲ‘们新е»әдёҖдёӘеҗҚдёәвҖң3mirrorvd8вҖқзҡ„VDпјҢж•…йҡңеҹҹзұ»еһӢдёәеүҚйқўжӯҘйӘӨйҮҢе®ҡд№үзҡ„StorageRackпјҢеҗҢж—¶йҷҗе®ҡNumberofcolumnsеҖјдёә4пјҢдёҚи¶…иҝҮжҜҸдёӘиҠӮзӮ№HDDзҡ„ж•°йҮҸпјҡ

New-VirtualDisk -StoragePoolFriendlyName mys2dpool1 -FriendlyName 3mirrorvd8 -Size 10GB -ResiliencySettingName mirror -NumberOfDataCopies 3 -FaultDomainAwareness StorageRack -NumberOfColumns 4

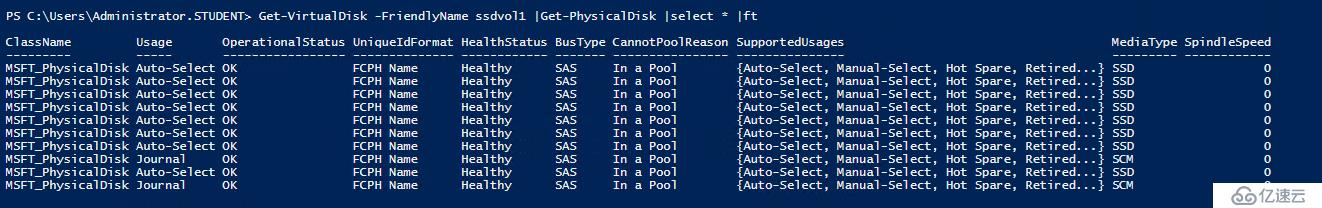

14.йҖҡиҝҮPowershellпјҢд№ҹеҸҜеңЁеҲӣе»әVDж—¶пјҢж №жҚ®дёҡеҠЎжҖ§иғҪйңҖиҰҒпјҢиҪ»жқҫе°Ҷе…¶еӣәе®ҡеңЁдёҚеҗҢзұ»еһӢзҡ„зЈҒзӣҳйҮҢгҖӮжҜ”еҰӮдёӢйқўжҲ‘们еҲӣе»әдёҖдёӘMirrorеҚ·вҖңssdvol1вҖқпјҢе°Ҷе…¶еӣәе®ҡеңЁSSDзЈҒзӣҳйҮҢпјҡ

new-volume -StoragePoolFriendlyName mys2dpool1 -FriendlyName ssdvol1 -FileSystem CSVFS_ReFS -MediaType SSD -Size 15GB -ResiliencySettingName mirror вҖ“PhysicalDiskRedundancy 1

дёӢйқўжҳҜз”Ёget-virtualdiskзңӢеҲ°зҡ„иҜҰз»ҶдҝЎжҒҜ,еҸҜзңӢеҲ°иҜҘеҚ·жүҖеңЁзЈҒзӣҳеқҮдёәSSDзЈҒзӣҳпјҢеҗҢж ·зҡ„ж–№жі•пјҢжҲ‘们д№ҹеҸҜд»Ҙе°ҶжҹҗдәӣеӨ§е®№йҮҸпјҢжҖ§иғҪиҰҒжұӮдҪҺзҡ„VDзӣҙжҺҘеӣәе®ҡеңЁHDDдёҠгҖӮ

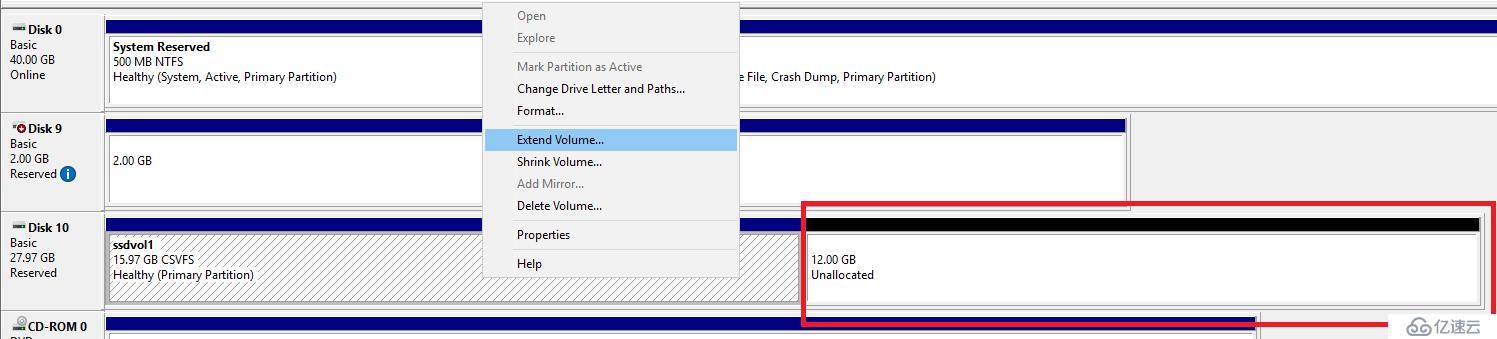

жҲ‘们еҸҜд»ҘеҫҲж–№дҫҝең°еңЁServer ManagerйҮҢжҲ–иҖ…з”ЁдёӢйқўе‘Ҫд»ӨеҜ№ж”№еҚ·иҝӣиЎҢеңЁзәҝжү©е®№пјҡ

Resize-VirtualDisk -FriendlyName ssdvol1 -Size 25GB -Verbose

е®ҢжҲҗеҗҺеңЁssdvol1еҚ·зҡ„жүҖеұһиҠӮзӮ№зҡ„зЈҒзӣҳз®ЎзҗҶеҷЁйҮҢеҚіеҸҜе®һзҺ°иҜҘVDж–Ү件系з»ҹеңЁзәҝжү©е®№пјҡ

е°ҸжҸҗйҶ’пјҡS2DйҮҢVDеҪ“еүҚеҸӘиғҪж”ҜжҢҒеңЁзәҝжү©е®№пјҢдёҚж”ҜжҢҒе°әеҜёзҡ„зј©еҮҸгҖӮеҸҰеӨ–й’ҲеҜ№дәҺеңЁзҫӨйӣҶйҮҢзҡ„S2DеӯҳеӮЁжұ пјҢд№ҹеҸӘиғҪж”ҜжҢҒFixж јејҸзҡ„VDпјҢдёҚж”ҜжҢҒжҢүе®һйҷ…дҪҝз”ЁеҲҶй…Қз©әй—ҙзҡ„иҮӘеҠЁзІҫз®ҖеҚ·гҖӮ

е°ҸжҸҗйҶ’пјҡS2DйҮҢVDеҪ“еүҚеҸӘиғҪж”ҜжҢҒеңЁзәҝжү©е®№пјҢдёҚж”ҜжҢҒе°әеҜёзҡ„зј©еҮҸгҖӮеҸҰеӨ–й’ҲеҜ№дәҺеңЁзҫӨйӣҶйҮҢзҡ„S2DеӯҳеӮЁжұ пјҢд№ҹеҸӘиғҪж”ҜжҢҒFixж јејҸзҡ„VDпјҢдёҚж”ҜжҢҒжҢүе®һйҷ…дҪҝз”ЁеҲҶй…Қз©әй—ҙзҡ„иҮӘеҠЁзІҫз®ҖеҚ·гҖӮ

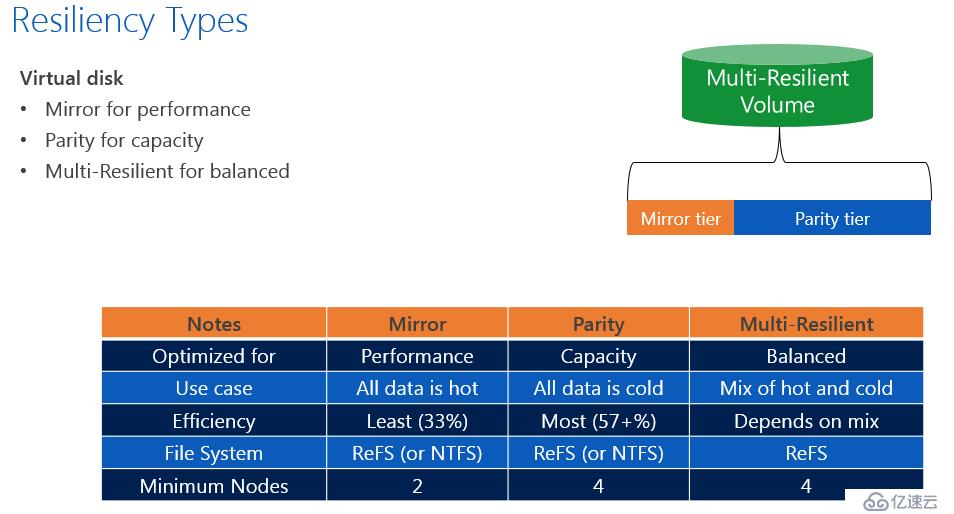

15. еӣ дёәеңЁеӯҳеӮЁжұ йҮҢжңүSSDе’ҢHDDдёӨз§Қзұ»еһӢзҡ„зЈҒзӣҳе……еҪ“е®№йҮҸеұӮпјҢжҺҘдёӢжқҘжҲ‘们е°қиҜ•еҲӣе»әи·ЁеӨҡеұӮеӯҳеӮЁзҡ„еҚ·пјҲMulti Resilient VolumeпјүпјҢиҜҘеҠҹиғҪд»…йҷҗдәҺW2016 S2DпјҢиҖҢдё”д»…йҷҗдәҺReFSж–Ү件系з»ҹгҖӮдҪҝз”Ёиҝҷз§Қзұ»еһӢзҡ„еҚ·зҡ„зӣ®зҡ„жҳҜиҮӘеҠЁе№іиЎЎеҶ·зғӯж•°жҚ®зҡ„еёғеұҖпјҢд»ҺиҖҢдјҳеҢ–е…¶дёҠеә”з”Ёзҡ„жҖ§иғҪпјҢеҗҢж—¶иҠӮзңҒй«ҳеұӮзә§зЈҒзӣҳз©әй—ҙзҡ„еҚ з”ЁгҖӮж•°жҚ®еҶҷе…Ҙж—¶д»ҘMirrorзҡ„ж–№ејҸеҶҷе…ҘеҲ°йў„е…Ҳе®ҡд№үзҡ„MirrorеұӮпјҲSSDпјүпјҢ然еҗҺжҢүйңҖе°ҶвҖңеҶ·еҚҙвҖқдёӢжқҘзҡ„ж•°жҚ®иҮӘеҠЁи°ғеәҰеҲ°ParityеұӮпјҲHDDпјүпјҢд»ҘиҠӮзңҒSSDзҡ„з©әй—ҙеҚ з”ЁпјҢи…ҫеҮәжқҘзҡ„SSDз©әй—ҙз»ҷзңҹжӯЈйңҖиҰҒжҖ§иғҪзҡ„зғӯзӮ№ж•°жҚ®гҖӮдёӢеӣҫжқҘжәҗдәҺеҫ®иҪҜе®ҳж–№ж–ҮжЎЈпјҢеҫҲеҘҪең°жҠҠVDе®№й”ҷеёғеұҖзҡ„зұ»еһӢеҒҡдәҶдёҖдёӘеҪ’зәіпјҡ

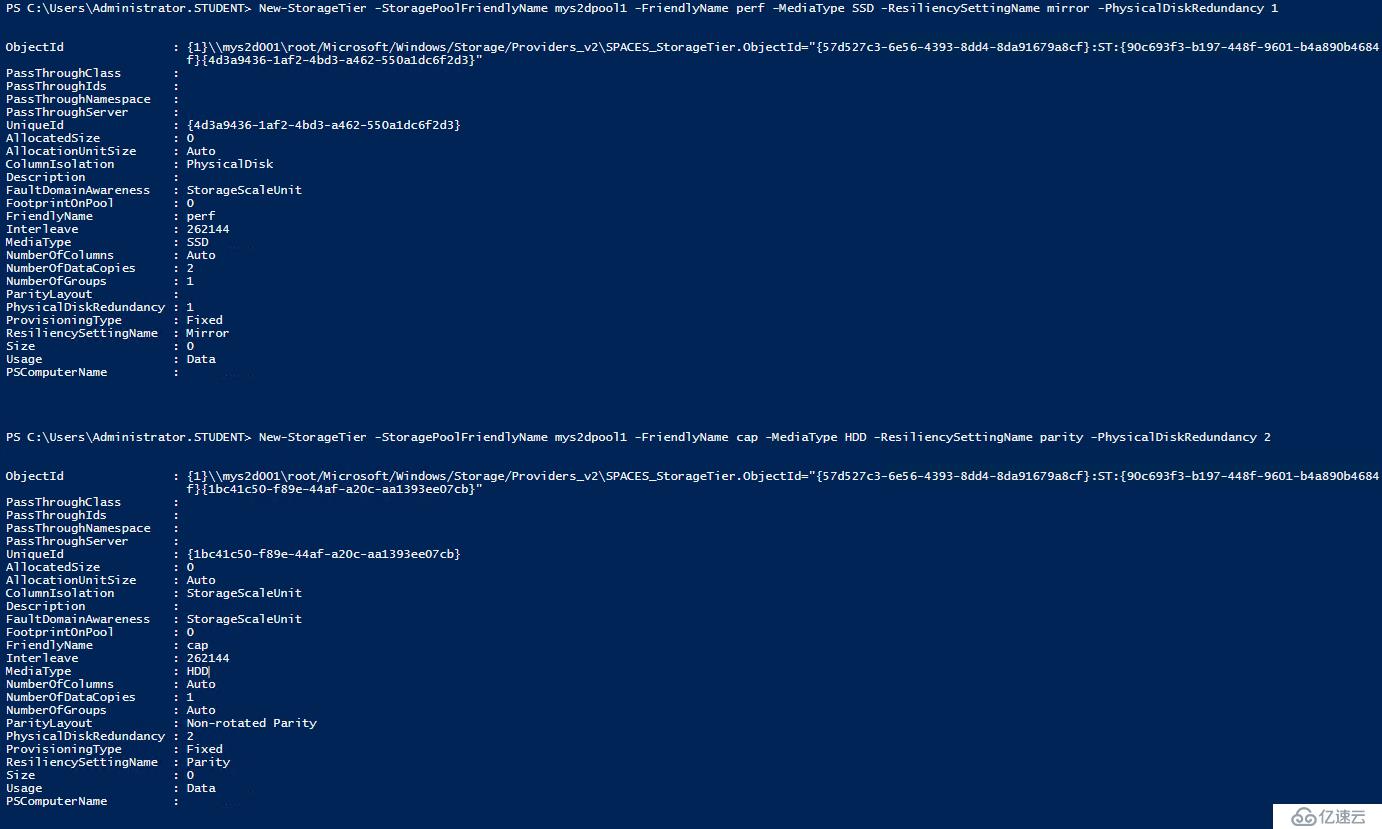

жҺҘдёӢжқҘжҲ‘们еңЁеӯҳеӮЁжұ йҮҢеҲҶеҲ«е®ҡд№үMirrorеұӮе’ҢParityеұӮпјҢMirrorеұӮе‘ҪеҗҚдёәвҖңperfвҖқпјҢж•°жҚ®йҮҮз”Ё2д»ҪжӢ·иҙқзҡ„MirrorеёғеұҖпјҢеҶҷжғ©зҪҡе°ҸпјҢжҖ§иғҪиҫғеҘҪпјӣParityеұӮе‘ҪеҗҚдёәвҖңcapвҖқпјҢйҮҮз”ЁжӣҙиҠӮзңҒз©әй—ҙзҡ„Dual ParityеёғеұҖпјҲзұ»дјјRaid6пјүпјҢеҗҢж—¶жҸҗдҫӣжӣҙеҘҪзҡ„е®үе…ЁжҖ§гҖӮе…·дҪ“е‘Ҫд»ӨеҰӮдёӢпјҡ

New-StorageTier -StoragePoolFriendlyName mys2dpool1 -FriendlyName perf -MediaType SSD -ResiliencySettingName mirror -PhysicalDiskRedundancy 1

New-StorageTier -StoragePoolFriendlyName mys2dpool1 -FriendlyName cap -MediaType HDD -ResiliencySettingName parity -PhysicalDiskRedundancy 2

иҫ“еҮәз»“жһңеҰӮдёӢеӣҫзӨәпјҡ

дёӢйқўжҲ‘们用д»ҘдёӢе‘Ҫд»ӨеҲӣе»әдёҖдёӘеҗҚдёә"mrvol1вҖқзҡ„еҚ·пјҢиҜҘеҚ·еӨ§е°Ҹ60GBпјҢMirrorйғЁеҲҶдёә10GBпјҢParityйғЁеҲҶдёә50GBпјҡ

new-volume -StoragePoolFriendlyName mys2dpool1 -FriendlyName mrvol1 -FileSystem CSVFS_ReFS -StorageTierFriendlyNames perf,cap -StorageTierSizes 10GB,50GB -verbose

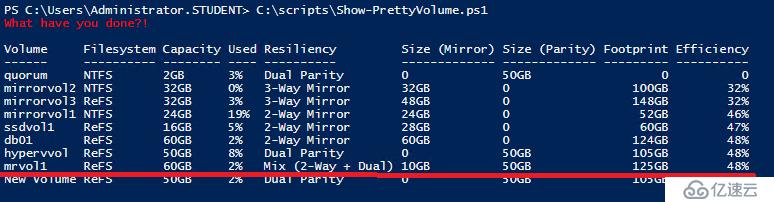

з”Ёеҫ®иҪҜзҡ„и„ҡжң¬е·Ҙе…·вҖңshow-prettyvolumeвҖқеҸҜзңӢеҲ°иҜҘеҚ·зҡ„еҰӮдёӢдҝЎжҒҜпјҡ

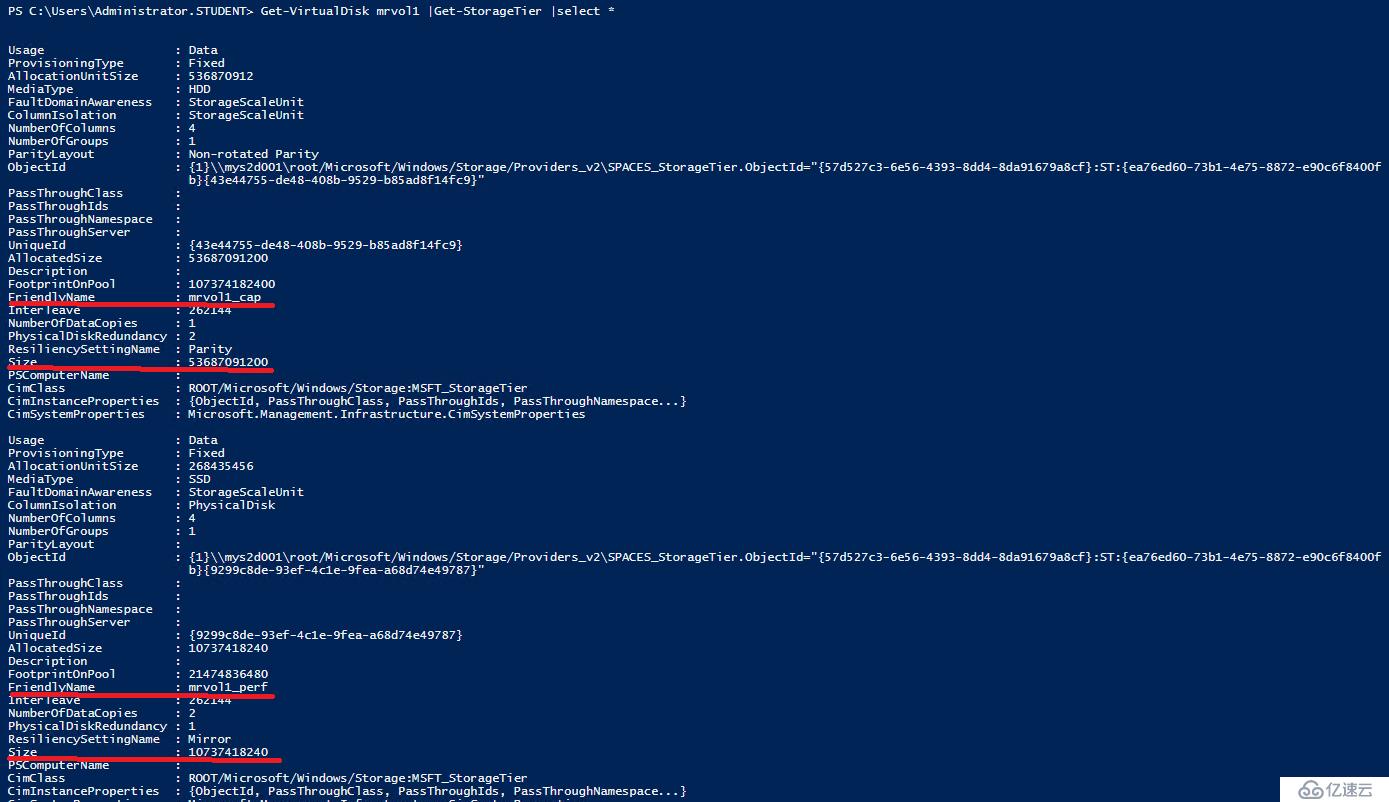

иҝҳеҸҜз”Ёзұ»дјјдёӢйқўе‘Ҫд»ӨжҹҘзңӢиҜҘеҚ·еңЁдёӨеұӮзЈҒзӣҳйҮҢзҡ„иҜҰз»Ҷй…ҚзҪ®дҝЎжҒҜпјҡ

Get-VirtualDisk mrvol1 |Get-StorageTier |select *

иҮідәҺMRVзұ»еһӢзҡ„еҚ·еңЁеҲӣе»әж—¶MirrorеұӮе’ҢParityеұӮеҜ№еә”зҡ„е®№йҮҸжҜ”дҫӢеӨ§жҰӮеӨҡе°‘еҗҲйҖӮпјҢ并没жңүдёҖдёӘзЎ¬жҖ§и§„е®ҡгҖӮдёҖиҲ¬SSDдёҠдјҡеӯҳж”ҫжңҖж–°еҶҷе…Ҙзҡ„зғӯж•°жҚ®пјҢжүҖд»ҘеҸҜж №жҚ®е…¶дёҠжүҖи·‘дёҡеҠЎжҜҸеӨ©дә§з”ҹеӨҡе°‘ж–°ж•°жҚ®дҪңдёәдёҖдёӘеҹәеҮҶпјҢMirrorеұӮзҡ„е®№йҮҸиҮіе°‘дёҚиғҪе°ҸдәҺиҜҘеҖјгҖӮеҸҰеӨ–еҰӮжһңMirrorеұӮз©әй—ҙеҚ з”Ёи¶…иҝҮе®ҡд№үзҡ„60%ж—¶д№ҹдјҡи§ҰеҸ‘ж•°жҚ®жҗ¬еҠЁпјҲеҲ°ParityеұӮпјүпјҢжүҖд»Ҙе»әи®®йҖӮеҪ“ж”ҫе®ҪMirrorеұӮзҡ„е®ҡд№үе®№йҮҸд»ҘйҒҝе…ҚиҝҮдәҺйў‘з№Ғзҡ„ж•°жҚ®жҗ¬еҠЁеёҰжқҘзҡ„йўқеӨ–зі»з»ҹиҙҹжӢ…гҖӮж №жҚ®еҫ®иҪҜз»ҷеҮәзҡ„жңҖдҪіе®һи·өпјҢе»әи®®жңҖеҘҪеңЁMirrorеұӮйў„з•ҷдёӨеҖҚдәҺзғӯзӮ№ж•°жҚ®еӨ§е°Ҹзҡ„е°әеҜёпјҢеҗҢж—¶ж•ҙдёӘеҚ·е®ҡд№үзҡ„еӨ§е°ҸжңҖеҘҪжҜ”жүҖйңҖиҰҒзҡ„е®№йҮҸеӨҡз»ҷ20%е·ҰеҸігҖӮдёҚиҝҮе’Ңд№ӢеүҚеҒҡиҝҮзҡ„е®һйӘҢжӯҘйӘӨзұ»дјјпјҢеҸҜд»ҘйҖҡиҝҮPowershellиҪ»жқҫеңЁзәҝжү©е®№MirrorеұӮжҲ–иҖ…ParityеұӮпјҢжҜ”еҰӮдёӢйқўе‘Ҫд»Өе°ҶдёӨеұӮеҲҶеҲ«жү©е®№10GBпјҢе®ҢжҲҗеҗҺиҝӣе…ҘиҜҘеҚ·жүҖеұһиҠӮзӮ№зҡ„зЈҒзӣҳз®ЎзҗҶе·Ҙе…·пјҢжү©еұ•е…¶ж–Ү件系з»ҹеҚіеҸҜпјҢдёҚеҶҚиөҳиҝ°гҖӮ

Get-VirtualDisk -FriendlyName mrvol1 |Get-StorageTier|? friendlyname -eq mrvol1_perf|Resize-StorageTier -Size 20GB

Get-VirtualDisk -FriendlyName mrvol1 |Get-StorageTier|? friendlyname -eq mrvol1_cap|Resize-StorageTier -Size 60GB

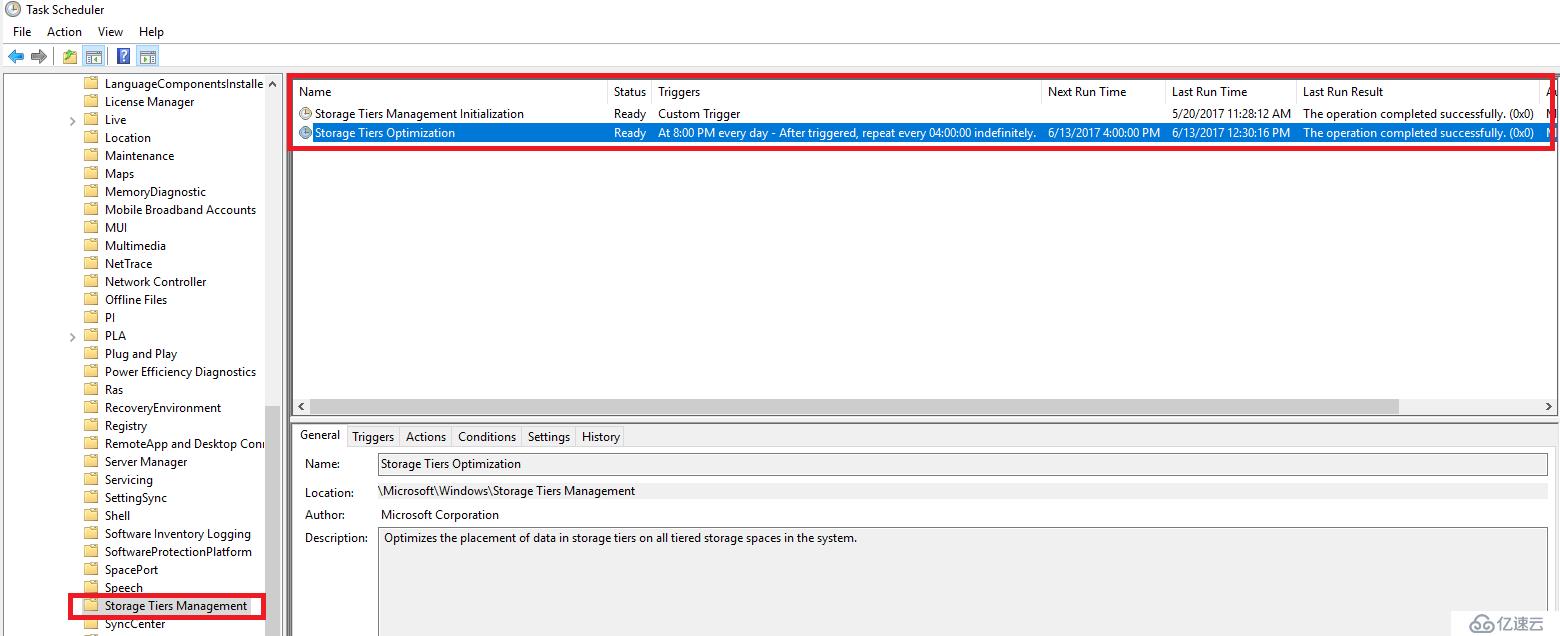

16.жңҖеҗҺпјҢеҸҜд»Ҙз”ЁеҰӮдёӢе‘Ҫд»ӨеҜ№Multi-Resilient еҚ·еҒҡжҢүйңҖдјҳеҢ–гҖӮеҸҰеӨ–пјҢзі»з»ҹд№ҹй»ҳи®Өй…ҚзҪ®дәҶеҜ№еә”зҡ„ж•°жҚ®и°ғеәҰи®ЎеҲ’д»»еҠЎпјҢеҸҜд»ҺTask SchedulerйҮҢжүҫеҲ°пјҢеҰӮдёӢеӣҫзӨәгҖӮз”ЁжҲ·еҸҜж №жҚ®иҮӘиә«дёҡеҠЎйңҖиҰҒи°ғж•ҙејҖе§Ӣзҡ„ж—¶й—ҙгҖӮ

Optimize-Volume -FileSystemLabel mrvol1 -TierOptimize -Verbose

йҖҡиҝҮдёҠиҝ°жӯҘйӘӨеҸҜзңӢеҮәпјҢS2Dзҡ„й…ҚзҪ®е’ҢдҪҝз”ЁзӣёеҜ№дёҚйҡҫпјҢд№ҹйқһеёёзҒөжҙ»пјҢиғҪе°ҪйҮҸж»Ўи¶ідёҚеҗҢдҪҝз”ЁеңәжҷҜзҡ„дёҚеҗҢйңҖжұӮгҖӮдҪҶйңҖиҰҒз®ЎзҗҶе‘ҳзҶҹжӮүPowershellе‘Ҫд»ӨгҖӮеҫ®иҪҜзҡ„дә§е“Ғ专家еңЁзҪ‘дёҠеҲҶдә«еҮәдәҶдёҖдәӣжңүз”Ёзҡ„е…ідәҺS2Dзҡ„и„ҡжң¬пјҢй“ҫжҺҘеҰӮдёӢпјҢдёӢиҪҪеҗҺж №жҚ®иҮӘе·ұзҡ„зҺҜеўғз®ҖеҚ•дҝ®ж”№еҚіеҸҜдҪҝз”ЁгҖӮ

жҹҘзңӢеӯҳеӮЁжұ еҸҠеҚ·зҡ„дҪҝз”ЁзҠ¶жҖҒи„ҡжң¬пјҡ

http://cosmosdarwin.com/Show-PrettyPool.ps1

http://cosmosdarwin.com/Show-PrettyVolume.ps1

еҪ»еә•жё…йҷӨS2Dй…ҚзҪ®зҡ„и„ҡжң¬пјҡ

https://gallery.technet.microsoft.com/scriptcenter/Completely-Clearing-an-ab745947

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ