本篇文章为大家展示了使用c++ 如何实现KMP算法,内容简明扼要并且容易理解,绝对能使你眼前一亮,通过这篇文章的详细介绍希望你能有所收获。

KMP

KMP算法解决的问题

字符串str1和str2,str1是否包含str2,如果包含返回str2在str1中开始的位置。

如何做到时间复杂度O(N)完成?

思路:

首先判断两个字符串是否为空串,并且str2的长度是否小于str1的长度,因为题目要求str1中包含str2。

以上都满足的情况下,首先定义两个变量分别为 x ,y 作为后续字符串中字符遍历的下标,然后再生成一个vector容器next,用来后续的匹配加速

然后在str2中,做加速操作,也就是 看当前 i - 1和之前的所有字符,有没有相同的,最大匹配长度。

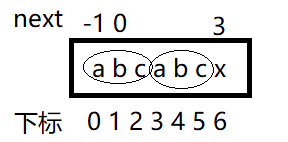

从上图可以看到,下标0和1位置的值永远都是固定的-1和0,。

x 字符是 i 位置,x 前面的 c 是 i - 1 位置,也就是从下标0位置到5位置,找最大的匹配长度,然后填到 i 的next中。这是循环中的case1

如果当next中的值大于0的时候,从b开始,找到next中的2位置,然后跳转到当前位置的next中的坐标上,接着进行匹配。

最后如果到next为0或者-1的位置上,就标记当前位置为0,然后到下一个坐标继续判断。

当 i 遍历完str2后,循环结束,代表next中的值已经全部设置好了。

当str1 和 str2 没有循环遍历到尾部的时候,只要 str1 中 x 的位置 等于 str2 中 y 的位置 ,x 和 y 就同时自增。

如果next中的值等于 -1 ,就说没有匹配成功,x 单独自增。让str1往后挪一位

如果str2中的没有匹配成功,就往前找next数组的值,只要不等于 -1 ,就一直执行这个往前移的过程。

最后看 y 是否已经到了str2的位置,如果到了就说明找到了,直接返回 x的位置 减去 y的位置,就是匹配开始的位置,否则就是没有找到,直接返回 -1

void getNextArray(string str, vector<int>& next)

{

if (str.length() == 1)

{

next.push_back(-1);

}

next.resize(str.length());

next[0] = -1;

next[1] = 0;

int i = 2;

int cn = 0;

while (i < next.size())

{

if (str[i - 1] == str[cn])

{

next[i++] = ++cn;

}

else if (cn > 0)

{

cn = next[cn];

}

else {

next[i++] = 0;

}

}

}

int getIndexOf(string s, string m)

{

if (s == "" || m == "" || s.length() < 1 || s.length() < m.length())

{

return -1;

}

int x = 0;

int y = 0;

vector<int> next;

getNextArray(m,next);

while (x < s.length() && y < m.length())

{

if (s[x] == m[y])

{

x++;

y++;

}

else if (next[y] == -1)

{

x++;

}

else {

y = next[y];

}

}

return y == m.length() ? x - y : -1;

}上述内容就是使用c++ 如何实现KMP算法,你们学到知识或技能了吗?如果还想学到更多技能或者丰富自己的知识储备,欢迎关注亿速云行业资讯频道。

亿速云「云服务器」,即开即用、新一代英特尔至强铂金CPU、三副本存储NVMe SSD云盘,价格低至29元/月。点击查看>>

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。