本篇文章为大家展示了使用python怎么对代理ip进行爬取,内容简明扼要并且容易理解,绝对能使你眼前一亮,通过这篇文章的详细介绍希望你能有所收获。

引入模块

import requests from lxml import etree import time import json

获取所有数据

def get_all_proxy(page):

url = 'https://www.xicidaili.com/nn/%s'%page

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36',

}

response = requests.get(url, headers=headers)

html_ele = etree.HTML(response.text)

ip_eles = html_ele.xpath('//table[@id="ip_list"]/tr/td[2]/text()')

port_ele = html_ele.xpath('//table[@id="ip_list"]/tr/td[3]/text()')

print(ip_eles)

proxy_list = []

for i in range(0,len(ip_eles)):

check_all_proxy(ip_eles[i],port_ele[i])

return proxy_list对数据进行筛选:

def check_all_proxy(host,port):

type = 'http'

proxies = {}

proxy_str = "%s://@%s:%s" % (type, host, port)

valid_proxy_list = []

url = 'http://www.baidu.com/'

proxy_dict = {

'http': proxy_str,

'https': proxy_str

}

try:

start_time = time.time()

response = requests.get(url, proxies=proxy_dict, timeout=5)

if response.status_code == 200:

end_time = time.time()

print('代理可用:' + proxy_str)

print('耗时:' + str(end_time - start_time))

proxies['type'] = type

proxies['host'] = host

proxies['port'] = port

proxiesJson = json.dumps(proxies)

with open('verified_y.json', 'a+') as f:

f.write(proxiesJson + '\n')

print("已写入:%s" % proxy_str)

valid_proxy_list.append(proxy_str)

else:

print('代理超时')

except:

print('代理不可用--------------->'+proxy_str)运行程序:

if __name__ == '__main__': for i in range(1,11): #选取前十页数据使用 proxy_list = get_all_proxy(i) time.sleep(20) print(valid_proxy_list)

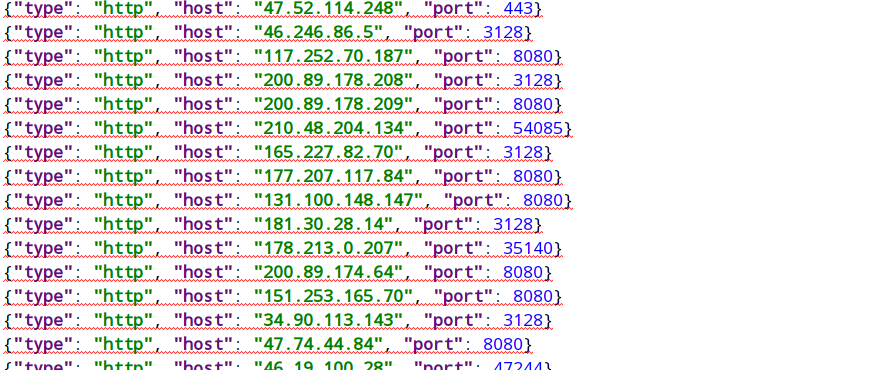

生成的json文件:

上述内容就是使用python怎么对代理ip进行爬取,你们学到知识或技能了吗?如果还想学到更多技能或者丰富自己的知识储备,欢迎关注亿速云行业资讯频道。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。