这篇文章将为大家详细讲解有关Python中如何爬取京东商品数据并实现数据可视化,小编觉得挺实用的,因此分享给大家做个参考,希望大家阅读完这篇文章后可以有所收获。

Python版本:3.6.4

相关模块:

DecryptLogin模块;

argparse模块;

以及一些python自带的模块。

安装Python并添加到环境变量,pip安装需要的相关模块即可。

原理其实挺简单的,首先,我们利用之前开源的DecryptLogin库来实现一下微博的模拟登录操作:

'''模拟登录京东'''

@staticmethod

def login():

lg = login.Login()

infos_return, session = lg.jingdong()

return session然后写几行简单的代码来保存一下登录后的会话,省得每次运行程序都要先模拟登录京东:

if os.path.isfile('session.pkl'):

print('[INFO]: 检测到已有会话文件session.pkl, 将直接导入该文件...')

self.session = pickle.load(open('session.pkl', 'rb'))

self.session.headers.update({'Referer': ''})

else:

self.session = JDGoodsCrawler.login()

f = open('session.pkl', 'wb')

pickle.dump(self.session, f)

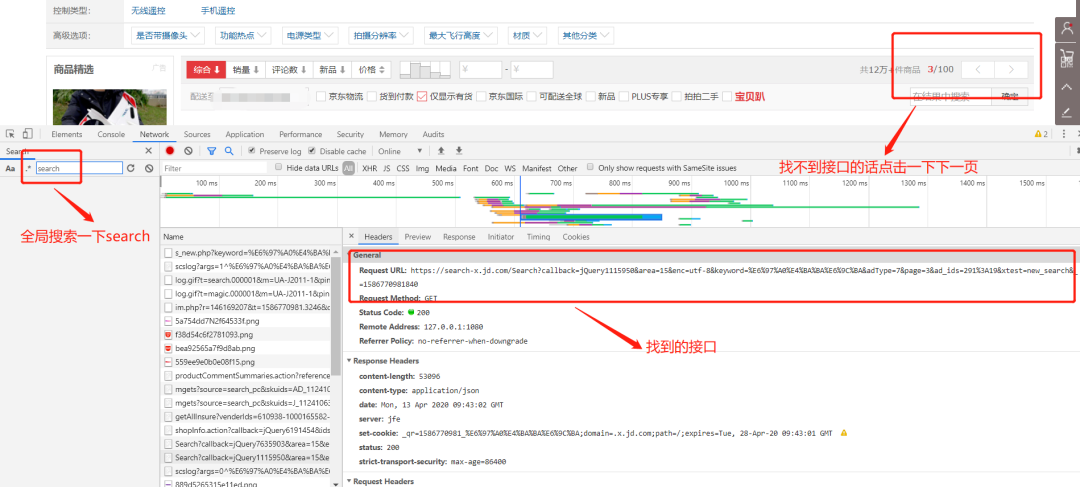

f.close()接着去京东抓一波包,一样的套路,有种屡试不爽的感觉:

看看请求这个接口需要提交的参数:

我们可以简单分析一下每个参数的含义:

area: 不用管,可以看作一个固定值

enc: 指定编码, 可以看作固定值"utf-8"

keyword: 搜索的关键词

adType: 不用管,可以看作一个固定值

page: 当前的页码

ad_ids: 不用管,可以看作一个固定值

xtest: 不用管,可以看作一个固定值

_: 时间戳也就是说我们需要提交的params的内容大概是这样子的:

params = {

'area': '15',

'enc': 'utf-8',

'keyword': goods_name,

'adType': '7',

'page': str(page_count),

'ad_ids': '291:19',

'xtest': 'new_search',

'_': str(int(time.time()*1000))

}构造好需要提交的params之后,只需要利用登录后的session去请求我们抓包得到的接口:

response = self.session.get(search_url, params=params)然后从返回的数据里解析并提取我们需要的数据就可以啦:

response_json = response.json()

all_items = response_json.get('291', [])

for item in all_items:

goods_infos_dict.update({len(goods_infos_dict)+1:

{

'image_url': item.get('image_url', ''),

'price': item.get('pc_price', ''),

'shop_name': item.get('shop_link', {}).get('shop_name', ''),

'num_comments': item.get('comment_num', ''),

'link_url': item.get('link_url', ''),

'color': item.get('color', ''),

'title': item.get('ad_title', ''),

'self_run': item.get('self_run', ''),

'good_rate': item.get('good_rate', '')

}

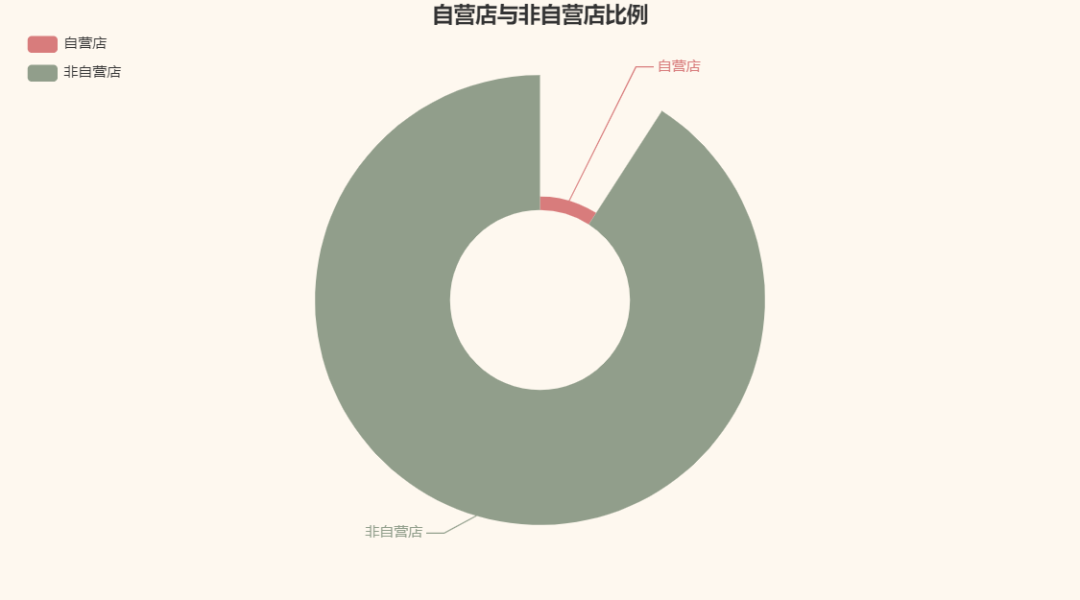

})老规矩,可视化一波我们爬取到的数据呗。以我们爬取到的无人机商品数据为例。首先,我们来看看京东里卖无人机的自营店和非自营店比例吧:

咦,竟然是非自营店占多。我一直以为京东基本都是自营店,虽然我基本不用京东。真是个天大的误解T_T。

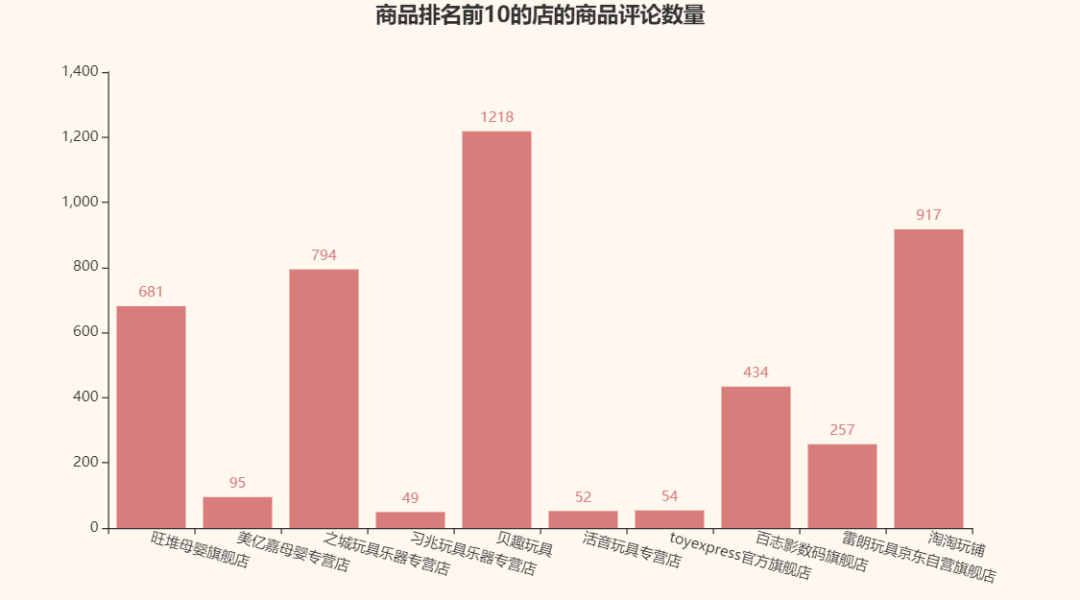

接着,我们再来看看京东自己给的商品排名前10的那几家店的商品评论数量呗:

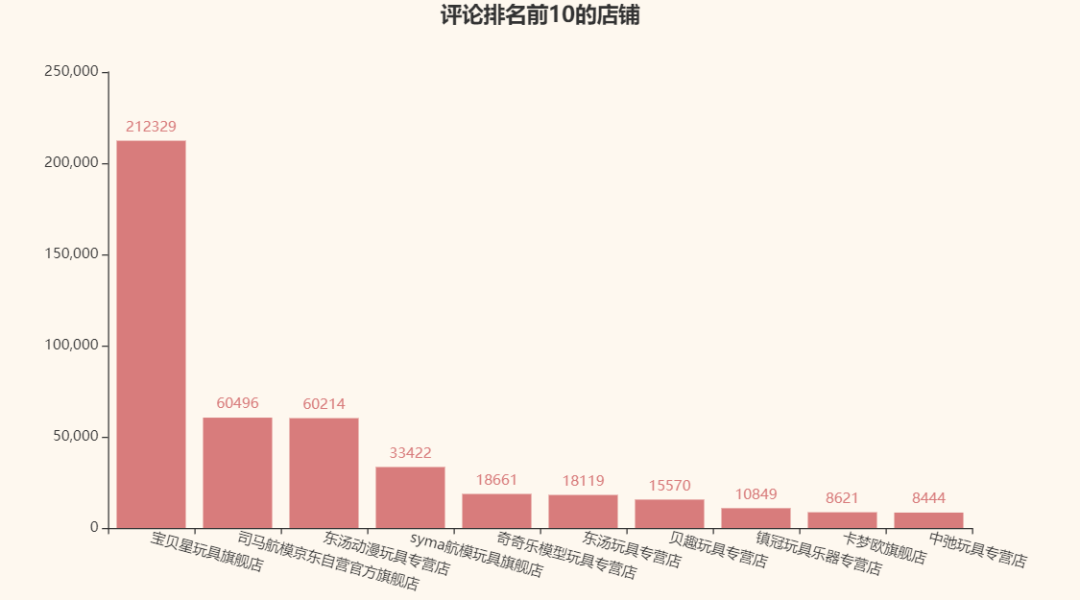

对比一下评论最多的店铺:

看来评论数量和京东给的商品排名并没有直接联系T_T,竟然没有一家店是重复的。

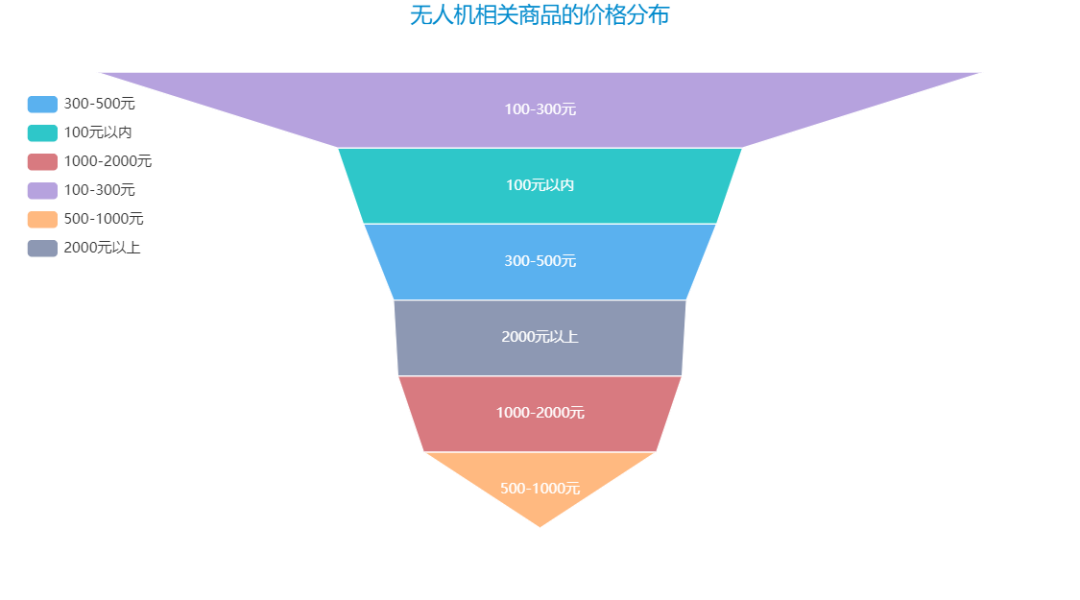

再来看看无人机相关商品的价格分布呗:

关于“Python中如何爬取京东商品数据并实现数据可视化”这篇文章就分享到这里了,希望以上内容可以对大家有一定的帮助,使各位可以学到更多知识,如果觉得文章不错,请把它分享出去让更多的人看到。

亿速云「云服务器」,即开即用、新一代英特尔至强铂金CPU、三副本存储NVMe SSD云盘,价格低至29元/月。点击查看>>

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。