这篇文章主要介绍了怎么利用Scrapy爬虫框架抓取所有文章列表的URL,具有一定借鉴价值,感兴趣的朋友可以参考下,希望大家阅读完这篇文章之后大有收获,下面让小编带着大家一起了解一下。

/具体实现/

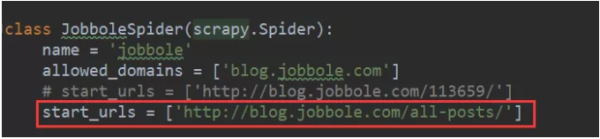

1、首先URL不再是某一篇具体文章的URL了,而是所有文章列表的URL,如下图所示,将链接放到start_urls里边,如下图所示。

2、接下来我们将需要更改parse()函数,在这个函数中我们需要实现两件事情。

其一是获取某一页面所有文章的URL并对其进行解析,获取每一篇文章里的具体网页内容,其二是获取下一个网页的URL并交给Scrapy进行下载,下载完成之后再交给parse()函数。

有了之前的Xpath和CSS选择器基础知识之后,获取网页链接URL就变得相对简单了。

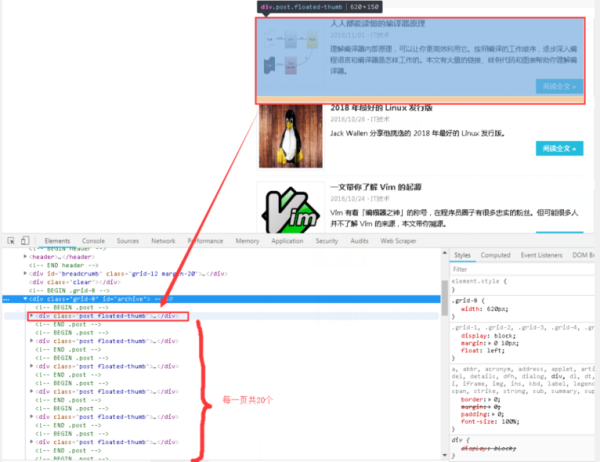

3、分析网页结构,使用网页交互工具,我们可以很快的发现每一个网页有20篇文章,即20个URL,而且文章列表都存在于id="archive"这个标签下面,之后像剥洋葱一样去获取我们想要的URL链接。

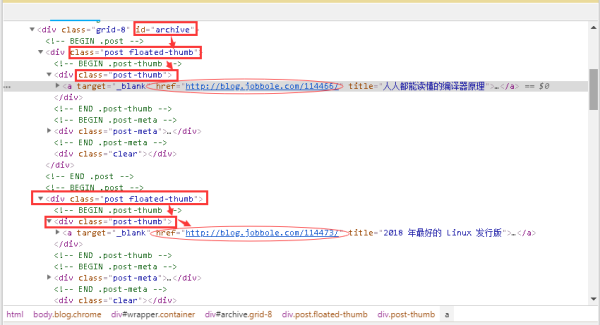

4、点开下拉三角,不难发现文章详情页的链接藏的不深,如下图圈圈中所示。

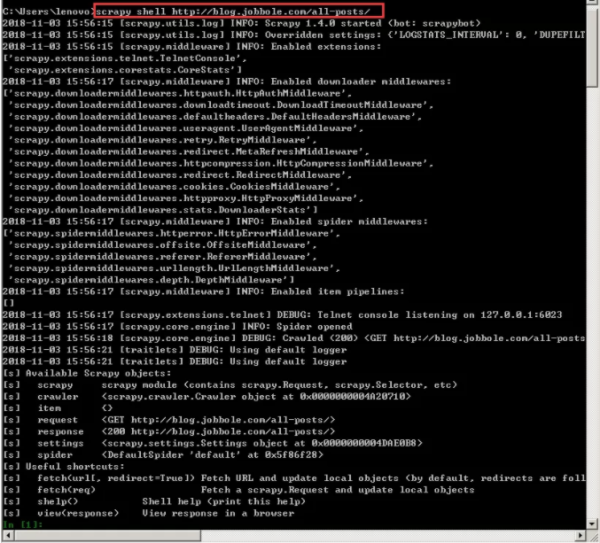

5、根据标签我们按图索骥,加上选择器利器,获取URL犹如探囊取物。在cmd中输入下图命令,以进入shell调试窗口,事半功倍。再次强调,这个URL是所有文章的网址,而不是某一篇文章的URL,不然后面你调试半天都不会有结果的。

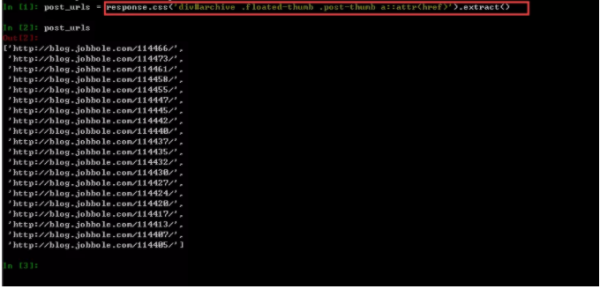

6、根据第四步的网页结构分析,我们在shell中写入CSS表达式,并进行输出,如下图所示。其中a::attr(href)的用法很巧妙,也是个提取标签信息的小技巧,建议小伙伴们在提取网页信息的时候可以经常使用,十分方便。

感谢你能够认真阅读完这篇文章,希望小编分享的“怎么利用Scrapy爬虫框架抓取所有文章列表的URL”这篇文章对大家有帮助,同时也希望大家多多支持亿速云,关注亿速云行业资讯频道,更多相关知识等着你来学习!

亿速云「云服务器」,即开即用、新一代英特尔至强铂金CPU、三副本存储NVMe SSD云盘,价格低至29元/月。点击查看>>

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。

原文链接:https://mp.weixin.qq.com/s/wRlHxe1Ofv3AyECSh6gdiw