直播活动由 TF中文社区 和SDNLAB联合举办。

【pdf文档下载】

https://tungstenfabric.org.cn/assets/uploads/files/kubernetes-sdn-tungsten-fabric.pdf

【高清视频下载链接】

https://pan.baidu.com/s/1cnwFJ3pmoY7HPnLCH37hbw

提取码:guxu

TF就是基于BGP MPLS的VPN

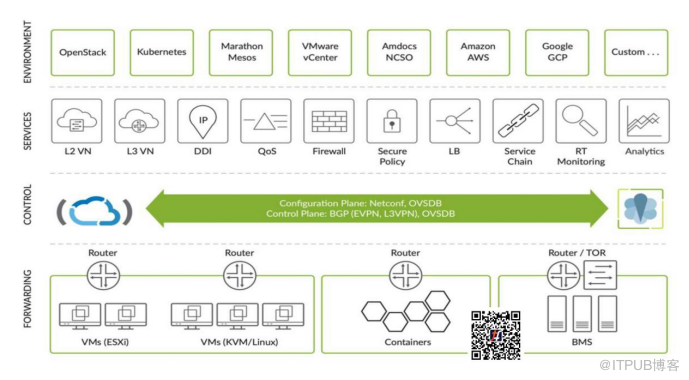

Tungsten Fabric曾用名OpenContrail,2018年3月迁移到Linux基金会。一句话概括TF的核心技术,就是基于BGP MPLS VPN技术。

BGP MPLS VPN技术在运营商的广域网络有了20多年的应用历史,是一个比较成熟的技术。运营商基于BGP MPLS VPN技术,基于同一套网络基础架构和线路的基础上,为不同的网络租户提供了跨广域网的虚拟专线服务。

控制器基于BGP作为SDN的控制平面,实现相应的路由条目、二层转发表的管理,同时支持OVSDB实现对物理设备的配置。物理机可以通过VLAN接入TOR交换机,再转成VXLAN,和相应的容器或虚拟机、虚拟网络互通,这些都是通过BGP和OVSDB实现的。

TF如何加持K8s

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Q: TF是用来替代K8s使用的Calico这种网络的吗?

Q: TF是否是取代K8s内的kube-proxy?

Q: TF使用了BGP,需要让企业内部的接入交换机、核心交换机都开启BGP吗?

出口网关Cloud Gateway,这个是TF Overlay虚拟网络和物理网络的主要连接点,需要支持MP-BGP和GRE隧道或者UDP隧道;如果需要TF管理配置下发,也需要支持NetConf;

BMS TOR交换机,用来实现物理机VLAN网络和TF的虚拟网络实现二层桥接的设备,需要支持EVPN-VXLAN协议;

Underlay网络交换机,就是用于连接各个计算节点,控制节点和BMS TOR以及Cloud Gateway的底层网络。由于TF是在vRouter, BMS TOR, Cloud Gateway实现了隧道的解封包,所以对于Underlay的网络交换机特性没有特殊的要求,只要各节点之间三层可达即可。小规模可以用静态路由,大规模可以用OSPF或者BGP;

TF对于设备是没有锁定的,只要支持相应的协议,都可以使用。但是不同厂商的协议的支持程度会有差异。如果不想做大量的测试和适配工作,Juniper的产品是优先选择,其它品牌的产品就需要在投入生产前做一些测试验证。

Q: K8s Service天然就有LB功能,这个和您讲的ECMP提供的负载均衡有什么关联呢?

(关于TF与K8s的对接,杨雨在直播中进行了Demo演示,展示了Tungsten Fabric基本功能,与Kubernetes的集成对接,以及Service与External IP演示等,感兴趣的朋友,点击下方链接观看)

Q: TF和K8s的资源映射关系是双向同步的吗?

Q: namespace的隔离是逻辑隔离、底层网络还是互通的,VRF是基于网络的还是什么?

Q: TF可以生成环境中的流量展示信息么?可以看到服务之间的访问关系,支持root cause分析么?便于管理员在故障期间分析是哪里出的问题。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。