жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

жң¬ж–Үе®һдҫӢи®Іиҝ°дәҶnodeе®һзҺ°зҡ„зҲ¬иҷ«еҠҹиғҪгҖӮеҲҶдә«з»ҷеӨ§е®¶дҫӣеӨ§е®¶еҸӮиҖғпјҢе…·дҪ“еҰӮдёӢпјҡ

nodeжҳҜжңҚеҠЎеҷЁз«Ҝзҡ„иҜӯиЁҖпјҢжүҖд»ҘеҸҜд»ҘеғҸpythonдёҖж ·еҜ№зҪ‘з«ҷиҝӣиЎҢзҲ¬еҸ–пјҢдёӢйқўе°ұдҪҝз”ЁnodeеҜ№еҚҡе®ўеӣӯиҝӣиЎҢзҲ¬еҸ–пјҢеҫ—еҲ°е…¶дёӯжүҖжңүзҡ„з« иҠӮдҝЎжҒҜгҖӮ

第дёҖжӯҘпјҡ е»әз«Ӣcrawlж–Ү件пјҢ然еҗҺnpm initгҖӮ

第дәҢжӯҘпјҡ е»әз«Ӣcrawl.jsж–Ү件пјҢдёҖдёӘз®ҖеҚ•зҡ„зҲ¬еҸ–ж•ҙдёӘйЎөйқўзҡ„д»Јз ҒеҰӮдёӢжүҖзӨәпјҡ

var http = require("http");

var url = "http://www.cnblogs.com";

http.get(url, function (res) {

var html = "";

res.on("data", function (data) {

html += data;

});

res.on("end", function () {

console.log(html);

});

}).on("error", function () {

console.log("иҺ·еҸ–иҜҫзЁӢз»“жһңй”ҷиҜҜпјҒ");

});

еҚіеј•е…ҘhttpжЁЎеқ—пјҢ然еҗҺеҲ©з”ЁhttpеҜ№иұЎзҡ„getиҜ·жұӮпјҢеҚідёҖж—ҰиҝҗиЎҢпјҢзӣёеҪ“дәҺnodeжңҚеҠЎеҷЁз«ҜеҸ‘йҖҒдәҶдёҖдёӘgetиҜ·жұӮиҜ·жұӮиҝҷдёӘйЎөйқўпјҢ然еҗҺйҖҡиҝҮresиҝ”еӣһпјҢе…¶дёӯonз»‘е®ҡdataдәӢ件用жқҘдёҚж–ӯең°жҺҘеҸ—ж•°жҚ®пјҢжңҖеҗҺendж—¶жҲ‘们е°ұеңЁеҗҺеҸ°жү“еҚ°еҮәжқҘгҖӮ

иҝҷеҸӘжҳҜж•ҙдёӘйЎөйқўзҡ„дёҖйғЁеҲҶпјҢжҲ‘们еҸҜд»ҘеңЁжӯӨйЎөйқўе®ЎжҹҘе…ғзҙ пјҢеҸ‘зҺ°зЎ®е®һжҳҜдёҖж ·зҡ„

жҲ‘们еҸӘйңҖиҰҒе°Ҷе…¶дёӯзҡ„з« иҠӮtitleе’ҢжҜҸдёҖе°ҸиҠӮзҡ„дҝЎжҒҜзҲ¬еҲ°еҚіеҸҜгҖӮ

第дёүжӯҘпјҡ еј•е…ҘcheerioжЁЎеқ—пјҢеҰӮдёӢпјҡпјҲеңЁgitbashдёӯе®үиЈ…еҚіеҸҜпјҢcmdжҖ»жҳҜеҮәй—®йўҳпјү

cnpm install cheerio --save-dev

иҝҷдёӘжЁЎеқ—зҡ„еј•е…ҘпјҢе°ұжҳҜдёәдәҶж–№дҫҝжҲ‘们ж“ҚдҪңdomпјҢе°ұеғҸjQueryдёҖж ·гҖӮ

第еӣӣжӯҘпјҡ ж“ҚдҪңdomпјҢиҺ·еҸ–жңүз”ЁдҝЎжҒҜгҖӮ

var http = require("http");

var cheerio = require("cheerio");

var url = "http://www.cnblogs.com";

function filterData(html) {

var $ = cheerio.load(html);

var items = $(".post_item");

var result = [];

items.each(function (item) {

var tit = $(this).find(".titlelnk").text();

var aut = $(this).find(".lightblue").text();

var one = {

title: tit,

author: aut

};

result.push(one);

});

return result;

}

function printInfos(allInfos) {

allInfos.forEach(function (item) {

console.log("ж–Үз« йўҳзӣ® " + item["title"] + '\n' + "ж–Үз« дҪңиҖ… " + item["author"] + '\n'+ '\n');

});

}

http.get(url, function (res) {

var html = "";

res.on("data", function (data) {

html += data;

});

res.on("end", function (data) {

var allInfos = filterData(html);

printInfos(allInfos);

});

}).on("error", function () {

console.log("зҲ¬еҸ–еҚҡе®ўеӣӯйҰ–йЎөеӨұиҙҘ")

});

еҚідёҠйқўзҡ„иҝҮзЁӢе°ұжҳҜеңЁзҲ¬еҸ–еҚҡе®ўзҡ„йўҳзӣ®е’ҢдҪңиҖ…гҖӮ

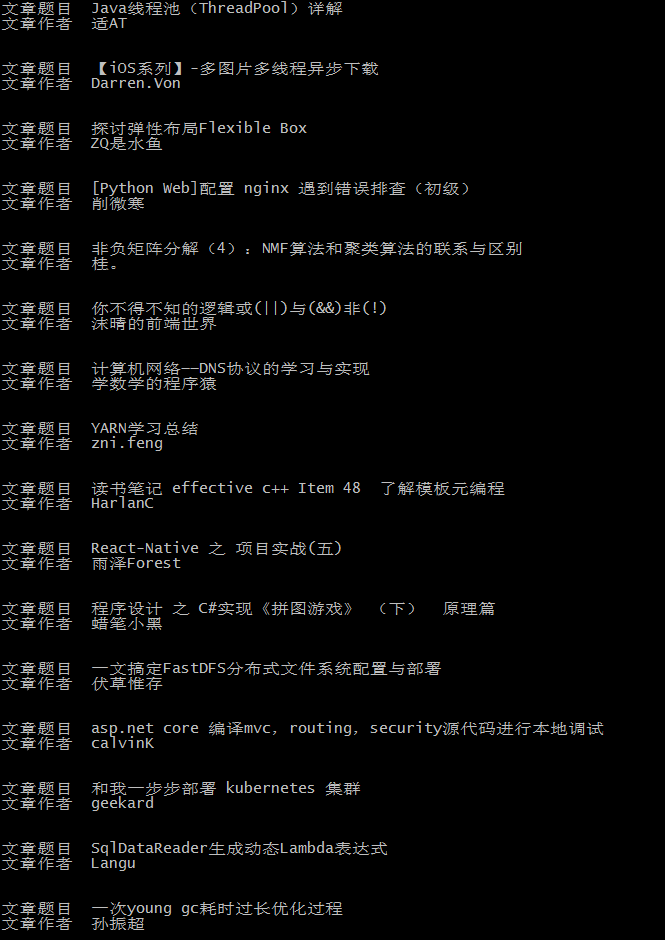

жңҖз»ҲеҗҺеҸ°иҫ“еҮәеҰӮдёӢпјҡ

иҝҷе’ҢеҚҡе®ўеӣӯйҰ–йЎөзҡ„еҶ…е®№жҳҜдёҖиҮҙзҡ„пјҡ

еёҢжңӣжң¬ж–ҮжүҖиҝ°еҜ№еӨ§е®¶nodejsзЁӢеәҸи®ҫи®ЎжңүжүҖеё®еҠ©гҖӮ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ