这篇文章将为大家详细讲解有关Python中Pytorch怎么使用,小编觉得挺实用的,因此分享给大家做个参考,希望大家阅读完这篇文章后可以有所收获。

Tensor(张量是一个统称,其中包括很多类型):

0阶张量:标量、常数、0-D Tensor;1阶张量:向量、1-D Tensor;2阶张量:矩阵、2-D Tensor;……

import torch

t = torch.Tensor([1, 2, 3])

print(t)

两者之间可以相互转化

import torch

import numpy as np

t1 = np.array(torch.Tensor([[1, 2, 3],

[1, 2, 3]]))

t2 = torch.Tensor(np.array([[1, 2, 3],

[1, 2, 3]]))运行结果:

torch.empty(x,y)

创建x行y列为空的tensor。

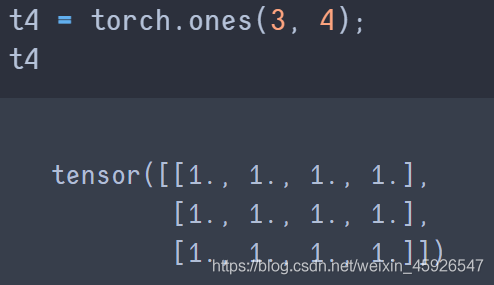

torch.ones([x, y])

创建x行y列全为1的tensor。

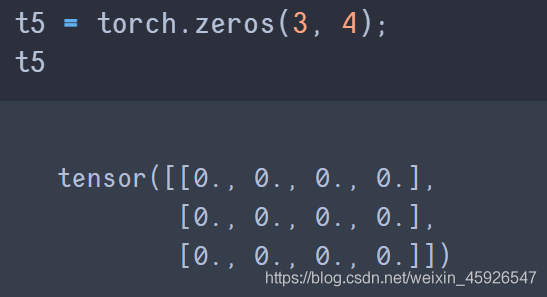

torch.zeros([x,y])

创建x行y列全为0的temsor。

zeros与empty的区别

后者的数据类型是不固定的。

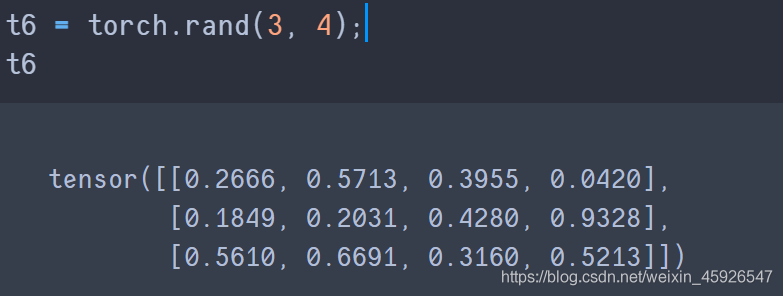

torch.rand(x, y)

创建3行4列的随机数,随机数是0-1。

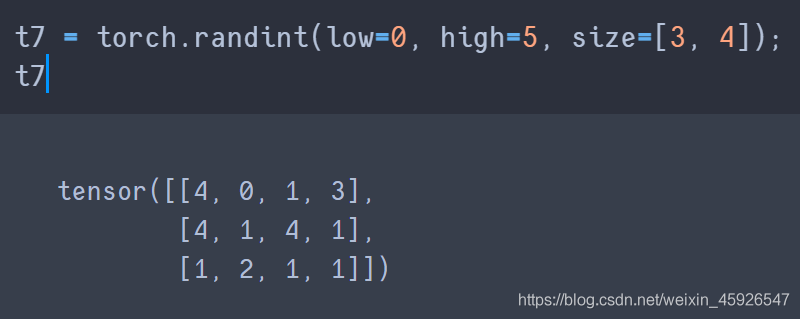

torch.randint(low, high, size)

创建一个size的tensor,随机数为low到high之间。

torch.randn([x, y])

创建一个x行y列的tensor,随机数的分布式均值为0,方差1。

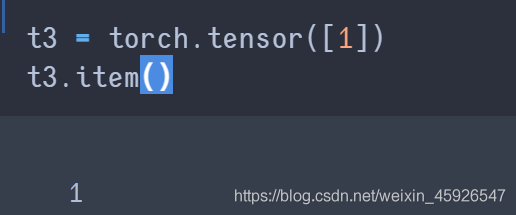

item():

获取tensor中的元素,注意只有

一个元素的时候才可以用。

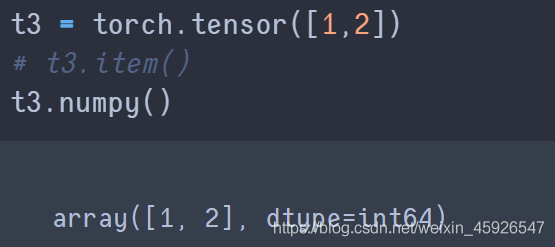

numpy():

转化成

ndarray类型。

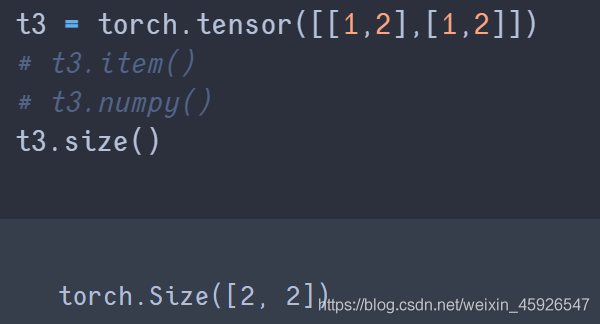

size()

获取tensor的

形状。

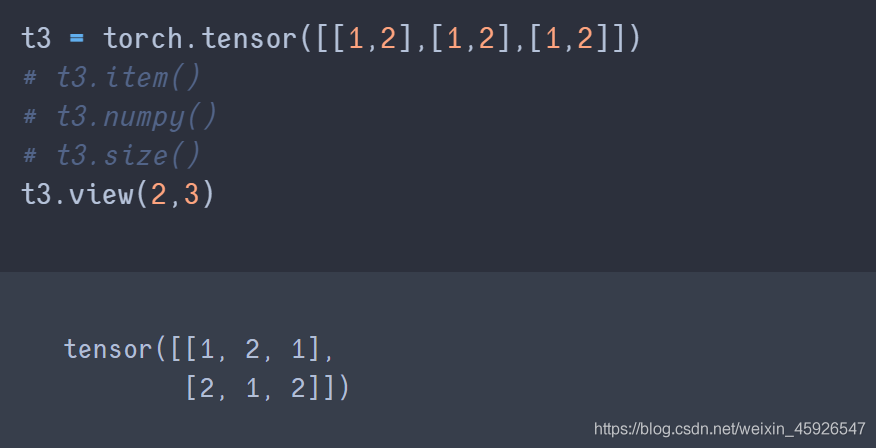

view()

可以传参,表示获取第几个。若参数为-1,表示不确定,与另一个参数的乘积等于原始形状的乘积。 例如:原始形状为8,则

浅拷贝,tensor的形状改变。view(-1,2)⇒view(4, 2); 参数只有-1,表示一维。

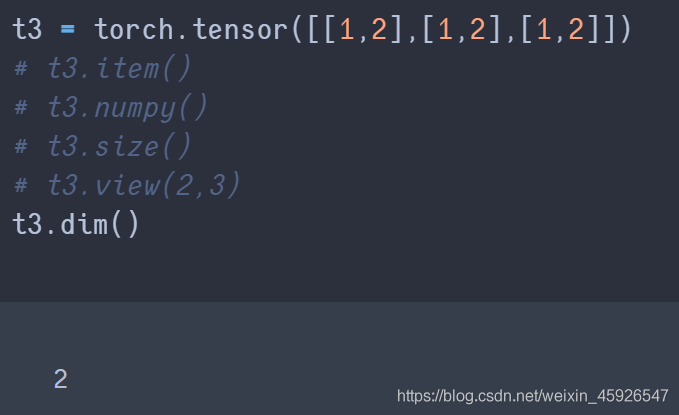

dim()

获取维度。

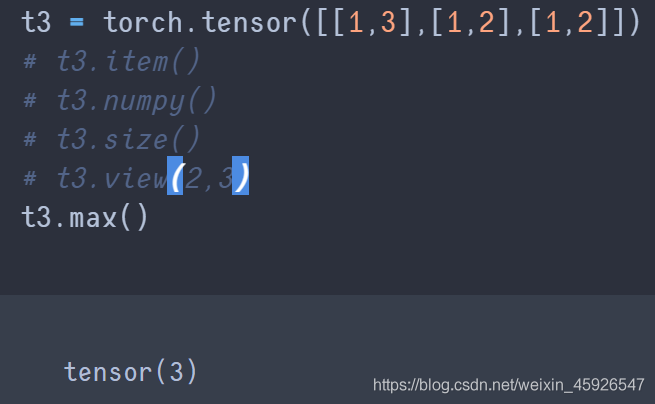

max()

获取最大值。

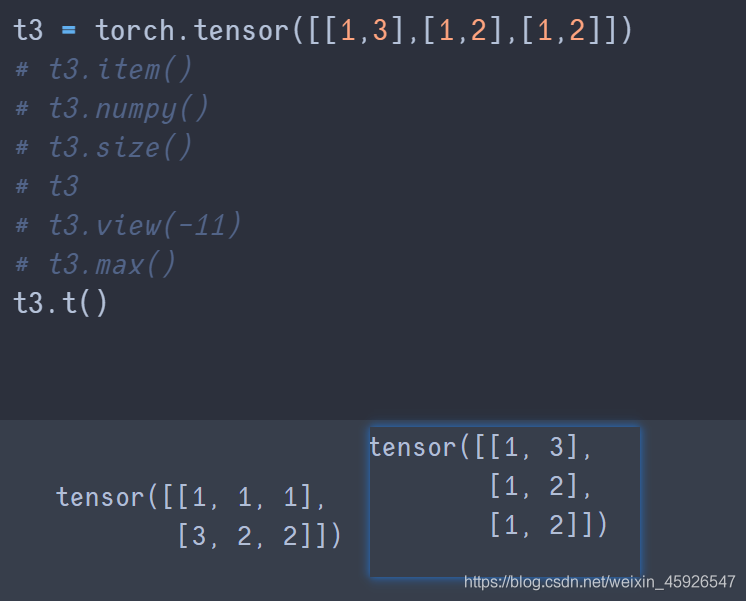

t()

转置。

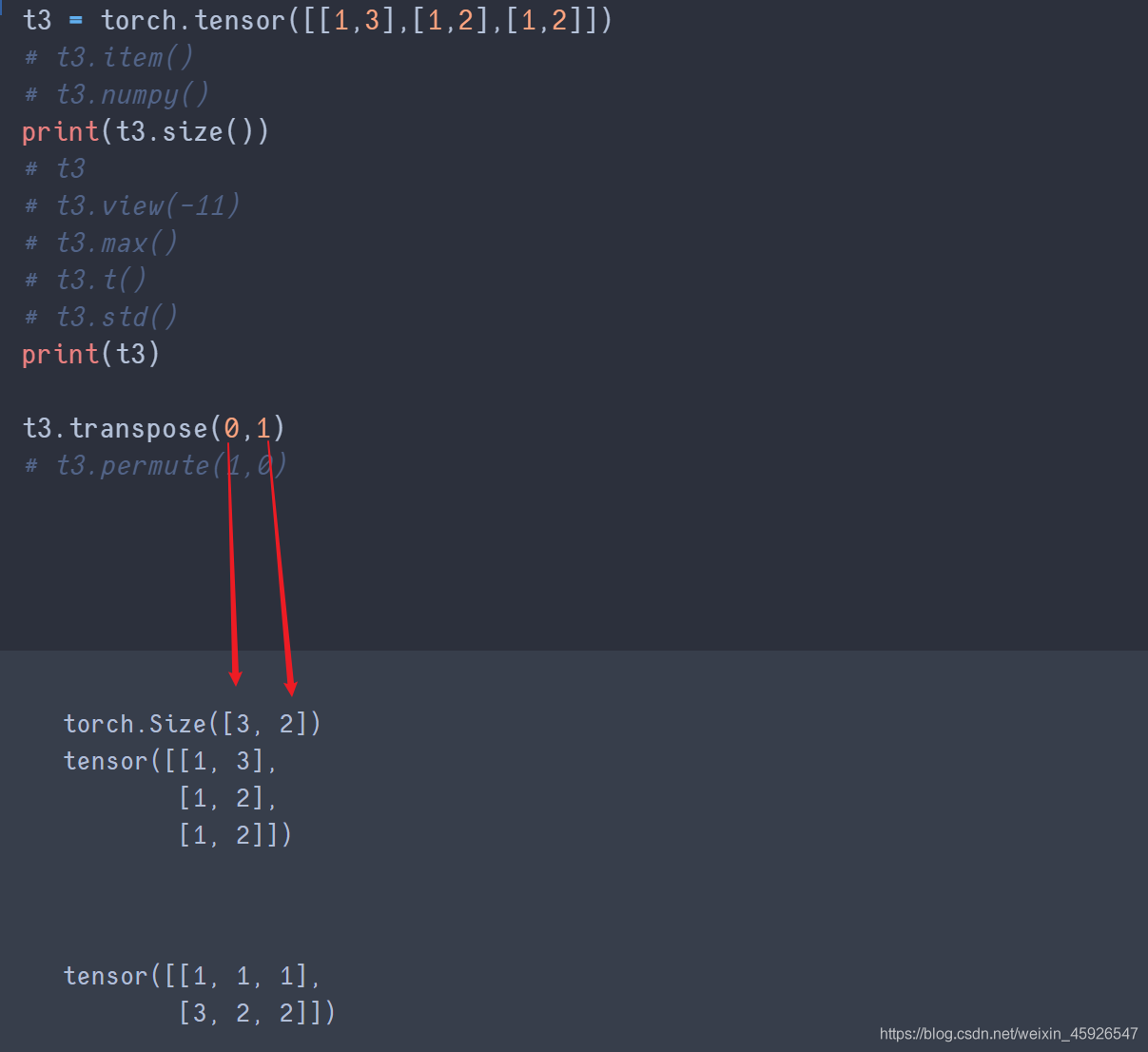

transpose(x,y)

x,y是size里面返回的形状相换。

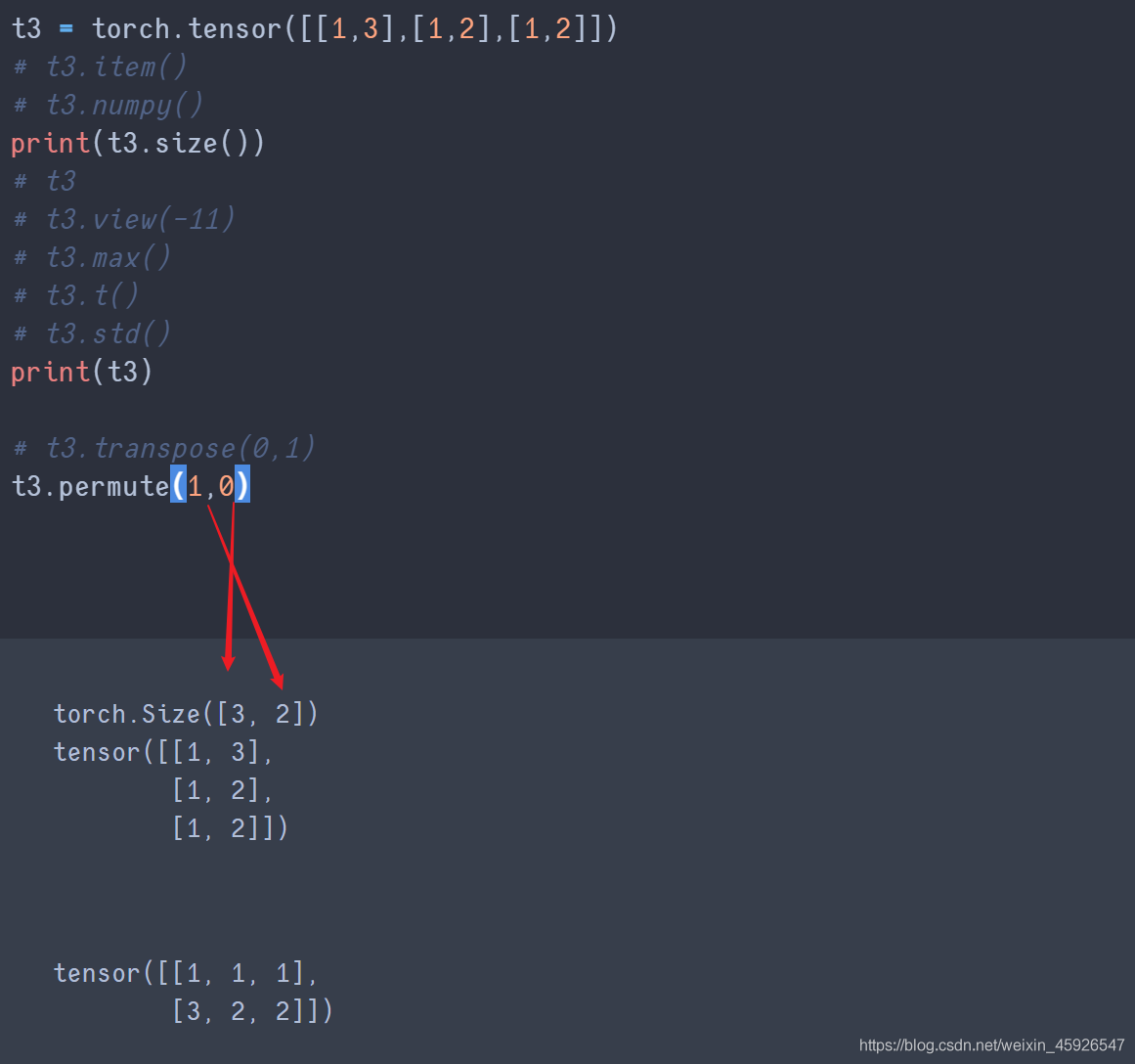

permute()

传入size()返回的形状的顺序。

transpose与permute的区别

前者传入列即可相互交换;后者传入列会根据传入的顺序来进行转化,且需要传入所有列数的索引。

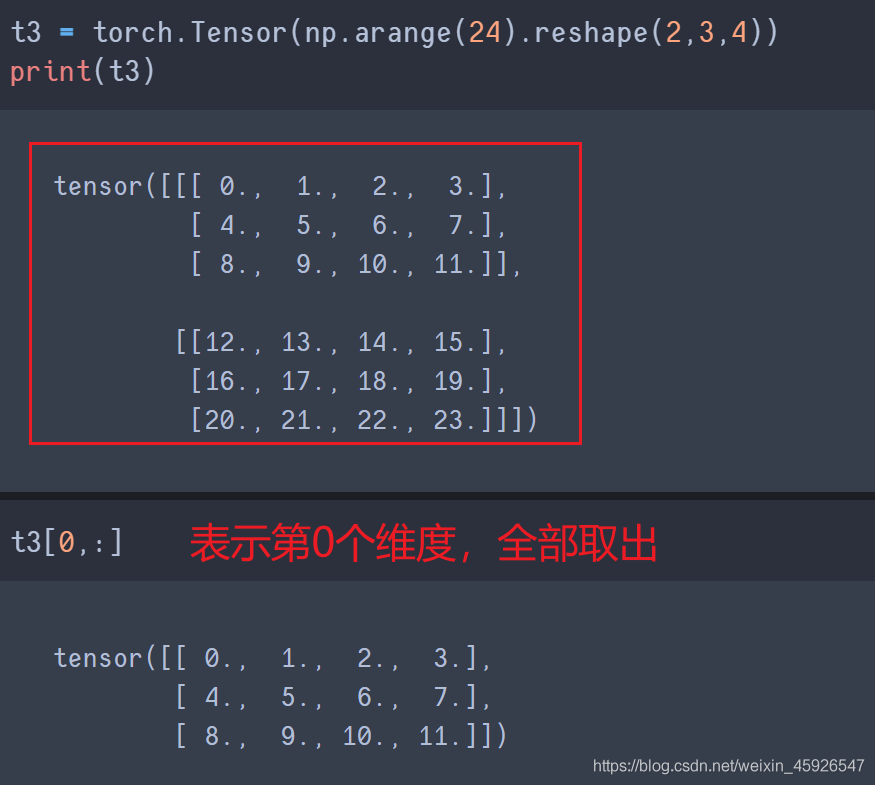

取值[第一阶, 第二阶,……]

一个逗号隔开代表一个阶乘冒号代表全取

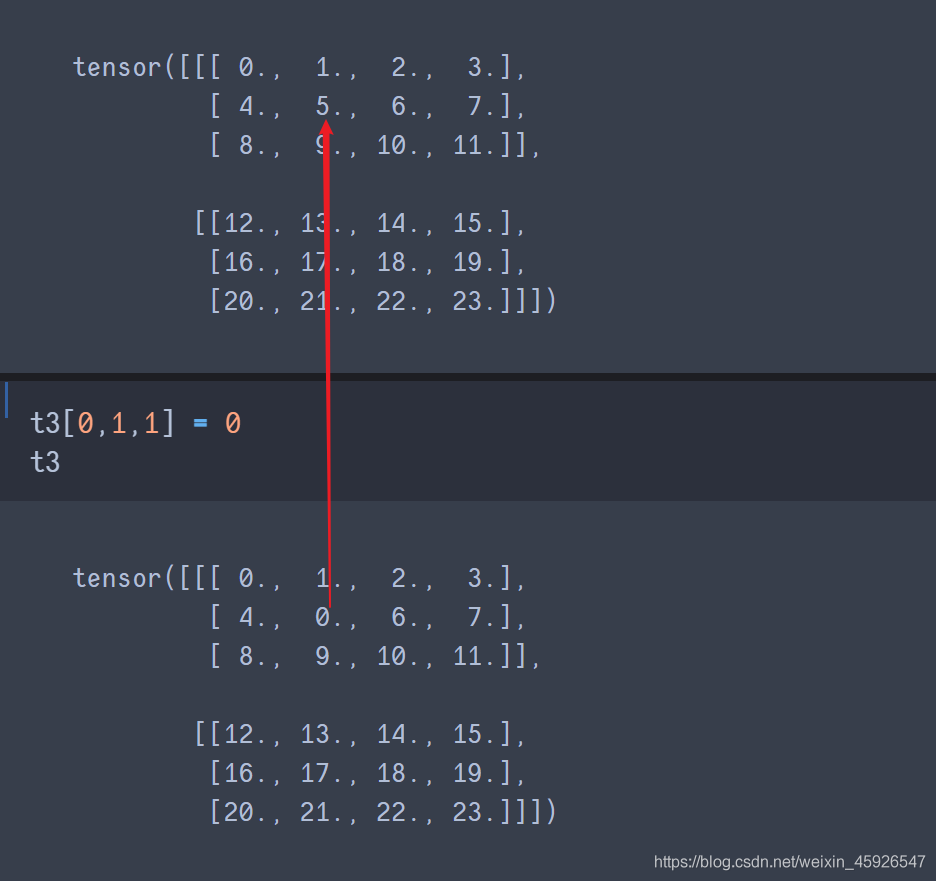

赋值[第一阶, 第二阶,……]

直接赋值即可

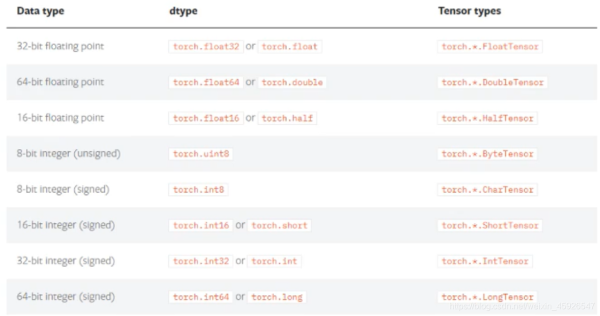

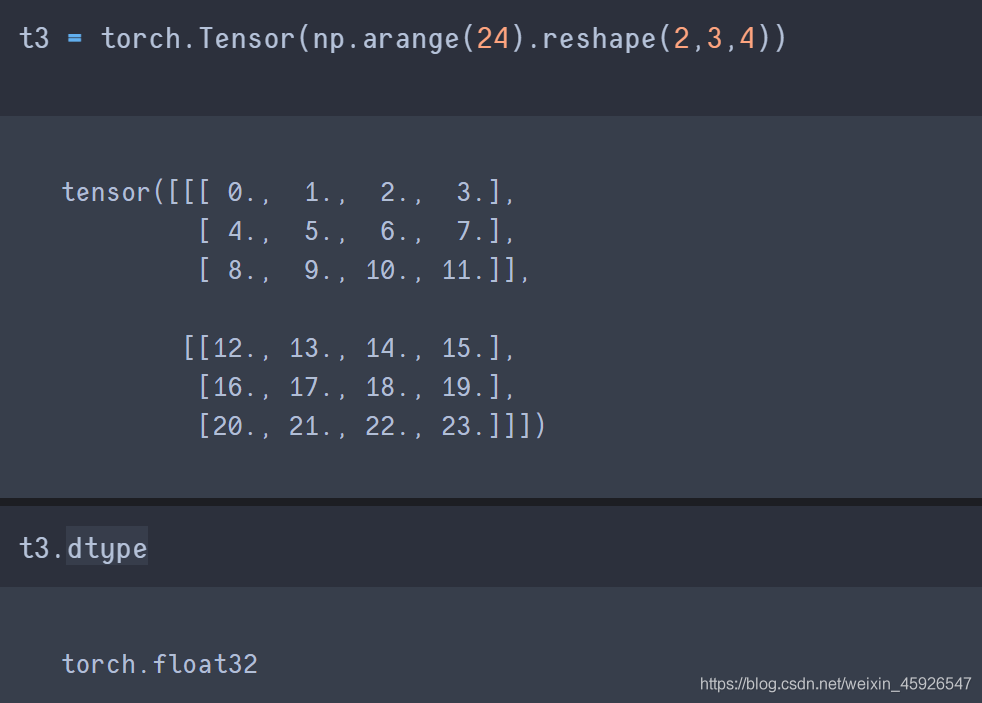

tensor.dtype

获取数据类型

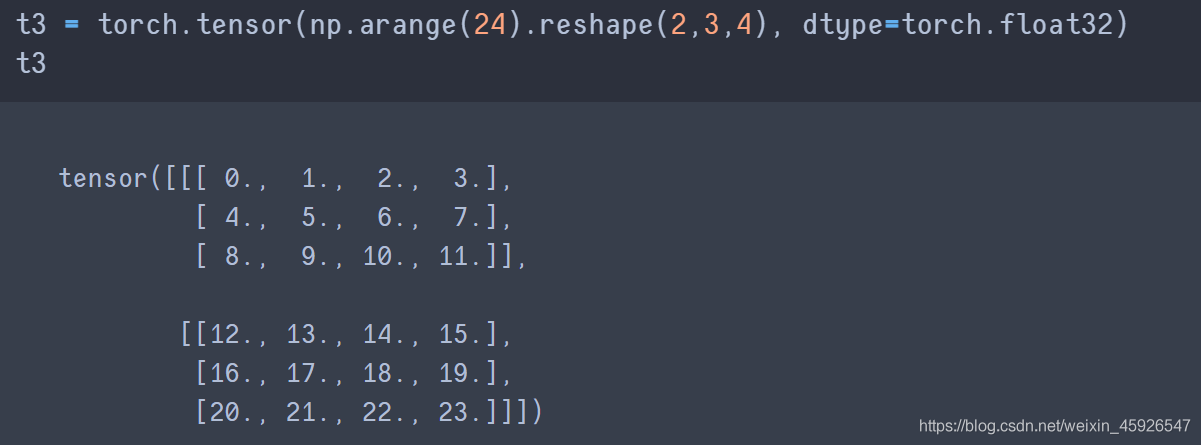

设置数据类型

注意使用

Tensor()不能指定数据类型。

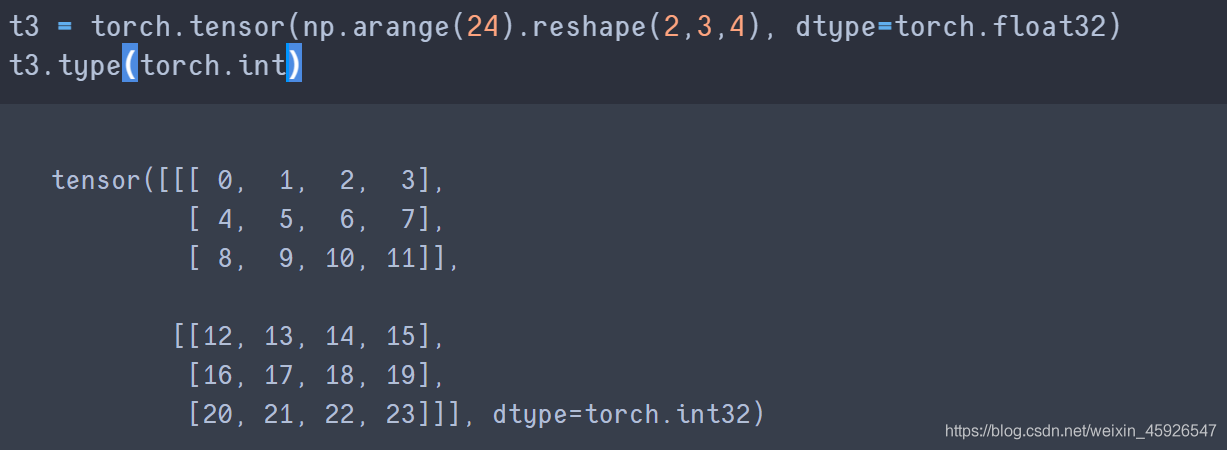

type()

修改数据类型。

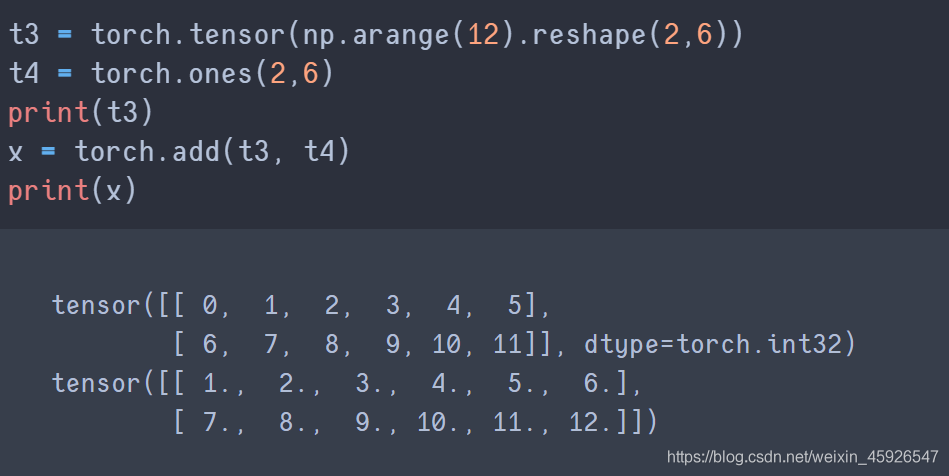

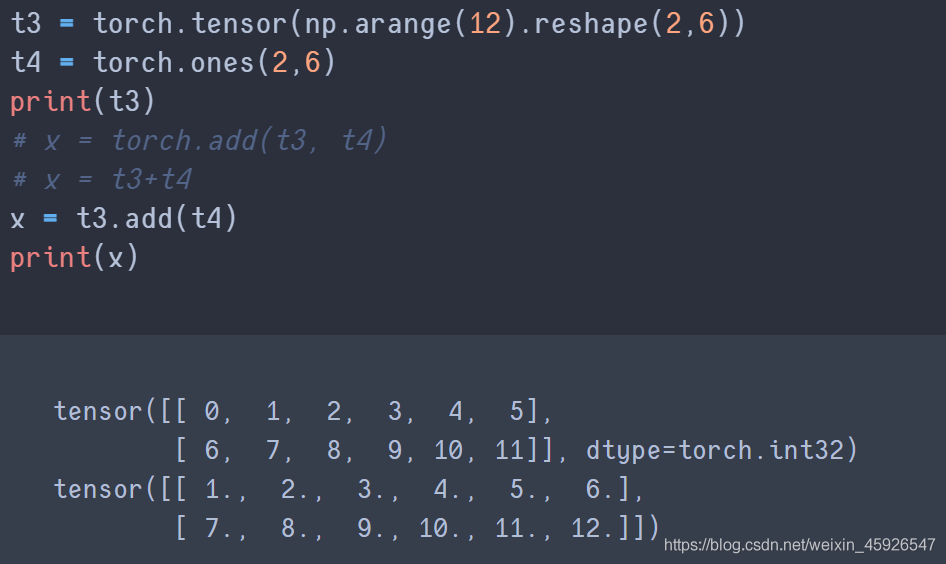

torch.add(x, y)

将x和y

相加。

直接相加

tensor.add()

使用add_() 可相加后直接保存在tensor中

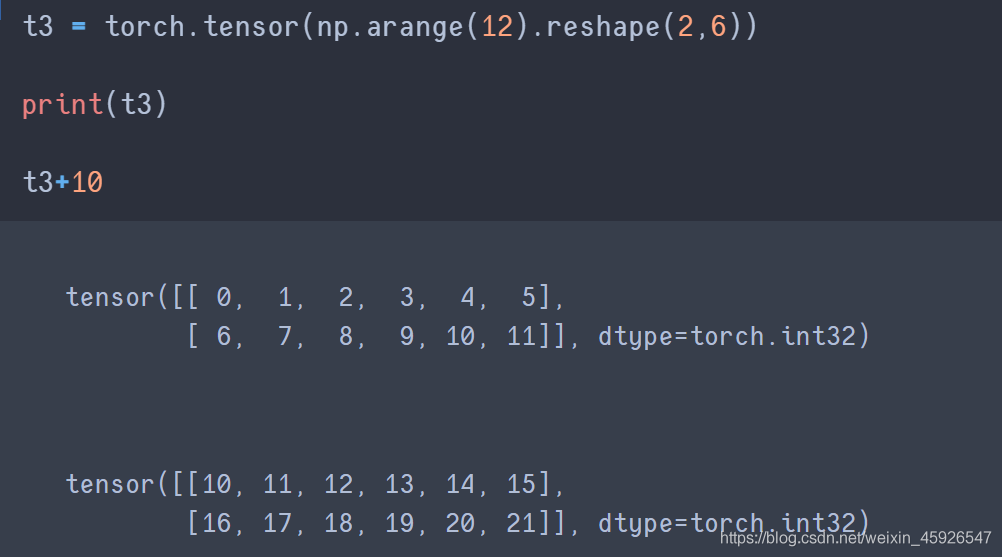

tensor + 数值

CUDA (Compute Unified Device Architecture),是NVIDIA推出的运算平台。CUDATM是一种由NVIDIA推出的通用并行计算架构,该架构使GPU能够解决复杂的计算问题。

torch.cuda这个模块增加了对CUDA tensor的支持,能够在cpu和gpu上使用相同的方法操作tensor通过.to方法能够把一个tensor转移到另外一个设备(比如从CPU转到GPU)

可以使用torch.cuda.is_available()判断电脑是否支持GPU

1.PyTorch是相当简洁且高效快速的框架;2.设计追求最少的封装;3.设计符合人类思维,它让用户尽可能地专注于实现自己的想法;4.与google的Tensorflow类似,FAIR的支持足以确保PyTorch获得持续的开发更新;5.PyTorch作者亲自维护的论坛 供用户交流和求教问题6.入门简单

关于“Python中Pytorch怎么使用”这篇文章就分享到这里了,希望以上内容可以对大家有一定的帮助,使各位可以学到更多知识,如果觉得文章不错,请把它分享出去让更多的人看到。

亿速云「云服务器」,即开即用、新一代英特尔至强铂金CPU、三副本存储NVMe SSD云盘,价格低至29元/月。点击查看>>

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。